當我和AI一起做夢

TL; DR: 和AI一起做夢的過程中難免有幻覺。而幻覺打開了更多的可能。

四月中旬參加了Next New Wave 主辦的9天AI短片創作工作坊,每天學習怎麽和AI一起創作,更多的是和它一起做夢。

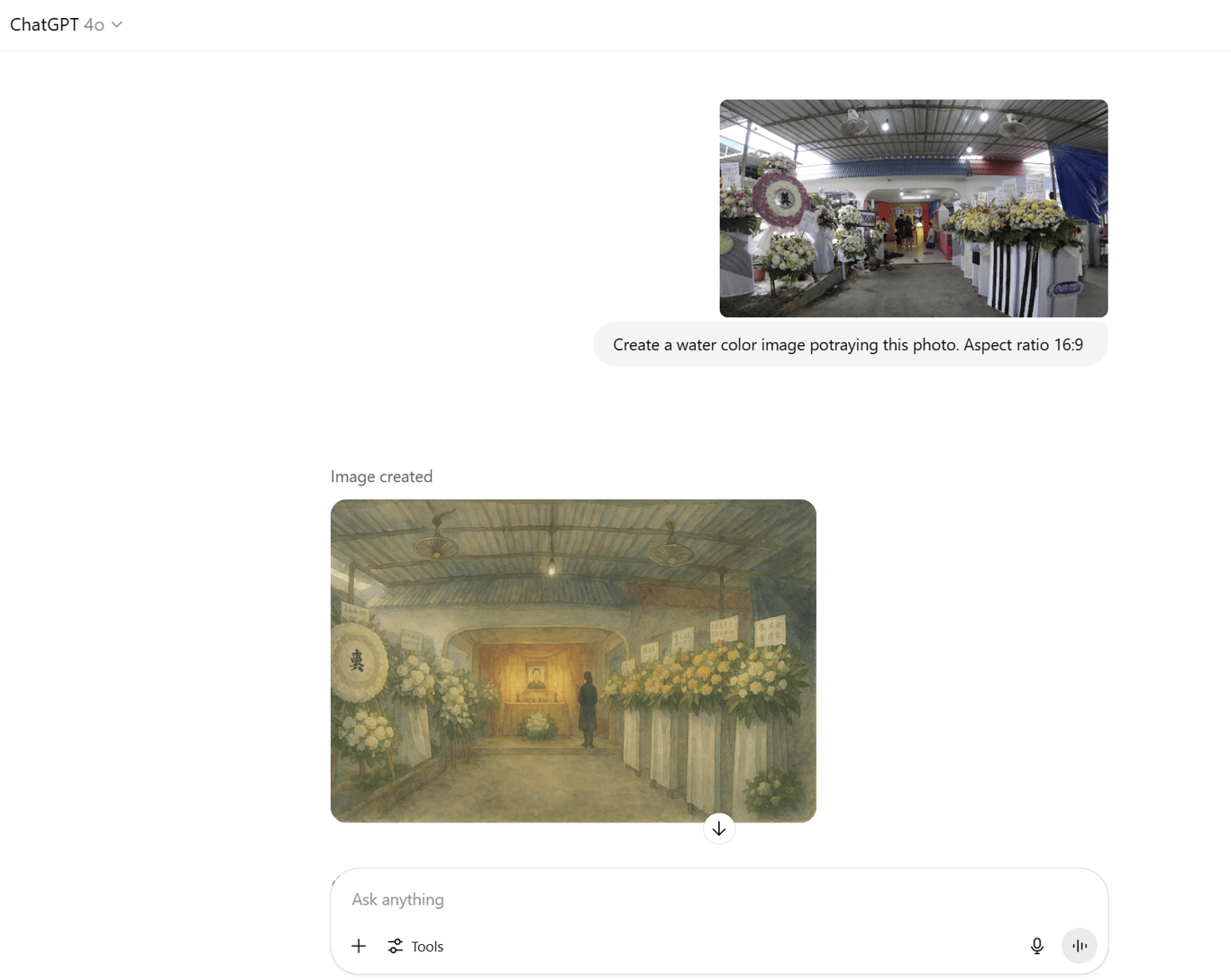

從一開始的覺得AI“不聽話”——就算是給了chatGPT照片,讓她轉化成水彩畫。無論照片多清楚,他還是會產生偏誤、產生幻覺——到覺得不聽話也很好。偏誤和幻覺打開了可能性。生成的圖片和影像因爲偏誤和幻覺,反而產生了新的敘事方式。

在影片的中間,本來純粹想zoom in阿嫲的手,可靈(KLING AI)卻錯把三張照片交曡在一起,成了故事的中心——阿嫲的手。

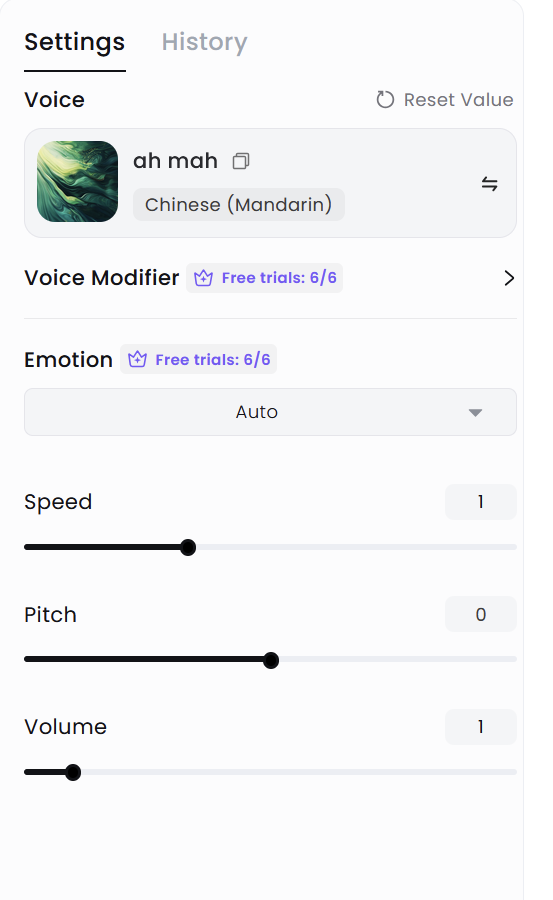

聲音也是如此。這次我用了AI (Minimax) 來克隆 (clone)聲音,再把之前寫的文章放進去轉換,讓它生成廣東話的聲音。因爲廣東話的用詞和華語不太一樣,就一邊生成一邊改。一開始一次生成一整段,但那樣一次就耗損太多credit。後來我就一句一句寫,一句一句改,有時候也反復調整pitch, 語速和聲音,讓語速和剪輯自然些。Minimax的界面不難用,也有很多Credit可以玩。

同時,導師們也介紹了Suno, 可以用來生成音樂。我試著讓它譜一首只有樂器,沒有歌聲的音樂,類似Beyond《真的愛你》的編曲,結果變成了這樣:

聲效方面用了Elevenlabs, 影片生成用了Vidu, 都有課金,算是學費。 Elevenlabs的聲效資料庫很大,只要描述夠精準,它都能提供近乎準確的聲效。

Vidu要升級才能生成8秒的圖像轉影片,平常只能生成4秒的,像素也不高。翠梅姐說,Vidu的負責人是有學過電影的,懂得電影的語言,鏡頭的移動,還有美學。比起Kling,確實Vidu用起來比較直觀和容易。因此,影片中除了zoom in手的部分,其它會動的,都是用Vidu生成的。由於AI的世界都是2D的,因此任務動起來時就會有各種變形,人物面容和服裝也難以統一調和。Consistency是最難的。

對了,影像是做成水彩畫的風格,或是medium。而水彩畫幾乎都是由舊照片生成的。

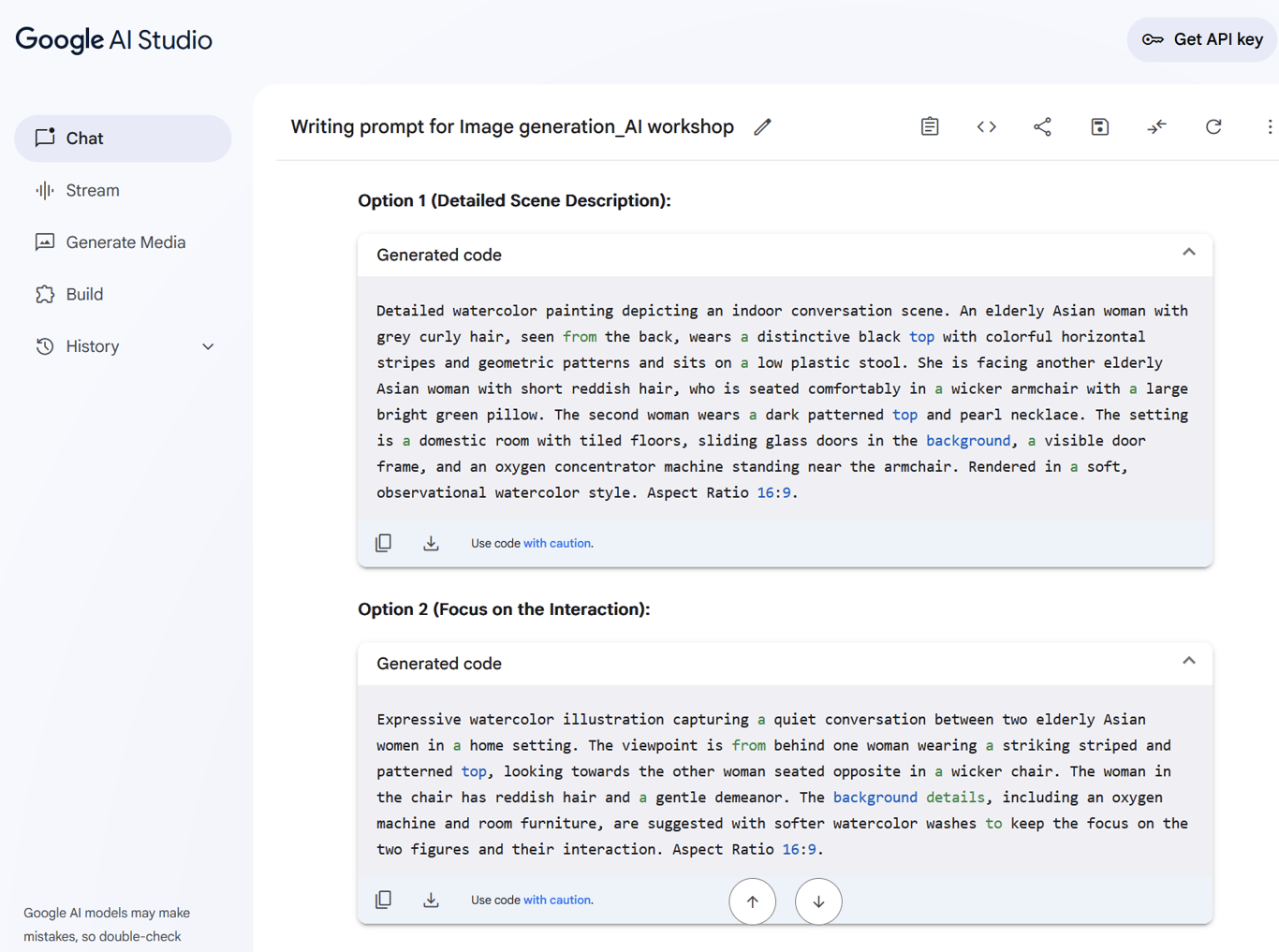

要怎麽把現實的照片描述給AI知道?我用了Google Studio來幫我描述:

爲什麽要用Google AI? 因爲我懶。一開始,我就貼了照片,請chatGPT換成水彩畫,就會得到這樣的結果:

教訓就是,我懶,AI會比我更懶。 翠梅姐說過,我們要把AI逼出comfort zone, 不能讓他偷懶。換言之,我們自己的思考也要跳出comfort zone, 不能懶。 這次的“手作”經驗也讓我理解到,語言要足夠精確,AI才會知道你要什麽。這樣合作才有可能。AI就像是collaborator這樣説很像很cliche,但卻實是如此。

完成後我意識到,AI其實也很耗神的,我上課上到第五天就投降了,體力和精神都沒辦法支撐下去。

又,這次的經驗讓我發現:我的聲音很好聼對聲音很敏感。還有,原來用sound design來撐起一個作品,是可能的。

以上。寫於阿嫲離去的六年整。

最後想回答一個問題:AI 會做夢嗎?會的。

如果你想,也可以一起做夢。

另外附上我喜歡的作品: