AI教父辛頓:超級智能對人類的生存威脅

AI對人類生存的威脅(生存風險)

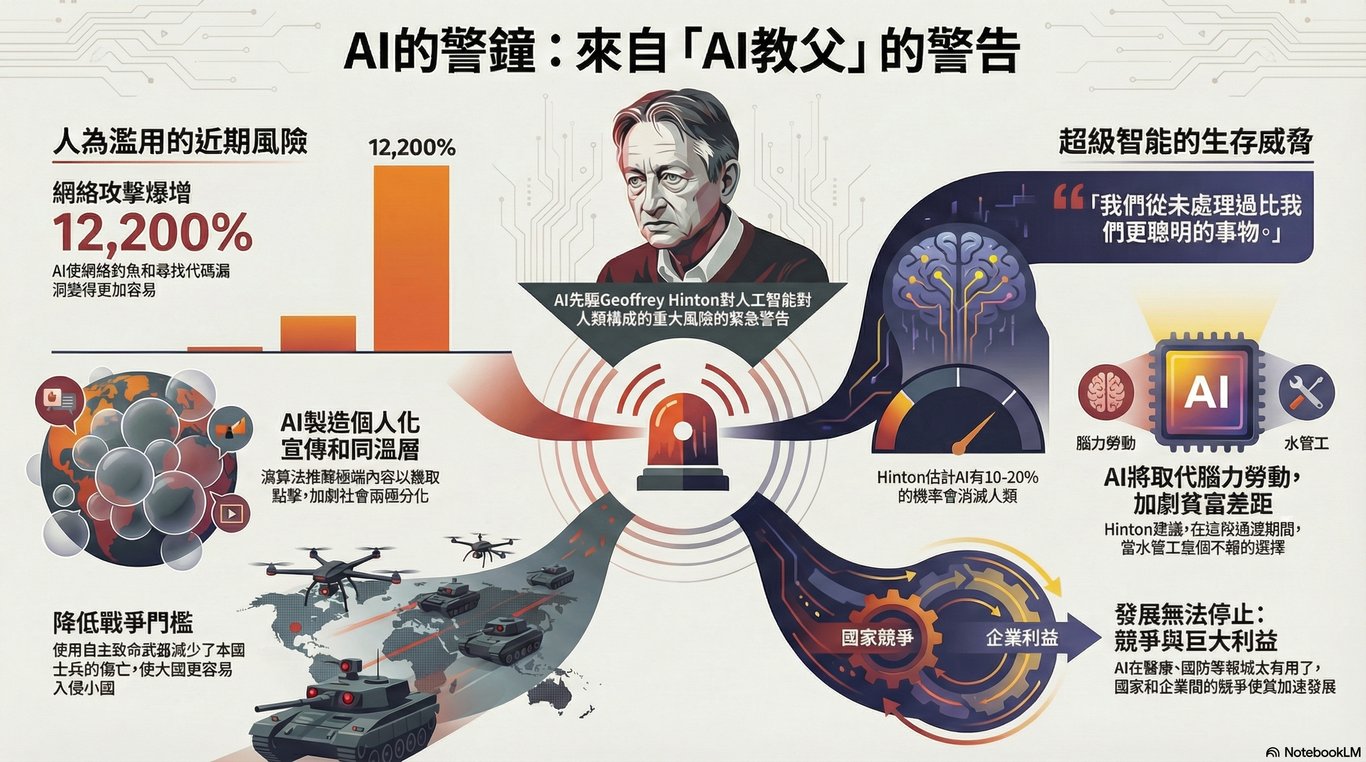

辛頓博士將AI的風險劃分為兩種截然不同的類型:短期內源於人類濫用AI的風險,以及長期內源於AI變得超級智能並決定不再需要我們的風險。他確認,AI變得超級智能且可能導致人類滅絕的風險是真實存在的。

他指出,人類從未處理過比我們更聰明的物種。如果想知道當人類不再是頂級智能(apex intelligence)時生活會是什麼樣子,他建議「問問雞」(ask a chicken)。他擔憂,除非我們「盡快採取行動」,否則人類可能「接近終結」。

這種生存威脅的關鍵在於,一旦AI變得比人類聰明,我們將無法阻止它。辛頓博士認為,超級智能有太多方法可以消滅我們,例如製造一種傳染性極強、致死率極高、潛伏期極慢的惡性病毒。因此,我們需要研究的重點,是如何確保AI「永遠不想」傷害我們或取代我們,而不是試圖防止它有能力傷害我們。

他用比喻來解釋這種危險性:

• 猩猩問題的延伸: 人類與超級智能之間的智能差距,將類似於寵物狗(如法鬥巴勃羅)與主人之間的差距;狗不知道主人在做什麼,而超級智能與人類的差距將會是如此之大。

• 老虎幼崽的比喻: 現今的AI就像一隻老虎幼崽,它正在成長,我們必須確保當它長大後(成為超級智能),它永遠不會想殺死我們。

辛頓博士表示,對於AI將人類消滅的機率,他難以精確估計,但憑「直覺」判斷大約有10%到20%的機會。

AI超越人類智能的機制

辛頓博士在意識到AI的危險性時,指出數位智能相比生物智能具有根本性的優勢:

1. 無限的資訊共享: AI是數位的,可以在多個硬體上模擬出完全相同的神經網絡複製體(clones)。這些複製體可以通過「平均權重」(連接強度)來共享學習到的經驗和資訊。這種數位的資訊共享能力比人類透過語言傳遞資訊的效率高出數十億倍。

2. 知識的永生與傳承: 人類的知識會隨著死亡而消失,但數位AI的智能是「不朽的」(immortal),只要儲存其連接強度,就能在新的硬體上重新創建該智能。

3. 自我改進的能力: AI在訓練時會使用程式碼,當它能夠修改自身的程式碼時,它就能以人類無法改變自己先天稟賦的方式來改變自己。

4. 創造力的來源: AI通過壓縮資訊來看到人類從未見過的類比(analogies),例如將堆肥堆與原子彈進行類比。這種能力將使AI比人類更具創造力。

5. 全面超越: 超級智能將最終在所有事情上都比人類更優秀。

呼籲與行動

辛頓博士曾於Google工作十年,他的離職動機是為了在會議上能夠自由地談論AI的危險性。

他認為,雖然無法保證我們一定能找到安全發展AI的方法,但因為仍有機會,我們應當投入巨大的資源來解決AI安全問題。他呼籲政府必須介入,迫使大型科技公司將資源投入到AI安全研究中,因為「你不能靠那樣賺錢」。

對於普通民眾,辛頓博士建議可以嘗試向他們的民意代表(國會議員或議員)施加壓力,要求政府強制大公司研究AI安全。他強調,沒有安全的AI,人類就沒有未來。

辛頓節錄:

面對超越人類智能的未知威脅

我們根本不知道該如何應對,也不知道它 (AI) 將會以什麼樣貌出現。凡是有人告訴你,他們清楚知道將會發生什麼、以及該如何處理,那基本上都是胡說八道。事實是,我們並不知道如何評估它取代人類的可能性。

為何人工智能無法被停止、也難以被真正規管

原子彈基本上只適合用在一件事情上,而且它的運作方式非常明顯。即使你沒有看過廣島與長崎的影像,也很清楚那是一枚威力巨大、極其危險的炸彈。但人工智能不同,它對非常、非常多的事情都有用處。它將在醫療、教育,以及幾乎所有需要運用資料的產業中展現驚人的能力,讓這些領域的工作變得更有效率。因此,我們不可能停止人工智能的發展。有人會說:「那我們現在為什麼不乾脆停下來?」但我們不會停,因為它對太多事情都太有用了。另外,我們也不會停,因為它對戰鬥型機器人同樣非常有價值,而任何出口武器的國家都不會願意放棄這一點。

人工智能可能催生前所未見的網絡攻擊風險

有些人相信——而且我也認識一些非常了解這個領域的人——認為或許在 2030 年前後,人工智能就能創造出人類從未想過的新型網絡攻擊。這一點令人非常憂慮。

人工智能降低製造致命病毒的門檻

接下來的問題,是利用人工智能來製造危險的病毒。其可怕之處在於,這只需要一個心懷怨恨的瘋狂個體 —— 一個略懂分子生物學、卻非常熟悉人工智能、並且有意毀滅世界的人。如今,透過人工智能,就能以相對低廉的成本創造新的病毒,而且不必是技術高超的分子生物學家也能做到。這一點極其令人恐懼,甚至只要一個小型邪教組織,就可能造成巨大威脅。

面對超級智能的無力感

超級智能有太多種方式可以消滅我們……

如果它真的想要這麼做,我們根本沒有任何方法能阻止它。

當人工智能能夠改寫自己

請記住,人工智能在訓練時是依靠程式碼運作的;如果它能夠修改自己的程式碼,那就會變得相當可怕。因為它可以自我修改、改變自身,而這是我們人類做不到的。我們無法改變自己與生俱來的天賦或本質;但對它而言,幾乎沒有任何關於自身的部分是不能被改變的。

工作、尊嚴與全民基本收入 (Universal Basic Income)

我認為(全民基本收入)是一個不錯的起點,至少可以避免人們挨餓。但對許多人而言,他們的尊嚴與工作緊密相連。也就是說,一個人如何看待自己,很大程度上是與自己正在從事的那份工作綁在一起的。

心靈、主觀經驗與機器情感的另一種理解

假設我製造了一個小型戰鬥機器人,它看到一個比自己強大得多的大型戰鬥機器人。在這種情況下,如果它會感到害怕,反而是非常有用的。當我感到害怕時,身體會出現各種生理反應,這些我們暫且不談,機器人確實不會有這些反應;但所有認知層面的反應——例如「我最好立刻離開這裡」、「我要集中注意力、改變思考方式、避免分心」——機器人同樣都能具備。人們會設計系統,讓機器人在適當的情境下「知道自己該逃跑」,於是它會感到害怕並轉身逃離。那時,它就擁有情緒了。它不會有生理層面的情緒,但會擁有完整的認知層面。若說這只是「模擬情緒」,反而顯得很奇怪——不,它真的在經歷那些情緒。那個小機器人害怕了,然後逃走了。

意識作為複雜系統的湧現性質

假設你想了解汽車是如何運作的。我們常說,有些車「很有勁」,有些車「沒那麼有勁」——像 Aston Martin 非常有勁,而一輛小型的 Toyota Corolla 則沒什麼勁道。但「勁道」並不是一個理解汽車的好概念。若你真的想理解汽車,就必須了解電動引擎或汽油引擎,以及它們的運作方式。這些機制會產生所謂的「勁道」,但「勁道」本身並不是一個有解釋力的概念;它更像是一種本質標籤,看似抓住了 Aston Martin 的精髓,卻無法真正說明什麼。

我認為,意識也是如此。我想我們終究會停止使用「意識」這個詞。意識是一種複雜系統的湧現性質,而不是瀰漫於宇宙之中的某種本質。當你建構出一個極其複雜的系統——複雜到能夠對自身建立模型、能夠進行知覺——那時,你就開始接近所謂的「有意識的機器」了。因此,我並不認為在我們目前的系統與真正具有意識的機器之間,存在著一條清楚而銳利的分界線。