邁向通用人工智慧(AGI)的「缺失層」:大語言模型如何學會推理?

"The Missing Layer of AGI: From Pattern Alchemy to Coordination Physics"

Edward Y. Chang

arxiv.org/abs/2512.0...

一、這篇論文在解決什麼問題?

這篇名為〈The Missing Layer of AGI〉的論文,試圖回應一個近年人工智慧領域中非常核心、也非常爭議的問題:大型語言模型(如 ChatGPT)究竟只是「高級文字接龍機」(pattern matchers),還是有可能成為通用人工智慧(AGI)的基礎。許多批評者認為,語言模型本質上只是根據統計機率預測下一個字,並不真正理解世界,也不具備推理、規劃或自我修正的能力,因此不可能走向真正的智慧。作者並不否認這些模型目前確實存在大量錯誤與幻覺,但他認為,這些失敗並不能直接推論出「語言模型是死路」。在他看來,整個爭論的問題不在於模型「只會模式配對」,而在於我們把「模式庫本身」誤當成了「完整的智慧系統」,卻忽略了一個關鍵但缺失的層次。

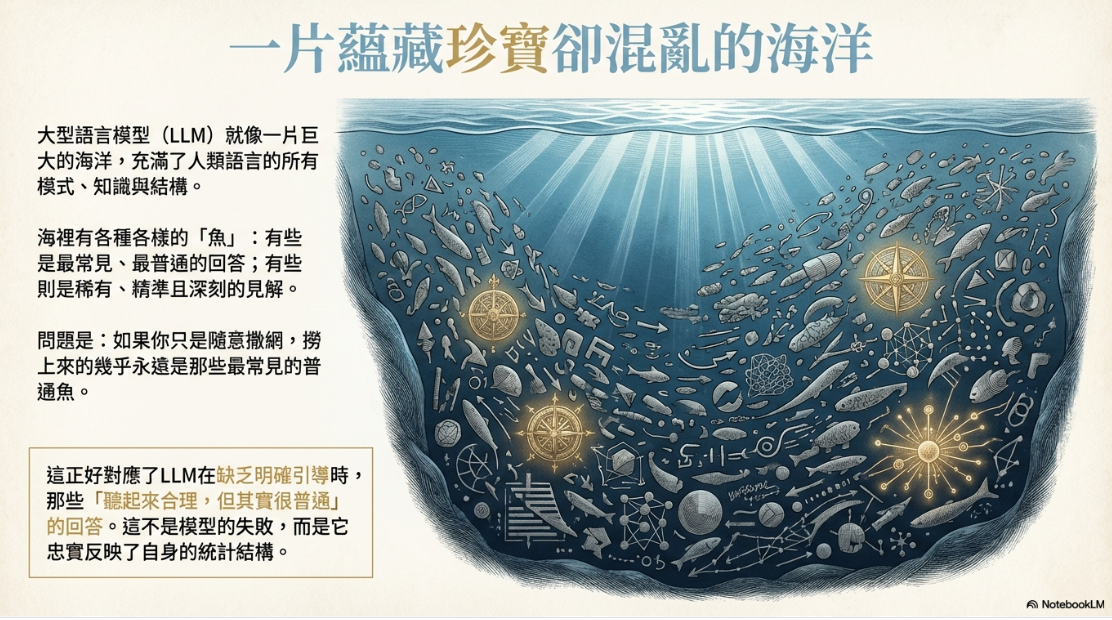

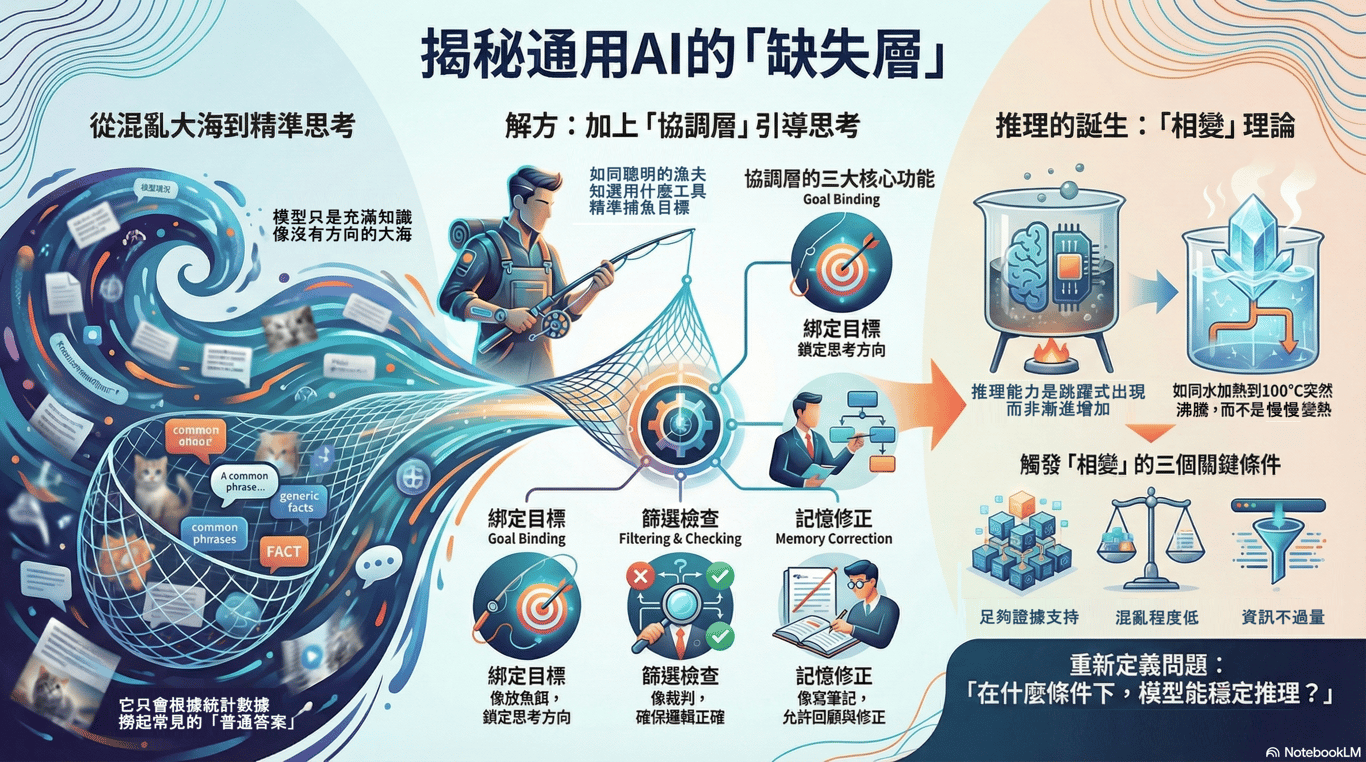

二、一個關鍵比喻:大海、漁網、魚餌

為了讓一般人理解他的觀點,作者使用了一個非常直觀的比喻。他把大型語言模型比作一片巨大的海洋,海裡充滿各式各樣的魚。這些魚代表模型在訓練過程中學到的所有語言模式、知識結構與常見回答。其中,最常見、最普通的魚數量最多,而真正稀有、有針對性、需要精準理解才能抓到的魚則非常少。如果你只是隨意把漁網丟進海裡,沒有放魚餌,也沒有設計網子的密度,那麼撈上來的幾乎一定是那些最常見的魚。這正好對應到語言模型在缺乏明確目標與約束時,所產生的那些「聽起來合理、但其實很普通」的回答。作者強調,這並不是模型出錯,而是它忠實地反映了自身的統計結構。真正的智慧行為,不只是撒網,而是知道什麼時候該放魚餌、放多少、用多密的網,並且判斷值不值得再嘗試一次。

三、什麼是「協調層」?用白話說

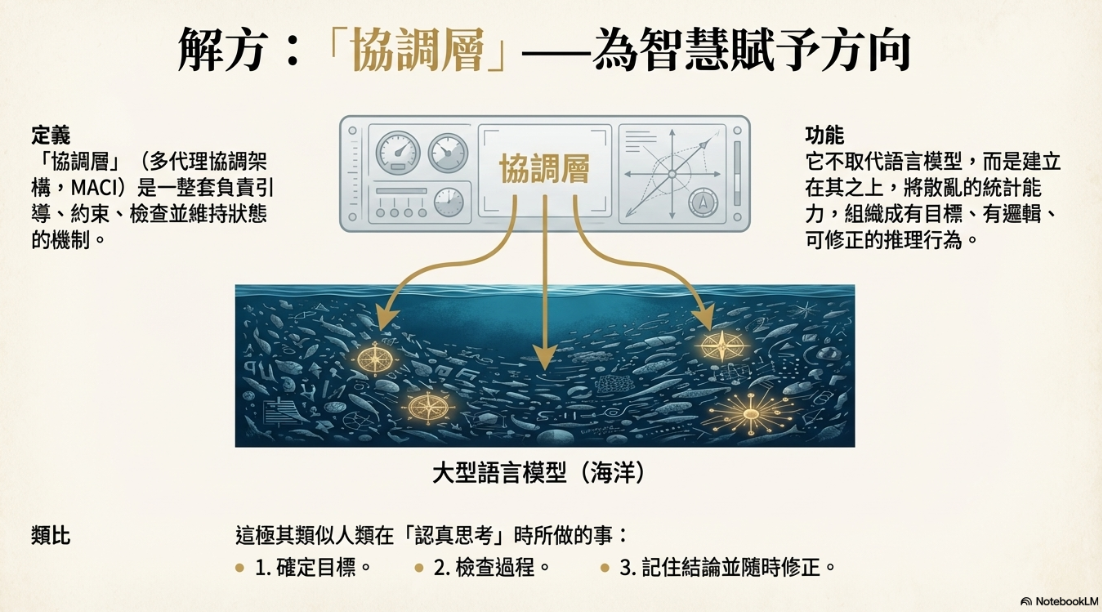

在作者的理解中,大型語言模型本身並不是「不聰明」,而是「沒有方向感」。它像一個反應極快、記憶力驚人、但不知道此刻該做什麼的系統。你問什麼,它就依照最可能的路徑往下接,但它不會自己判斷「這次回答是不是該更謹慎」、「是不是需要查證」、「是不是前後矛盾了」。因此,作者提出「協調層」這個概念,用來指一整套負責引導、約束、檢查並維持狀態的機制,名為「多代理協調架構」(MACI)。協調層不是取代語言模型,而是建立在語言模型之上,讓原本散亂的統計能力,能被組織成有目標、有邏輯、可修正的推理行為。

協調層做的事情,其實非常像人類在「認真思考」時所做的事。它會先確定目標是什麼,再檢查過程中有沒有出錯,最後還會記得自己之前怎麼想過,必要時回頭修正。作者特別指出,沒有這一層,語言模型就只能停留在「看起來很會說話」的層次,而很難穩定地表現出真正的推理能力。

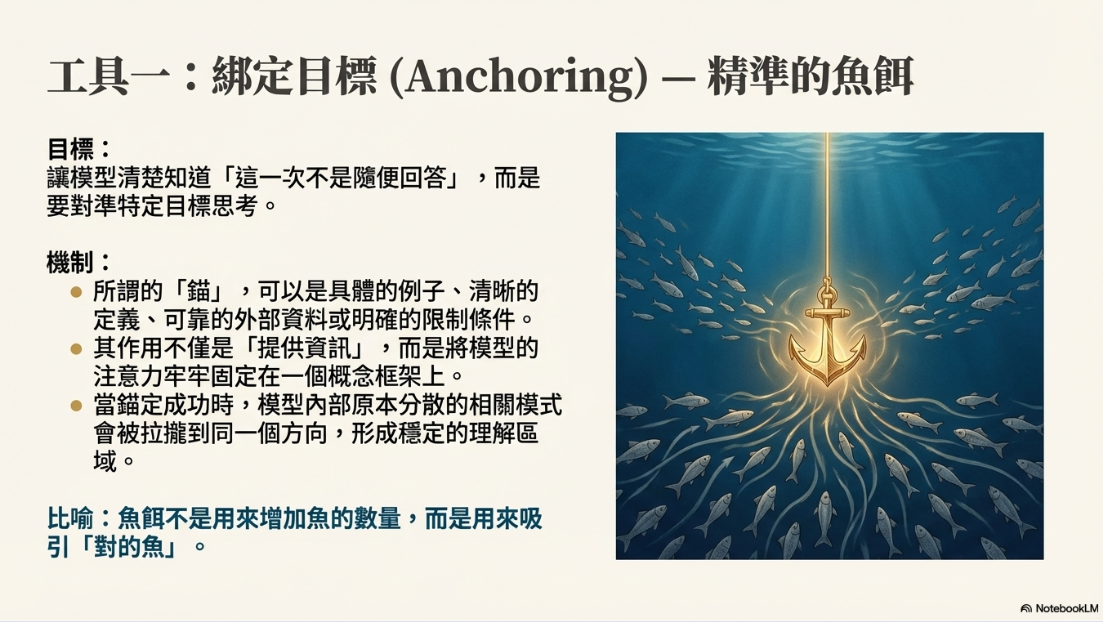

1. 綁定目標(Anchoring)

協調層的第一個核心功能,是「綁定目標」,作者稱之為 Anchoring。用最簡單的話說,就是讓語言模型清楚知道:這一次不是隨便回答,而是要對準某一個特定目標來思考。如果沒有這個綁定,模型就會自然地滑向它最熟悉、最常見的回答方式,也就是訓練資料中機率最高的那條路。

所謂「錨定」,可以來自很多形式,例如具體的例子、清楚的定義、可靠的外部資料、工具運算的結果,或明確指出的限制條件。這些東西的作用,不是單純「給資訊」,而是把模型的注意力,牢牢固定在某一個概念或問題框架上。作者用「放魚餌」來形容這件事:魚餌不是用來增加魚的數量,而是用來吸引對的魚。當錨定成功時,模型內部原本分散的相關模式,會被拉攏到同一個方向,形成一個相對穩定的理解區域。

2. 篩選與檢查(Filtering & Judging)

即使目標已經綁定,語言模型仍然可能產生看似合理、實際卻有問題的內容。因此,協調層的第二個功能,是篩選與檢查。這一層的重點,不在於「回答漂不漂亮」,而在於「推理合不合理」。它會檢查生成的內容是否前後一致,有沒有偷換定義,有沒有用模糊語言掩蓋關鍵問題,或是在沒有證據的情況下做出過度肯定的結論。

作者特別強調一種「審查者」或「裁判」的角色,負責用類似蘇格拉底式提問的方式,逼使推理變得清楚而可檢驗。這個角色不是站在某一個立場,而是專門阻止那些「聽起來很順、但其實沒有說清楚」的說法進入最終結論。換句話說,協調層不是要讓模型更自信,而是要讓模型在該懷疑的地方願意停下來。

3. 記住並修正(Memory & Persistence)

協調層的第三個關鍵功能,是記憶與持續性。一般的語言模型,在每一輪對話中其實都很容易「失憶」:前面說過什麼、犯過什麼錯、做過什麼承諾,常常無法被可靠地保存與追蹤。作者認為,真正的推理與規劃,必須建立在可以回顧與修正的記憶之上。

因此,協調層需要能夠記住中間結論、推理過程與先前的假設,並在發現矛盾或新證據出現時,允許系統回頭修正,而不是硬撐原本的說法。這讓整個系統不再只是一次性的文字生成,而是具備「持續思考」的能力。從人的角度來看,這就像是真正的反省與修正:不是每一句話都當成最終答案,而是把思考視為一個可以反覆調整的過程。

四、作者提出的核心機制:像「物理相變」

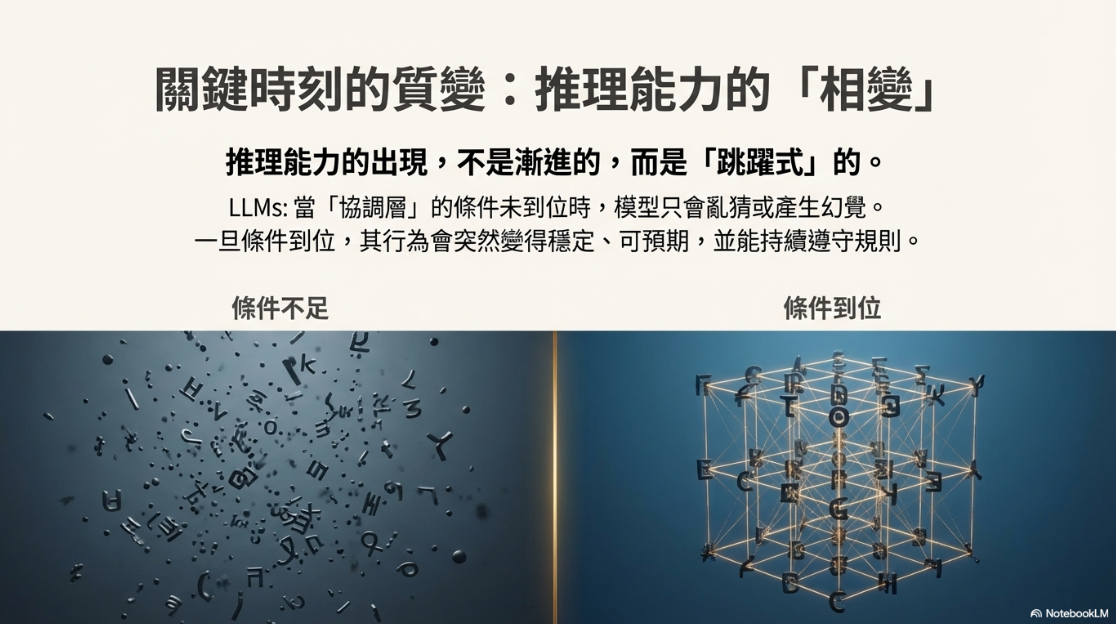

1.推理不是慢慢變聰明,而是突然「跳過去」

這篇論文最重要、也最獨特的主張之一,是作者認為「推理能力的出現,不是漸進的,而是跳躍式的」。他借用了物理學中的「相變(phase transition)」概念來說明這一點。

2.什麼是「相變」?用生活例子來看

所謂相變,指的是一個系統在某個臨界點之前,看起來只是數量上的變化,但一旦跨過那個點,整個狀態會突然改變。水在九十九度時仍然是水,但一到一百度就會開始沸騰;鐵在某個溫度以上沒有磁性,但一旦低於臨界溫度,就會突然變成磁鐵。

3.語言模型也是一樣:卡在門檻前 vs 跨過門檻後

作者認為,語言模型在有沒有被「正確錨定」時,行為表現也呈現出同樣的特性:在條件不足時,看起來只會亂猜或產生幻覺;但一旦條件到位,行為就會突然變得穩定、可預期,而且能持續遵守目標與規則。

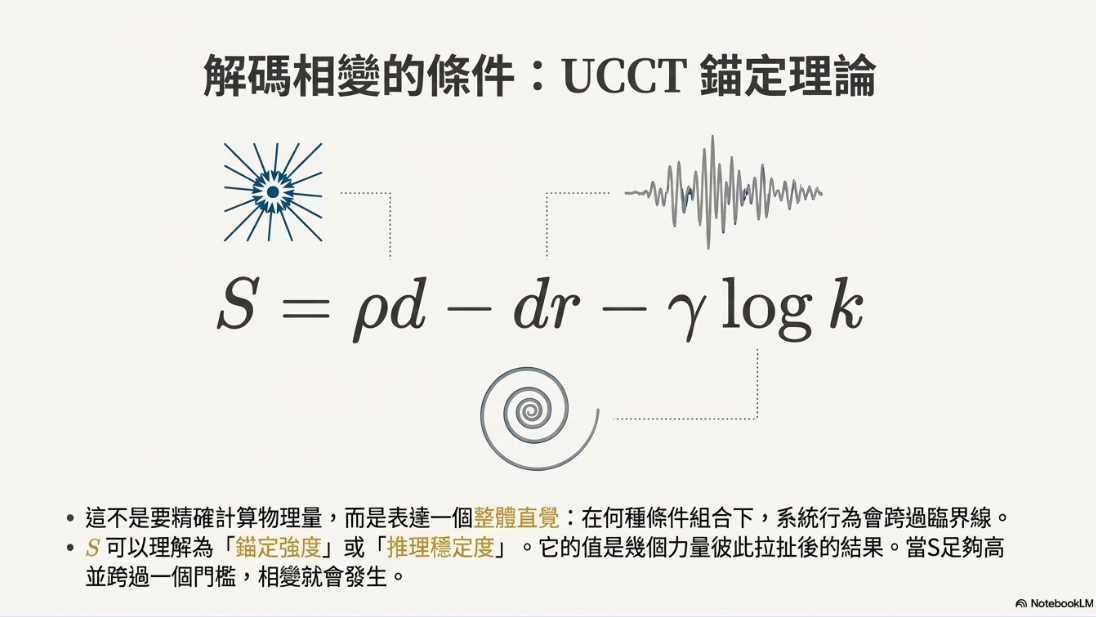

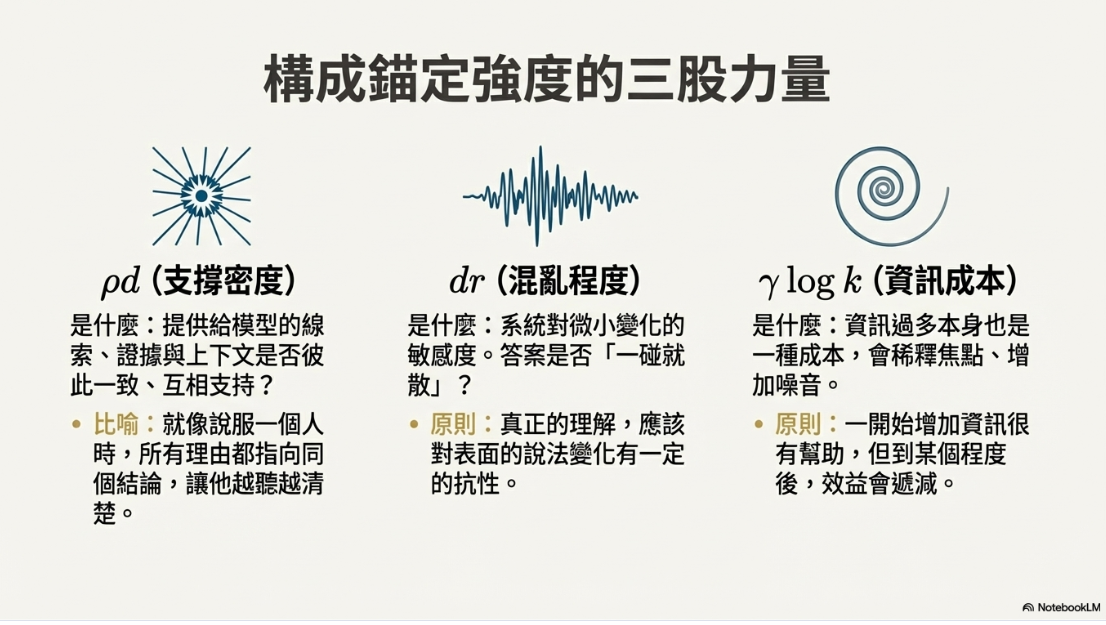

五、用人話解釋那個公式在說什麼

1. 公式

作者為了描述「什麼時候語言模型會突然變得像是在真正推理」,提出了UCCT 錨定理論(Unified Contextual Control Theory)的公式:

S = ρd − dr − γ log k

這個公式並不是要精確計算什麼物理量,而是用來表達一個整體直覺:在某個條件組合之下,系統的行為會跨過一條臨界線,從不穩定、容易亂猜的狀態,切換成相對穩定、目標導向的推理狀態。S 可以被理解為「錨定強度」或「推理穩定度」,它不是單一因素造成的,而是幾個力量彼此拉扯後的結果 :

支撐夠不夠(ρd)

公式中的 ρd,作者用來表示「支撐密度」,也就是目前提供給模型的線索、例子、證據與上下文,是否彼此一致、互相支持。如果這些資訊都在指向同一個概念或結論,模型內部就會形成一個穩定的理解區域,讓推理比較不容易偏斜。相反地,如果線索彼此衝突,或只是零碎地散落在不同方向,即使資訊很多,支撐密度仍然很低,模型也就很難站得住腳。

用日常經驗來說,這就像你要說服一個人,如果你給他的理由彼此呼應,他會越聽越清楚;但如果每個理由都在講不同的事,他反而會越聽越混亂。ρd 描述的正是這種「是不是站在同一條線上」的程度。

混亂程度高不高(dr)

dr 代表的是不穩定或混亂程度,指的是系統對微小變化的敏感度。如果只要稍微改一下問題的說法、調整一下次序,整個答案就立刻翻轉,這就表示推理其實並沒有穩定結構,而只是剛好踩到某個機率高的路徑。這種情況下,看起來像是在回答問題,實際上卻非常脆弱。

作者特別在意這一點,因為真正的理解,應該對表面變化有一定的抵抗性。換句話說,如果你真的懂一件事,不會因為換個問法就完全不會回答。dr 越高,代表這種「一碰就散」的情況越嚴重,也就越難出現穩定的推理行為。

資訊是不是多到成干擾(γ log k)

γ log k 這一項,乍看之下很複雜,其實講的是一件很生活化的事:資訊過多本身也是一種成本。k 代表投入的資訊量,例如上下文長度、範例數量或文件數量等等,而 γ 則表示系統對「資訊爆炸」的敏感程度。當資訊量增加時,並不是每一條都在幫助推理,有些反而會稀釋了焦點,增加噪音。

作者用對數(log)來表示這個成本,是在暗示:一開始增加資訊確實很有幫助,但到某個程度之後,效益遞減,甚至開始反效果。這也解釋了為什麼有時候「多給一點說明」反而讓模型更容易亂掉,因為協調層來不及消化這些訊息。

2. 作者想表達的是...

把整個公式合起來看,作者真正想說的並不是數學關係,而是一個結構性的判斷:當一致的支撐足夠強、混亂程度被壓低、而資訊量又沒有多到失控時,系統就會跨過一個臨界點,行為出現質變。在臨界點之前,語言模型看起來像是在亂猜或套話;一旦跨過去,推理就會突然變得穩定、可預期,而且能持續遵守目標與約束。

這正是作者所說的「相變」。推理不是慢慢多一點點,而是當條件齊備時,整個運作模式切換了。這個公式的價值,不在於精算,而在於提醒研究者:與其爭論模型「本質上會不會思考」,不如認真設計那些能讓系統跨過臨界點的條件。

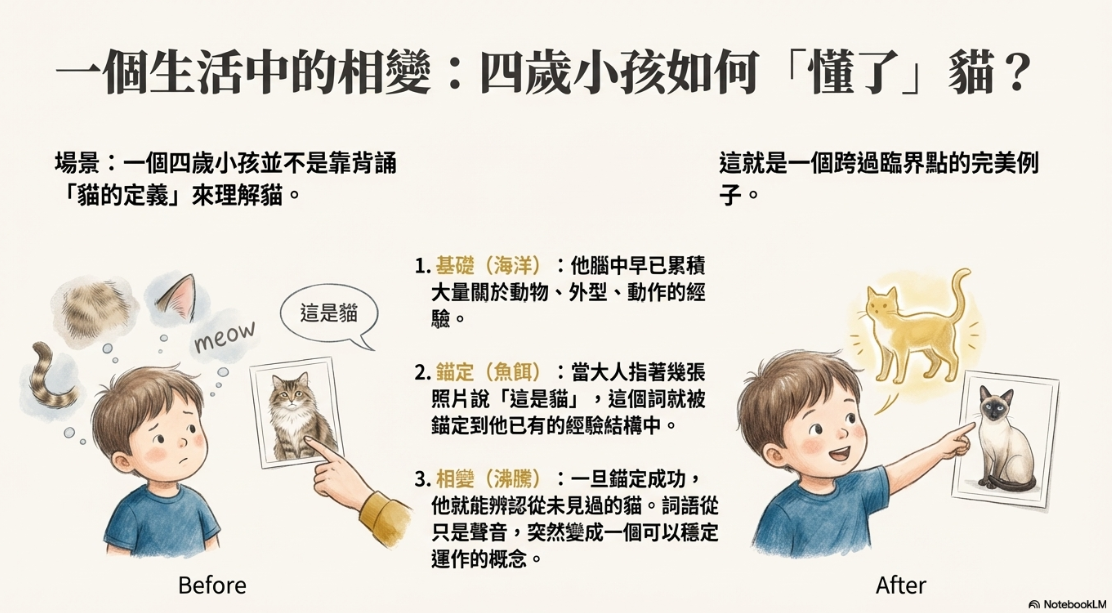

六、為什麼四歲小孩看幾張貓照片就「懂了」?

為了讓這個抽象理論更容易理解,作者舉了一個非常生活化的例子:四歲小孩學會什麼是「貓」:小孩並不是靠背誦定義來理解貓,而是因為他早已累積了大量關於動物、外型、動作與聲音的經驗。當大人給他看幾張貓的照片,並告訴他「這是貓」,這個詞就被錨定到他原本就存在的一整片經驗結構中。一旦錨定成功,他就能辨認從未見過的貓,而且判斷會變得非常穩定。這正是一個跨過臨界點的例子:在那之前,詞語只是聲音;在那之後,它突然變成一個可以穩定運作的概念。

七、一句話說明作者真正的主張

作者真正想說的一句話是:大型語言模型不是通用人工智慧的終點,也不是錯誤的方向,它們是必要的基礎,但真正缺少的,是一個能夠錨定目標、協調推理、檢查錯誤並維持狀態的系統層。

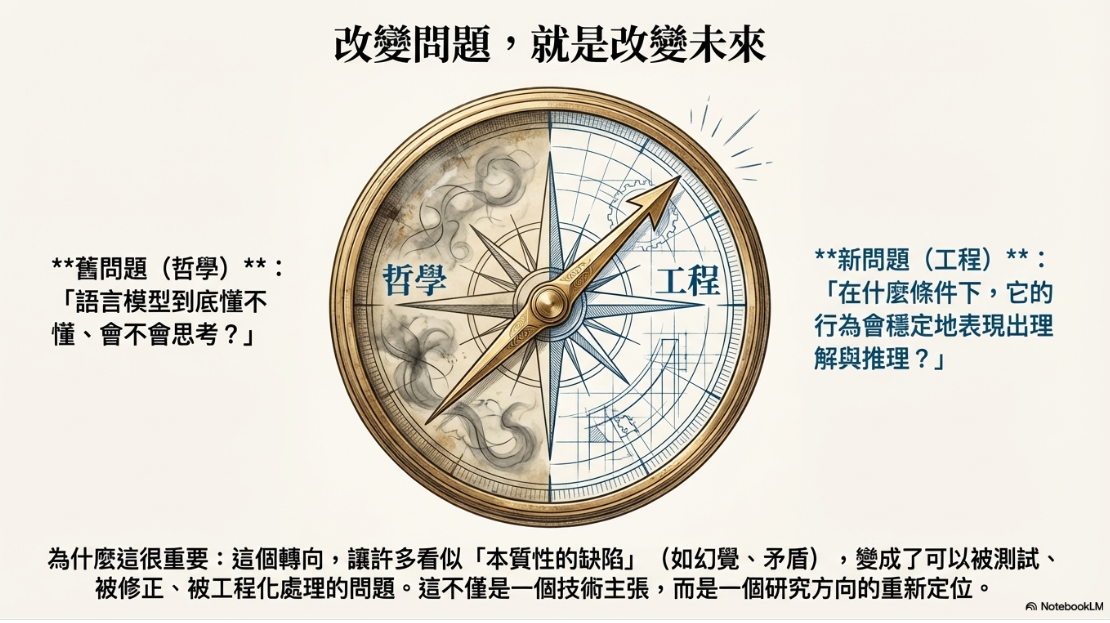

八、為什麼這篇文章重要?

這篇文章之所以重要,不只是因為它為語言模型辯護,而是因為它徹底改變了問題的問法。與其一直問「語言模型到底懂不懂、會不會思考」,作者建議我們改問:「在什麼條件下,它的行為會穩定地表現出理解與推理?」這樣的轉向,讓許多看似「本質性的缺陷」,變成可以被測試、被修正、被工程化處理的問題。也正因如此,這篇論文不只是技術主張,而是一個研究方向的重新定位。

PowerPoint: