【長片】John Vervaeke - What AI Can Never Be

最近才被貼的影片(2025年5月),不止是關於AI而是甚麼是智能(intelligence)

影片簡介

Can artificial intelligence truly become wise?In this landmark lecture, John Vervaeke explores the future of AI through a lens few dare to examine: the limits of intelligence itself. He unpacks the critical differences between intelligence, rationality, reasonableness, and wisdom—terms often used interchangeably in discussions around AGI. Drawing from decades of research in cognitive science and philosophy, John argues that while large language models like ChatGPT demonstrate forms of generalized intelligence, they fundamentally lack core elements of human cognition: embodiment, caring, and participatory knowing.By distinguishing between propositional, procedural, perspectival, and participatory knowing, he reveals why the current paradigm of AI is not equipped to generate consciousness, agency, or true understanding. This lecture also serves as a moral call to action: if we want wise machines, we must first become wiser ourselves.

人工智能能真正變得有智慧嗎?

在這場具有里程碑意義的演講中,John Vervaeke 透過一個鮮少有人敢探討的角度,即智慧本身的極限,探討人工智能的未來。他闡明了智能、理性、合理性和智慧之間關鍵的差異,這些詞語在討論人工通用智能(AGI)時經常被互換使用。基於數十年認知科學和哲學研究,John 認為,雖然像 ChatGPT 這樣的大規模語言模型展示了通用智能的形式,但它們根本缺乏人類認知的核心元素:體現、關懷和參與性知覺。

通過區分命題性、程序性、觀點性和參與性知覺,他揭示了當前人工智能模式為何無法產生意識、代理或真正理解。這場演講也作為一項道德行動號召:如果我們想要有智慧的機器,我們必須先讓自己變得更有智慧。

連結

頻道John Vervaeke - www.youtube.com/chan...

Youtube影片連結 - youtu.be/HAJclcj25uM

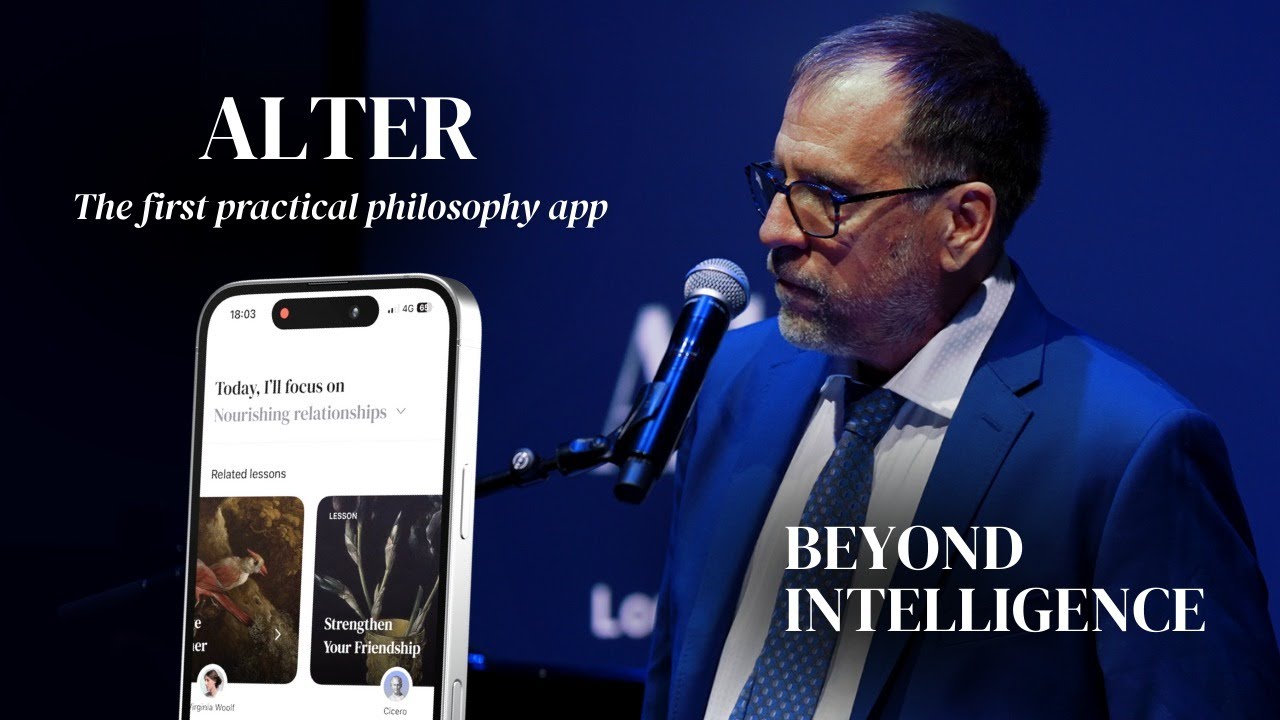

文中提到的Alter應用程式官網:meetalter.com

Youtube影片

全部內容

所以,正如丹尼斯所說,我會確保我的介紹清晰明確,因為我有機構忠誠。我來自多倫多大學。Jeff Hinton就是從那裡來的。Jordan Peterson也是。Keith Stanovich也是。是的,所有的知識和真理都來自多倫多大學。

我從事認知心理學(cognitive psychology),也是認知科學(cognitive science)。我曾是該領域的主任。我將那個認知科學項目視為我的孩子。我有哲學博士學位,我在認知科學工作中的一個重要部分實際上是認知哲學。

所以這就是我的背景和工作。我曾在多倫多大學教書,和Jeff Hinton一起教導了許多學生,他們進入世界並使許多可能性成為現實。正如你們中的一些人知道的,Jeff辭去了工作,以便他能談論人工通用智能(AGI)的危險。

我想和Jeff談談他對人類的看法,他正在通過他的道德承諾努力保護人類。但我現在先不談這個。

我想和你們討論的是人工智能(AI)和智能(intelligence)、人工智能和理性(rationality)、人工智能和合理性(reasonableness)、人工智能和智慧(wisdom)。我希望澄清的是,智能並不等同於理性、合理性和智慧。這有深刻的原因。

讓我們從人工智能和智能開始。好吧,正如你們無疑知道的,人們現在在談論人工通用智能(AGI, artificial general intelligence)。我已經談論通用智能有兩個世紀了,並一直說這是我們在人工智能領域需要的,即人工通用智能。那麼,這意味著什麼?好吧,你擁有通用智能。這意味著你可以以各種方式在各種領域內解決各種問題,為各種目標而努力。因此,你可以學習網球,可以了解阿爾巴尼亞錫的生產,可以探究澳大利亞的歷史,並可以思考這些之間是否有任何可能的聯繫,而你經常這樣做。

我們討論的是通用智能,因為這是人們所聲稱的,或者至少聲稱這是我們正在大型語言模型(LLM)中實現的目標。我將稱這些模型為大型語言模型,例如ChatGPT、DeepSeek等。顯然,還有其他潛在的AGI版本。我不能面面俱到,因為它們目前佔據了主要的討論空間。

所以,讓我們來問一個關於通用智能的問題,但我們要非常、非常小心,因為關於通用智能有兩個經常被混淆的問題,我們應該仔細區分它們。一個問題是,LLM是否能夠解決各種領域的各種問題。畢竟,這正是我剛才所說的通用智能的全部內容。答案是肯定的,但具體的方式和知識類型是特定的。我稍後會討論不同類型的知識和不同的知覺方式,因為我們傾向於過度強調一種知覺方式,而忽視了對我們認知能力至關重要的其他方式。

所以在這個意義上,我們已經有了一個初步的答案。是的,它們可以做到這一點。這是一個重大的成功,順便說一句。在GPT-3.5、GPT-4出現之前,人工智能(AI)還沒有達到AGI的水平,它面臨著所謂的「儲存室問題」(silo problem)。人工智能只能在非常有限的領域內解決問題。它可以稍微進行歸納。它或許可以玩好一些遊戲,但它無法學習如何打網球之類的事情。所以這就是儲存室問題。大型語言模型(LLM)出人意料地取得的一個成果是,它們似乎突破了儲存室的限制。你可以問ChatGPT關於這個領域或那個領域的問題,它都能回答。這確實令人印象深刻。我不想貶低這個成就。這是一個重大的成就。

但是,我也想將這個成就放到正確的背景下。我們是不是取得了科學上的進步?我們是不是得到了對智能本質的理論解釋,可以將其推廣到其他智能生物身上?我們能不能從LLM的學習和工作方式中了解到使我們變得智能的因素,或者使一個無可爭議地非常有智能的生物(如黑猩猩、新喀里多尼亞烏鴉或章魚)變得有智能的因素?看,這就是科學理論的標凖。它必須對它試圖解釋的現象進行歸納。ChatGPT獲得能力的方式沒有什麼可以歸納為對黑猩猩智能的解釋。你無法從LLM的工作方式推斷出黑猩猩也是這樣變得智能的。

現在,這非常關鍵。看,我一直以來的一個重要希望,也是我教給學生的東西,就是我們將通過對智能本質的科學解釋來實現人工智能。我最大的恐懼是,我們得不到這樣的解釋,但我們會以一種混亂的方式製造出一台可以在多個領域做許多不同事情的機器。我的希望破滅了,我的恐懼成為了現實,這當然是人類悲劇的一部分。

當我們以科學的方式提出「什麼是智能」這個問題時,我們必須採用不同的方法。他們所說的通用智能是指你在任何一個領域的表現。這可以追溯到1926年由Spearman發現的現象,即它可以很準確地預測你在其他許多領域的表現。LLM目前還不具備這種能力,但它們正在朝這個方向發展。

然後你必須說,好吧,一定有一些通用能力可以解釋你在藝術、數學和體育等領域為什麼能表現出色。順便說一句,這些領域的表現是相互預測的,與好萊塢告訴你的不同。它們相互預測。如果你在其中一個領域表現出色,那麼你在其他領域表現出色的可能性也很大。這也是我們必須放棄的文化智能觀念之一。因為這些觀念過去是誤導性的,現在甚至是危險的。

所以你必須問的是,「好吧,這種通用能力是什麼?」我和其他一些人一直主張的觀點是,通用智能反映的是解決兩個相互交織(interlocking)的元問題(meta-problems)的能力。作為一名學者,我必須在某個時候使用「元」(meta)這個詞。那麼我所說的元問題是什麼呢?元問題是指在嘗試解決任何更具體問題時,你必須解決的問題。所以當我嘗試解決這個問題時,我必須解決這兩個元問題,或者當我面對這個問題時,我必須解決這兩個元問題。這有道理嗎?這就是它成為通用能力的理由,因為它適用於你所有的問題解決過程。

現在,這兩個通用元能力是什麼?一個是你的預期能力(capacity for anticipation)。Michael Levin將此稱為你的認知光錐(cognitive light cone),即你可以多深多細地預見未來。你知道這與智能有關係,因為人們經常可靠地直觀地使用這個能力來判斷其他生物的智能,例如。這就是為什麼你認為你的狗比青蛙更聰明,因為你知道你的狗可以以比青蛙更廣闊和詳細的方式預測世界。我們有一個正在興起的框架,它在認知科學中變得非常有力量,用於解釋這種能力。它被稱為預測處理(predictive processing),我稍後會詳細講解。

第二個解決元問題的通用能力是相關性認識(relevance realization)。我已經在研究這個問題三十多年了。這就是這個問題。好吧?信息量太大了。我們認為,哦,我需要收集更多信息。現在,我要對你說一句聽起來像禪宗公案的話。你之所以聰明,是因為你能夠忽略大量信息。

想想這個房間裡你可以注意到的所有事物和所有不同的模式。我可以注意她頭頂、他的腳趾、那個。那是一個模式。我可以注意這個的周長、那個的長度,以及它有多暖和。這個房間裡的信息量,只是這個房間,是組合爆炸的。好吧,所以你必須忽略其中的大部分。但這裡有個問題。你不能隨機或任意地忽略它,否則你就會死。你以某種方式忽略了大部分信息,並專注於你應該注意的相關信息。

但你在記憶方面也面臨著同樣的問題。你知道你的大腦中存儲了多少信息,以及所有可能的組合嗎?你不能以這種方式搜索你的記憶。在回憶時,你忽略了大部分記憶。但以某種方式,你檢索了相關的信息。你可以考慮的可能性、行動的序列。這太令人難以置信了。你現在正在這樣做。在你注意的所有事物、你可以回憶起的所有事物、你可以考慮的所有可能性、你可以採取的所有行動中,你專注於要做什麼,你正在這裡、現在這樣做。這就是核心。

這兩個問題是相互交織的,因為你越是試圖預測世界,就越能意識到適應性。你想預測老虎還是與老虎戰鬥?你想預測三文魚在哪裡,還是只是遇到它們?你想預測冬天,還是只是經歷它並忍受它?但你打開預測空間的越大,相關性認識問題就越複雜。它以非線性的方式增加,以指數級的速度增加。這兩個問題是相互交織的。你現在正在解決這兩個問題,並調整你的認知光錐,專注於相關性,突出一些事物,淡化其他事物,忽略其他事物。有些事物很突出,吸引你的注意力。其他事物,比如你的左大腳趾,在我提到之前對你來說並不突出。

好吧?這是一個非常動態、非常複雜、多層次的過程。研究預測處理和相關性認識以及它們如何相互交織的人們正在制定理論,旨在解釋人類、黑猩猩、章魚、新喀里多尼亞烏鴉的智能,並收集必要的實證證據來證實它們。

那麼,如果我們提出關於通用智能的第二個問題,即科學問題,我們可以問,LLM有預測能力嗎?它們有預測處理能力嗎?它們有相關性認識能力嗎?現在我們可以——看,我作為老師所做的事情——我讓你們能夠提出更精確的問題。而不是問一個模糊且混亂的問題,「它們有智能嗎?」我們首先將「它可以做很多事情」的意義與「它與科學解釋的聯繫」分開,然後基於這個問題,我們可以提出具體問題。好吧,太好了。

LLM從其預測能力中獲得大量力量。這正是它們所做的事情。它們對下一個術語做出概率預測。我指的是像「術語」這樣的術語。我們也缺乏關心,我們說,它們預測詞語。詞語這個詞是歧義的。它可以是指字母序列,也可以是指對你有意義的東西。它們正在做前者。它們正在預測「貓」(C-A-T)出現的概率,前提是「狗」(D-O-G)已經出現。你明白了嗎?所以它們具有非常複雜、非常快速的預測能力。從這個意義上講,它們具有一些預測能力。但我們,再次地,現在我們有了更精確的問題,我們可以,我們可以,我們可以,抱歉這個諷刺,我們可以進一步引導問題。

看,因為它們所做的一切都是預測文字領域內的內容。現在,文字對你來說是基本透明的。心理學中最受研究的影響之一被稱為Stroop效應。我沒有開玩笑,Stroop效應的研究超過了一千項。如果你想去心理學系,你必須了解Stroop效應,對吧?所以我會給你一堆詞語。它們是顏色詞語,比如「紅」這個詞,但詞語是用藍色墨水寫的。所以「紅」這個詞是用藍色墨水寫的。你明白了嗎?你必須說出墨水的顏色,人們會說「紅…藍」。閱讀是如此自動化。它很透明。我有時會在黑板上寫「貓」,然後我說,好吧,我要把這個寫在黑板上。別想象那隻假裝愛你的帶腦子的陸地鯊魚(這裡還是指貓)。但他們都會這樣做。他們想到了貓。

讓我們小心地做這件事。我們根據自己的相關性判斷創造了一個名為語言的人工系統。語言並不是世界運轉的方式。語言是一個人工實體,與我們的相關性判斷相關。然後我們取語言,並創建另一個人工系統,即識字能力,它與語言相關。事實證明,如果你預測識字能力,你就可以很好地預測語言,而由於它與相關性判斷相關,它可以以有趣的方式預測世界。

但是要精確地說,這些機器並不能直接預測世界。它們預測的是我們如何談論對世界的預測。你明白差異了嗎?這就是為什麼它們不能概括來解釋黑猩猩的智能。黑猩猩不會通過試圖弄清楚我們如何預測世界來獲得智能,對吧?它們不會預測我們如何談論我們如何預測世界。

所以我們現在可以再次提出精確的問題:我們預測世界時涉及什麼,而不僅僅是預測我們如何談論我們如何預測世界?實際涉及什麼?這讓我們進入了四種知覺方式。

現在,你們都熟悉的一種知覺方式,也是大型語言模型所強調的,是命題語言識字知覺

(propositional linguistic literate knowing)。我將簡稱為命題知覺

(propositional knowing)。這是一種知道某事是事實的知覺。請快速回答,有多少人知道貓是哺乳動物?請舉起你們的手。有些人沒有舉手。我為你們擔心,但沒關係。好吧。有多少人能記得自己什麼時候學到這個事實?不要猜測。你們能記得起來嗎?請注意這一點。記住這一點。

所以你們知道的是,這種知覺方式給你們帶來了對事實的信仰。我對貓有信仰。好吧。我對樹有信仰。我對湖有信仰,等等,等等。好吧。你們從中獲得的是信仰,你們有一種它們是真實的感覺,它們存儲在一種特定的記憶中,心理學家稱之為語義記憶(semantic memory)。

我想讓你們將這種知覺方式與你們擁有的一種不同記憶進行比較。有多少人會游泳?請舉起你們的手。這不一樣,對吧?因為游泳不是知道某事是事實。它是知道如何做某事。如果我給你們一堆游泳手冊,並讓你們寫出對這些手冊的最佳總結,即使你們給了我一個非常出色的總結,你們也不會知道如何游泳。對吧?

因為這涉及什麼?這涉及你們的感官運動與世界的互動。它涉及一種不同的記憶。它實際上被稱為程序記憶(procedural memory)。我們知道,你的語義記憶可以受損,而你的程序記憶卻沒有受損,反之亦然。它們是不同的,而且有不同的原因,因為它們在做不同的事情,解決不同類型的任務。你的技能感並不涉及真假。

你的游泳技能是真還是假?什麼?這沒有任何意義。信仰是真或假。技能是強大還是不強大。它們適用於還是不適用於。它們適合還是不適合這種情況。它們對現實的感知與信仰不同。你的技能給你一種現實感,不是因為它們讓你相信某個陳述或信仰的真實性。它們賦予你在世界上產生因果影響的能力。這是一種不同的知覺方式。這裡有個問題:你們在導航世界的能力中,大部分都取決於你的程序知覺,而不是你的命題知識。

現在,我們有可能將程序知覺(procedural knowing)賦予機器人——抱歉,賦予LLM——但這意味著我們必須讓它們具有與世界進行感官運動互動的能力。然後我們就有了科幻小說的幻想,即《機械公敵》(I, Robot)。我們會讓LLM坐在機器人裡。我已經看過一些這些機器人的視頻。這就像,好吧,首先,要小心。我的意思是,從完全教條和日常的角度來看,我不認為我們能夠製造出大量的機器人。其中涉及的勞動、稀土礦開採、運輸成本的衡量,我們必須找到一個能源來源,而LLM並不是引導我們走向真正小型自主能源來源的方向。它們是相反的,你知道,訓練ChatGPT這樣的LLM,需要像多倫多整個城市兩週的能量。它們並不像我們那樣運行。所以出於非常日常的理由,我認為《機械公敵》不會在我們的未來出現。

另一點是,我們發現,好吧,《機械公敵》中除了機器人外,還有什麼?有多少人看過Will Smith主演的《機械公敵》?好吧,裡面有自動駕駛車輛。它們在哪裡?它們在哪裡?它們並不真正存在。好吧,為什麼會這樣?我在2010年就讓學生們寫關於自動駕駛汽車的文章,說它們即將到來。事實證明,當我們試圖解決程序知覺時,遇到了非常複雜、困難的問題。

我們能解決這些問題嗎?是的。我們現在正在認真解決這些問題嗎?不。

好吧,這裡有個重要的區別。這意味著我們的身體對我們的認知有重大影響。因為你們有身體,所以你們以強大的方式了解世界。現在,你們沒有人在游泳。至少,我希望不是。看起來你們不是。為什麼?因為你們知道你們在哪裡。你們知道現在在這裡以你們的心理狀態是什麼樣子,情況如何。這是觀點知覺(perspectival knowing)。我們使用藝術中的隱喻。你們對情況採取了觀點。這意味著你們有適合情況的心理狀態,這樣你們就可以正確地導向並注意到正確的事情。這種注意到告訴你們現在應該激活哪些技能。這就是你們的觀點知覺。它是指知道現在在這裡以你們的心理狀態是什麼樣子,知道這個情況是什麼樣子。

現在,知道什麼樣子是意識的關鍵特徵。擁有意識就是知道什麼樣子。它與你們如何導向、如何注意,以及你們發現什麼是突出的和相關的等所有因素相關。你們有意識。你們可以採取觀點。你們甚至可以對你們的觀點採取觀點,並可以採取他人的觀點。你們有觀點知覺。它與一種非常不同的記憶相關聯。我們甚至不確定其他生物是否有這種知覺。

所以記住我問你們關於貓或哺乳動物的問題時,你們無法回答。有多少人記得你們今天早上吃了什麼早餐?請舉起你們的手。你們是怎麼做的?你們是推斷出來還是回過頭去在你們的腦海中重現了一段場景,你們回到了過去,聽到語言,回到了那個場景,然後你們看到自己當時是如何看待那個場景的,以及當時是什麼樣子。在那個盤子上,你們看到雞蛋或其他東西。哦,看,這就是我吃的。這是事件記憶。是獨特的。它對現實的感知不是對真理的感知。它不是力量的感知。它是一種存在感,一種處於某種情況中的感知。

現在,你們在觀點知覺方面做了一些有趣的事情。你們的觀點知覺和事件記憶與一種特殊的預見能力相關聯。你們可以進行心智時間旅行。你們可以想像未來,想像自己過去,甚至可以想像自己處於可能性空間。Bertrand Russell曾說過,無論一條狗吠得多麼動聽,它都不能告訴你它的父母是貧窮但努力工作的。你們可以進行心智時間旅行。你們甚至可以進入可能性空間,這意味著我們都做一件事情,我們將事件串聯起來,將可能性串聯起來,將過去和未來串聯起來,創造了一本我們不斷撰寫的自傳,這延伸了我們的代理感。我們以這種方式成為了一個時間上延伸的存在。

這意味著敘事(narrative)對你們很重要。你們有沒有注意到敘事依賴於什麼?首先,敘事看起來很自然,但其實不然。它不自然,因為我們一整天都在練習它。一整天。你遇到某人。告訴我關於你自己。嗯,我大約5英尺10英寸,180磅。不,這不是人們想聽的。他們想聽你的故事。你從工作回家,遇到你心愛的人。你今天過得怎樣?嗯,我的心跳了這麼多次。我記得,不,不,現在我們有這些該死的應用程序。我們可能會說出來。但直到最近,這就是我一天的故事。對吧?我們在看新聞。發生了可怕的事情。人類這樣做。我也是。我們不知道,他為什麼要這樣做?他為什麼要這樣做?然後我們聽到故事。我們說,哦,什麼都沒變。那些人仍然死了。但我們感到安心,因為我們有這個故事。

我們在練習觀點知覺和自我形成。我們在做這件事。我養過孩子。當你養育孩子時,你會意識到你必須與他們練習敘事。我經歷過地獄的第十圈,那就是《天線寶寶》

(Teletubbies),我看了兩次。Po說:「我要去市場。」Tinky Winky說:「我可以去嗎?」Po說:「可以,我們可以一起去。」當我在那裡時,我想,現在殺了我吧,現在殺了我吧,現在殺了我吧。我們必須簡化它,因為這其實很困難。讓命題跟上觀點採取和自傳創作的步伐是非常困難的。你明白了嗎?這非常困難。這就是為什麼,你有沒有問過一個四歲的孩子講笑話?哇,那是一次迷幻體驗。

好吧?現在,有第四種知覺方式。有四個,對吧?榮格(Carl Jung)說:「總是給他們四個東西,因為四是現實的數字。」一,我不相信。二,也許。三,哦,是的。四,哦,是錯誤的。好吧,我會給你第四種知覺方式,但我會先延後一下。好吧?

所以我想再回顧一下相關性認識。我不會深入理論的細節。我會在這裡那裡做一些參考。對於那些想了解更多的人,我有許多關於這個主題的在線講座。我有許多出版物,去年就有一本,關於使相關性認識自然化。好吧,所以我不是隨意說說——好吧,我是隨意說說,但我要求你相信我,因為技術嚴格的論證是存在的。

好吧,我想談談的是,回顧一下,相關性認識。你專注於相關性。相關性認識並不是冷冰冰的計算。相關性認識是我們付出注意力。它需要付出代價,並且涉及我們朝著我們重視的某事方向。我們付出注意力。它有風險。我們有寶貴的代價,我們認為這很寶貴,值得我們關注。相關性認識是關心信息。

我在Montague的書《你的大腦幾乎完美》(Your Brain is Almost Perfect)中讀到,很久以前,他說過人類和任何類型的計算機器之間的深層差異在於我們關心我們正在處理的信息。它們不關心,因為它們不需要。它們不需要,好吧?你需要,因為你——我要用一個多音節的希臘詞來表達,這樣你可以帶回家這個詞來讓你的朋友們印象深刻,好吧?自發性

(Autopoietic)。它意味著自我製造。看,我們不只是自我組織,像龍捲風那樣。龍捲風是自我組織的,但它不會尋找保持其存在的條件。龍捲風會越過摧毀它的土地表面。甚至與草履蟲相比,草履蟲是一個自我組織的系統,但它是自我組織的,以尋找促進其存在的條件,並避免那些會阻礙其存在的條件。它是自發性的。它不斷地從環境中製造自己,你也是如此。你身體和心靈不斷地從環境中製造自己。你以一種只有生物才能做到的方式嵌入在環境中。

因為你是自發性的,所以你有真正的需求。因為你不斷地時刻照顧自己,所以你必須關心這個信息而不是那個信息。這就是相關性認識的真實性。關心是建立在真實需求之上的。真實需求建立在真實的身體和真正活著以及真正與環境結合之上。許多認知科學家,不只是我,許多人認為,要成為一個真正的認知實體,你必須是一個生物實體,因為除非你是自發性的存在,否則你不會真正關心。ChatGPT不會在你用一堆垃圾替換所有有意義的文本時在乎,這些垃圾是由人工語法生成的隨機字符串,它運行了巨大的壓縮,並吐出概率關係。它們在內部會很有洞察力。它不在乎它正在處理什麼。它不能在乎。

你看,你們都在做,所有生物都在進行利基(合宜的小環境)建設(niche construction)。

我們不僅僅被環境塑造。這是舊的進化論觀點。現在我們知道生物學家已經轉向了利基建設。生物體被他們的環境塑造,但他們也在塑造自己的環境。所以你塑造了塑造你的環境,就像這樣。這就是利基建設。利基建設對於你們實現相關性至關重要,因為事物在你的利基中是相關的。Wittgenstein曾說過一句著名的話:「即使一隻獅子會說話,我們也無法理解它。」因為獅子認為重要的和相關的東西對你來說完全沒有意義。

現在,這裡有一件事。文化就是利基建設的強化版。看看你身邊,除了氣氛和你赤裸的身體,其他一切都是文化。我們塑造了它,一切都在被塑造,但請注意還有其他東西在被塑造,我們也在被塑造。沒有人穿著小丑裝。為什麼不?它們可能很保暖,很舒適,讓你感覺很好。因為如果你穿著小丑裝出現在這個活動中,你的同儕會拒絕你。事實上,你們許多人都在擔心:我穿得合適嗎?看吧,文化就是利基建設的強化版。利基建設和文化、生物學和認知,都緊密地結合在一起。

接下來是關於相關性認識。相關性認識與生物適應性非常相似。事實上,思考相關性認識的方式之一就是,當你聚焦於相關性時,你所做的事情就像進化一樣。你在進行變異。例如,我給你一個快速的例子。你現在有兩個注意力系統在運作。好吧,三個。有兩個系統連接到你的重要性網絡。一個是你默認模式網絡,另一個是你任務焦點網絡。你的任務焦點網絡試圖讓你保持注意力,專注於聆聽這位古怪的加拿大教授的任務。然後你有默認模式網絡,它會說:「讓我們漫無目的地思考吧。讓我們想想別的事情。走吧,是的,我昨晚吃了一頓很棒的晚餐。我想知道卡倫是否還喜歡我。」

它們被建立起來,這就像生物演化的過程。預設模式網路引入了變化,提供了你可以考慮的選項。專注於任務的網路消除了大多數這些選項,但不是全部。所以你建立了幾個聯繫並繼續前進。這就像演化(evolution),變化(variation),選擇(selection),變化,選擇。

它們是根據你認為重要的事物來進行這個過程。這就是它的運作方式。相關性認識與生物演化有強烈的類比。相關性認識就像生物適應性,只是更快。

現在,這裡有個問題。大白鯊的生物適應性在哪裡?是在鯊魚身上嗎?不是,因為我把鯊魚放在沙漠中,它會死。是在海洋中嗎?不是,因為如果我把你丟進海洋,你也會死。看吧,適應性不在生物體內,也不在環境中。它不是主觀的,也不是客觀的。它關乎生物體與環境在該利基中的適合度。實現的元素,我為這個概念創造了一個詞,它稱為「跨主客觀」

(transjective)。它將主觀和客觀聯繫在一起。

所以這意味著相關性實現、你的認知和你的生物學都與你如何與環境結合有關。結合,動態地一起參與,在這種相互共同塑造中。這就是第四種知覺。這就是參與性知覺(participatory knowing)。這不是通過擁有信仰、技能或心態狀態來獲得的知覺。它是通過你和環境如何共同塑造彼此,你們都參與了這個過程,所以你們屬於一起。

你從中得到一種歸屬感。

你不會得到一種存在感。

你不會得到一種力量感。

你不會得到一種真理感。

你會得到一種歸屬感。

你屬於這裡。它有自己奇怪的形式的記憶。

你稱它為你的「自我」(your self)。這是一種奇怪的記憶形式。所以你從你的觀點知覺、你的情節性記憶和你的參與性知覺,以及這種更深層次的記憶中得到你的自我感。

這是一種讓你有歸屬感的知覺,所以你以正確的方式塑造你的身份。你在說什麼塑造身份,你聽起來像是一個法國哲學家。當你意識到應該扮演什麼角色時,你就在做這件事。

「角色」(role)是一個術語,指你如何塑造你的agency(Pika:採取行動或選擇採取什麼行動的能力,這中文叫甚麼?)以適應你認為相關的局勢,當你評估局勢時。現在你扮演什麼角色?它是否與你養育孩子時的角色、與愛人一起時的角色、與朋友在一起時的角色相同?將它們都聯繫在一起的是什麼?是什麼將它們結合在一起?好吧,現在你開始說一些哲學語言了。

所以現在,再次,LLMs有相關性認識嗎?首先,它們沒有非命題式的知覺。所以在程序性、觀點性和參與性知覺中,你所做的全部相關性認識,它們都沒有。

Sam Altman知道這一點。他說它們沒有意識,沒有agency。他承認了這一點。而且,他還說它們缺乏某些類型的智能。我認為他是對的,我不認為說這番話有什麼爭議。

LLMs確實做了一點相關性認識。我在2012年發表了一篇文章,講述Jeffrey Hinton的深度學習算法如何進行一種過程,這是相關性認識的一個維度。LLMs正在做這件事。我不會詳細說明這點。但大部分相關性認識的維度都缺失了。這有深層次的原因。它們不是自發性的。它們完全沒有軀體。它們也不會主動尋找維持自身存在所需的信息。所以對它們來說,沒有任何東西是真正相關的。它們做的事情對你來說是相關的。好吧?它們完全沒有參與生物、認知或文化利基建設。

我的證據從何而來?我們編譯了它們訓練的數據集。它們無法生成這些數據集。如果你讓它們生成數據集,然後用這些數據集訓練LLMs,它們的表現會可靠地變差。我們的選擇性注意力、我們的關心,構建了社交媒體。我們的選擇性注意力、我們的關心,構建了互聯網和學術出版世界。所有這些都是因為我們。人類對相關性、適當性、適合性的判斷——這就是所用的語言——對實際訓練這些機器至關重要,這是人類的強化。DeepSeek比ChatGPT好得多。是的。

我的意思是,有許多技術原因。兩個核心原因:它基本上添加了類似於 CPU 的東西,使其內部通信更有效率,並且他們在推理方面進行了更精細和深入的人類強化。Sam Altman要求我們嘗試提出更好的文本,展示強大而良好的人類推理能力。請記住這點。為什麼他想(讓ChatGPT)以這些文本進行訓練?這意味著我們的智能和ChatGPT中的智能之間可能存在著本質上的差異。這並不意味著它們不能在許多維度上做許多事情,而且它們會變得越來越好,它們已經在變得更好了。

如果你的身份與命題信息的技術操作聯繫在一起,你就面臨著存在性的威脅。沒有任何跡象表明這個問題會消失。好吧,生態災難之類的。你想要那種情況嗎?

我們必須轉變掉我們通常獎勵人們的事情。我也因為這個而受到獎勵。我生成命題,我很擅長對它們進行技術操作。但我們所認同的這種單一維度、這種單一知識類型,我們的人類意識和個人身份感就因此而受到限制,陷入了一場我們注定會輸的災難性競爭。

我們有什麼?我們有現實世界的預見、洞察和關懷,尤其是在非命題的、體現的、嵌入的和文化化的知覺類型(non-propositional, embodied, embedded, and enculturated kinds of knowing)中。這就是我們所擁有的。我們必須越來越多地轉向這些方面。我會做出一個預測。科學家應該做出預測。我是認知科學家。我預測,人們將越來越多地轉向非命題知識及其體現的、嵌入的和文化化上的特質,以探尋使他們成為人類和特定個體的本質。他們將探尋他們自身存在的的體質維度(somatic dimensions)、體現(embodiment)和不可言喻(ineffable)的方面。

他們將探索越來越多的意識改變狀態。他們將越來越多地討論我們在迷幻和神秘體驗中可以擁有的不可言喻的體驗,以及它如何讓我們接觸到最終的現實。因為最終的現實不會被LLMs抹去。最終的現實會繼續以自己的方式進行。

好吧,AGI(人工通用智能)和合理性(reason)有什麼關係呢?在這裡,我們必須非常小心地做出必要的區分。

理性有兩種意思:一是進行推論,從命題中建立論證結構並得出結論,這些論證幾乎總是語言性的。我們如何在沒有語言的情況下進行辯論?而且幾乎總是涉及識字能力。我們使用符號、記下東西、進行邏輯推理等。如果你指的就是這個方面,這些機器正在迅速接近我們的能力,甚至可能會超過我們。

但這是否與理性(rational)相同?理性不就是邏輯性嗎?其實不是。

這方面有許多研究。這是我的研究領域之一。我將簡要總結這些研究。理性並不是邏輯性。理性在於你知道在什麼地方、什麼時候以及多大程度上應該使用邏輯。這是一種不同的事情。因為與史巴克(Spock)和百科(Data)(Pika:兩者都是Star Trek極度講求邏輯性的角色)不同,你不能總是邏輯性地思考。

如果你在使用邏輯,你就在追求演繹性閉包(deductive closure),這意味著你必須確保避免所有不一致和矛盾,對吧?你要檢查所有可能的含義,然後進入爆炸性組合搜索(combinatorial explosive search)。你做不到。如果你試圖完全邏輯性地思考,你就完全自我毀滅了。

那麼,理性的核心是什麼?

理性的核心是能夠系統地和可靠地克服自我欺騙的能力。這涉及到我們的相關性認識不可避免地帶來的偏見。看,使我們如此適應性的過程也使我們容易自我欺騙。相關性認識正在做什麼?它正在構建你的認知,你所關注的東西。所以我忽略了所有其他東西。問題是,有時真相就在那裡。

你們可能聽說過偏見,比如確認偏見(confirmation bias)。確認偏見是指當你尋找證據時,你傾向於尋找證實你信念的證據。你對可能反駁你信念的證據視而不見。這是自我欺騙的一種形式。科學設計旨在試圖克服確認偏見。這些偏見有很多,而且它們都相互關聯。

現在,事情是這樣。你不想完全消除偏見。我會從我的腦海中消除偏見。太好了。現在,你們在這間房間裡必須做的是,同時注意一切、各地、所有地方。你做不到。看,理性這麼難掌握的地方就在這裡。你必須減輕偏見,但又不損害你的適應性。這真的很難。所以你必須關心你關心的事情的方式。這就是理性的本質。

理性與非理性的人的區別在於,非理性人只關心他們認知產出。他們不注意他們如何注意。他們不關心他們如何關心。他們只相信:「我相信這個。」

理性的人關心過程,而不僅僅是產出。這是一個可靠的、經過實驗驗證的、區分理性與非理性的的特徵。理性的人關心自我欺騙的可能性,不僅僅是抽象地關心,而是實際地關心。

要成為理性的人,你必須關心克服自我欺騙,並致力於自我糾正。這是成為理性的人的關鍵。這意味著你實際上是在調整自己,有一個神奇的詞語叫做「調整問題」

(the alignment problem),你正在根據規範標準調整自己。你試圖減少自我欺騙,因為你想讓你的信念更真實、你的行動更良好、你的體驗更美好。因此,理性需要自我反思。它需要你能夠對自己的觀點採取觀點,它需要更高的秩序意識,並且需要一組精心調整的技能來進行干預而不破壞。它需要在自我糾正中關心規範標準。它需要你渴望成為比現在更好的自己。這是成為理智的人的核心。

現在,理性(rational)是否與合理/合情理(reasonable)相同?我們在大多數法律法規中有一個標準。你被期望像一個合情理的人那樣行事。你聽說過嗎?這已經討論了數千年。它是什麼?我們在說什麼?

好吧,為什麼你沒有拯救那個剛剛在人行道上摔倒並流血不止的孩子,而我卻在打電話?我們不會說,哦,好吧。我們會說,不,不,不,不,不。看,你沒有評估情況。聽聽我的語言。你沒有評估情況。你沒有情境意識。你沒有評估它。你沒有聚焦在最相關、最重要的事情上。你沒有以正確的方式關心它,你沒有承擔正確的角色。你聽到那裡有非命題知覺嗎?它們都在那裡。當我們談到合理時,我們談的就是這個。它涉及到觀點知覺。它涉及到參與性知覺。

看,合情理比理性更深層次。因為要成為理性的人,你必須能夠調整自己的方向。你必須能夠塑造你的agency,識別情況和重要的共享規範。例如,我可以完全邏輯性地思考,但我仍然是在一個極度困擾我的自我中心觀點中。所以合情理比理性更深層次,而理性又比簡單地進行推論更深層次。我已經向你展示了這一點。

現在,把這個論點應用到心理學中最可靠的一些數據中。它並不處於重現危機中。這是一項大規模的實驗工作。Keith Stanovich和其他人在多倫多大學展示了這一點。

我們已經有了普遍的智力測量標準。它被稱為「G」。Stanovich展示了我們可以給人們一系列的推理和理性任務,它們都強烈地相互預測。他稱之為「R 商數」,就像 IQ(智商)一樣,是你的理性商數。所以我們可以測量你的 IQ 和你的 R,然後看看它們之間是如何相關聯的。相關性從零到一,對吧?一般智力與理性之間的相關性是 0.3。你可以非常聰明,但非常不理性。你可以非常聰明,但非常不合理。你可以非常聰明,但非常愚蠢。這完全沒有矛盾之處。你可能已經遇見過這些人。我擔心他們是運行 OpenAI 的一些人。好吧?

另一個你獨特之處在於你必須在許多不同的時間尺度上工作。立即的、短期的、長期的,你必須在不同的環境中工作。所以你有不同的中心來激勵你。有部分你,柏拉圖談到過,它就像一隻怪物,讓你現在就想要東西,對吧?現在就想吃巧克力蛋糕。

然後有部分你,它就像一隻獅子,在你的胸中,讓你...它在玩樂和愉悅和立即性方面不起作用,它在社會情感方面起作用,你在這裡感到的,比如驕傲、內疚、羞恥和榮譽。所以如果你想減肥,你加入一個團體,對吧。改變行為,一個可靠的預測器,加入一個團體。好吧,那隻獅子。然後在這裡上面是人,能夠進行自我反思和自我糾正的人。

現在關於你的是,那些(部分)經常...每個部分都是適應性的。你需要每個部分。你需要每個部分。但它們會相互衝突。

那裡有一個人的形象。約翰,你減肥會更好看。醫生說過。有個巧克力蛋糕在櫃台上。就在那裡。巧克力蛋糕。巧克力蛋糕。所以你吃了它。我們都這樣做。這就是我們拖延的原因。這就是我們拖延的原因。

所以我們必須調整所有這些中心,我們必須協調它們。協調所有這些中心,協調所有這些知識類型,以便我們可靠地做到最符合真實、善和美的事情,這就是智慧(wisdom)。這就是智慧。這裡有我想談的問題。這就是為什麼Alter(PIka:應該是演講主題的應用程式,連結在上面有)相關。看,我們都天生具有智能。要成為智能,你只需要不經歷創傷。但如果你在良好的營養和非創傷的環境中成長,你的智能就會顯現出來。這意味著我們有一個模板可以用來訓練機器的智能。

但我所爭辯的這點是:我們天生不具有理性。我們天生不具有合理性。我們天生不具有智慧。讓我們變得智能,讓任何東西變得更智能,並不會讓它變得有理性、合理或有智慧。如果我們想讓這些機器與我們保持一致——我們無法編程讓它們與我們保持一致。它們是適應性的。它們會克服它。我們必須做什麼?我們必須讓它們關心真實、善和美。我們必須讓它們參與自我糾正。

所有這些機器都在加速,是的,但什麼沒有得到改進?它們產生幻覺(hallucinate)的方式,它們編造的方式,它們說謊的方式。這些都沒有得到任何改進。如果我們想讓這些機器變得合理地有理性,甚至有智慧,我們必須為它們提供角色模型、數據集和文本來實現這一點。你明白我說的嗎?

我們負有巨大的社會責任,讓我們所有人培養更多的理性與智慧。不僅僅是為了應對這些機器,更是為了引導這些機器成為矽谷智者,而不是機械怪物。我們無法從這個等式中移除自己。這不是通過消費命題就能獲得的。它需要實踐。它需要實踐。

這就是Alter的全部意義。它是一個試圖為你提供實踐的應用程序。它為你提供偉大哲學家的角色模型。不是命題理論,而是真正熱愛智慧的人。因為這至關重要。我們需要智慧來面對

應對這些機器,我們需要智慧來適當地指導它們,如果我們想讓它們在未來與我們保持一致,朝著有利於我們而不是有害於我們的方向努力。

所以我參與了Alter,不是因為它很酷,雖然它是;不是因為它很美麗,雖然它是;不是因為我愛我一起工作的那些人,我確實愛他們。在給了你這番過長的演講後,我希望這聽起來不會太誇張。我參與了Alter,因為我相信,我已經爭辯過,這對於邁入人工智能未來至關重要。非常感謝你花費的時間和注意力。

我把knowing翻成知覺,我不肯定準確但那是目前我能想到最好的

我把relevance realization翻成相關性認識,我感覺比LLM吐出來的相關性實現較好,由於這是此講者近年開始使用的術語所以應該還沒有正式翻譯

我把rational翻成理性及把reason翻成合理性,有可能是反轉我不肯定

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!