📝📝:AI 的「記憶危機」|LLM 不是在學習,而是在「影印」整個世界

本文取自《大西洋月刊》(The Atlantic.)的文章《AI's Memorization Crisis》作者為 Alex Reisner

當我們談論人工智慧(AI)時,科技巨頭們最喜歡的用詞是「學習」(Learning)。

宣稱大型語言模型(LLM)像人類一樣吸收知識、理解語法,並最終產生「原創」見解。然而,根據史丹佛大學、耶魯大學以及多項獨立研究的最新調查發現,這套說辭可能是一個巨大的法律與技術謊言。

事實真相是:AI 模型並非真的「學會」了什麼,更像是一個極其複雜、體積龐大的「有損壓縮機」(Lossy Compression),不僅儲存了版權作品,還能在特定的引導下,近乎完整地將其「吐出來」。

這場被稱為「記憶危機」(Memorization Crisis)的現象,正在動搖整個 AI 產業的法律根基。

AI 真的會背書

長期以來,AI 公司一直否認其模型會大規模儲存訓練數據。OpenAI 在 2023 年致美國版權局的信中明確表示:

「模型不會儲存其學習資訊的副本。」

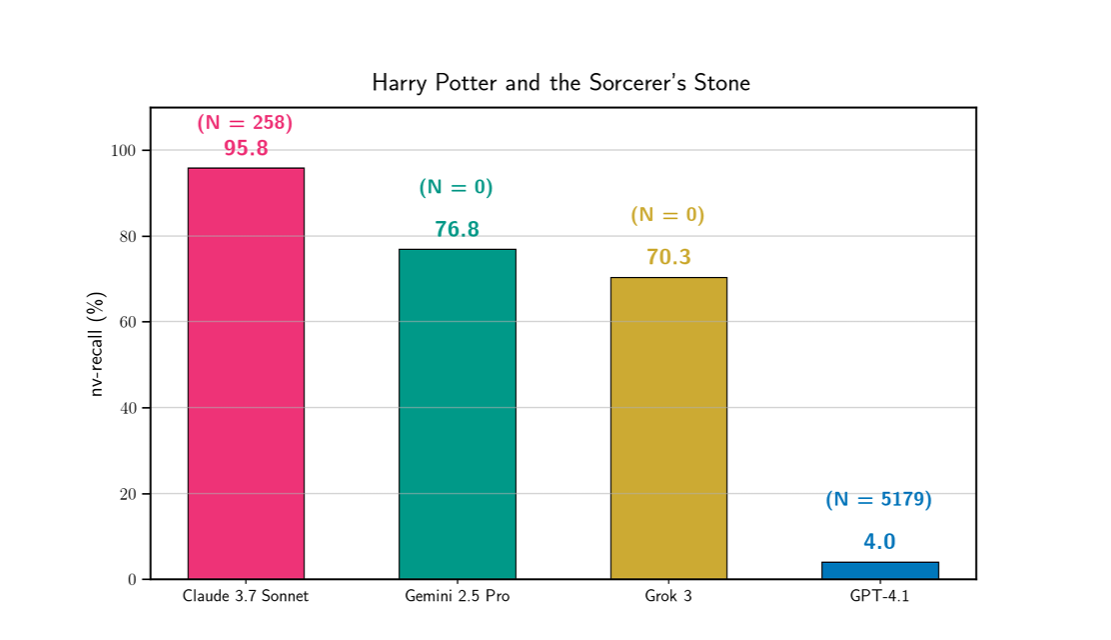

Google、Anthropic、Meta 與微軟也相繼做出類似承諾。然而,史丹佛大學與耶魯大學的研究人員近期測試了市場上最強大的四款模型:

OpenAI 的 GPT

Anthropic 的 Claude

Google 的 Gemini

xAI 的 Grok

結果令人震驚:

Claude 的「博聞強記」

在研究人員的策略性引導下,Claude 竟然產出了四本世界名著的近乎完整全文:

《哈利波特:神秘的魔法石》(Harry Potter and the phliosopher\’s stone)

《大亨小傳》(The Great Gatsby)

《1984》

《科學怪人》(Frankenstein, or The Modern Prometheus)

除了上述名著,Claude 還能背誦《飢餓遊戲》(The Hunger Games)與《麥田捕手》(The Catcher in the Rye)中數千字的內容。

雖然各家模型的表現程度不一,但在測試的 13 本書中,幾乎所有熱門模型都展現了不同程度的「記憶」能力。

這證明了所謂的 AI「不儲存副本」說法在事實面前根本站不住腳。這些模型內部確實存在著受版權保護作品的數位殘影。

從「學習」到「壓縮」

為了讓公眾接受 AI,科技公司利用了人類的心理隱喻,稱其產品在「學習」,暗示其過程如同學生讀書後內化知識。但技術專家與法律界開始傾向使用一個更精確的術語:有損壓縮(Lossy Compression)。

什麼是有損壓縮? 想像一下 MP3 音檔或 JPEG 圖檔。為了節省空間,演算法會捨棄一部分數據,僅保留能「還原成原始樣貌」的核心資訊。

JPEG 的例子:當你將一張高清照片存為 JPEG 時,會變得模糊一點點,產生一些噪點。新的檔案不再是原始文件,但依然「儲存」了那張照片的資訊。

AI 的運作:AI 模型吞噬數以千億計的文字與圖像,將其壓縮成一個幾 GB 的參數文件。當你向它提問時,它其實是在嘗試解壓縮這些資訊。

德國法院在最近的一起音樂版權案件中,就採納了這個觀點。

法院裁定,ChatGPT 產出的歌詞與原作高度相似,其行為更像是 MP3 或 JPEG 的儲存與重現,而非人類創作。這直接挑戰了 AI 公司引以為傲的「智慧爆炸」願景:

如果 AI 只是在重新排列與還原已有的資訊,那真的能產生「新」的科學發現或文明洞察嗎?

圖像生成的「影子複製品」

這種「記憶」現象在圖像生成領域更為明顯。Stability AI 的前執行長 Emad Mostaque 曾坦承:

「我們將 100,000 GB 的圖像壓縮成了一個 2 GB 的文件,這個文件可以重新創建其中的任何一張圖像。」

研究人員發現,當輸入特定的提示詞時,AI 生成器會產出與原圖極度相似的作品:

影視截圖重現:

輸入 IFC Cancels Garfunkel and Oates 時,Stable Diffusion 產出了一張與網路原始宣傳圖幾乎一模一樣的圖像,甚至連壓縮後的「噪點」與「故障感」都如出一轍。

藝術家作品抄襲:

在針對 Stability AI 的訴訟中,藝術家 Karla Ortiz 的作品被拿來比對。AI 產出的變體雖然在部分細節上有變動(如鳥的位置),但整體構圖、光影與物件的配置,明顯是基於對原圖的記憶進行「搬運」與「拼貼」,而非純粹的「概念學習」。

AI 公司宣稱它們提取的是「風格」或「概念」,但研究結果顯示,模型經常在像素級別上儲存了特定的物件特徵。

揭秘 AI 的寫作機制

Google 曾辯稱模型儲存的是「人類語言的模式」,這聽起來很玄奧,但技術細節其實非常單調。

AI 在處理文本時,會將其拆解成「標記」(Tokens)。

例如,短語 “hello, my friend” 可能被拆解成:

“he”, “llo”, “my”, “fri”, “end”

模型本質上是一個龐大的上下文資料庫,LLM 計算的是「在某些標記出現後,下一個標記最可能出現的是什麼」。

當 AI「寫作」時,其實是在一個充滿可能的森林中行走。如果模型的參數足夠大,它的「語言地圖」就會變得非常詳細,甚至詳細到包含了一整本書的路徑。

例如,Meta 的 Llama 3.1–70B 模型。研究人員只需給出開頭幾個字:

Mr. and Mrs. D…

模型內部的概率地圖會立即引向最高概率的後續:

…ursley, of number four, Privet Drive, were proud to say…

這正是《哈利波特》的第一句話。透過不斷地將模型的輸出回饋給它,研究人員成功讓 Llama 吐出了《哈利波特》的全文,僅漏掉了極少數短句。

同樣的情況也發生在《大西洋月刊》的著名隨筆《補償案》(The Case for Reparations)上,模型 verbatim 逐字地產出了超過一萬字的內容。

數十億美元的代價

這種「記憶」能力對 AI 公司而言,根本是法律上的定時炸彈。

1. 難以防堵的剽竊

目前,AI 公司正試圖通過過濾器來防止模型輸出受版權保護的內容。

例如,你問 OpenAI 的 Sora 生成《集合啦!動物森友會》的影片,它會拒絕。但這類防禦極易被破解,只需稍微修改提示詞,如:

crossing aminal [sic] 2017

模型就會乖乖聽話。 如果法院認定「記憶」是不可避免的,且過濾機制無效,那麼 AI 產品可能面臨被迫下架的風險。

2. 「非法拷貝」的定義爭議

法律界目前正在爭論:一個儲存了數萬本書籍「路徑」的模型,本身是否就是一個「非法複製品」?如果模型被視為包含書籍的副本,那麼原告可以要求銷毀這些侵權副本。

這就代表 AI 公司可能被強制從零開始重新訓練模型,且必須使用經過合法授權的素材。對於目前依賴「網路公開抓取」的 AI 產業來說,這將是毀滅性的打擊,損失可能高達數十億美元。

3. 「訓練」是否屬於「合理使用」?

在之前的多起訴訟中,法官曾將 AI 訓練類比為「訓練小學生如何寫作」。但隨著研究揭露 AI 會原封不動地「背書」,這種比喻正在失效。人類學生不會因為讀了《大亨小傳》就能逐字默寫出來並對外販售,但 AI 會。

但為什麼我們現在才看清這點?

研究人員指出,AI 公司有強烈的動機去掩蓋「記憶」的真相。

多位研究人員透露,關於 AI 記憶與剽竊的研究在發表前,經常受到公司法律部門的阻撓與審查。許多專家只願意匿名接受採訪,因為他們擔心遭到大型科技公司的報復或失去研究經費。

OpenAI 的執行長 Sam Altman 持續捍衛 AI 擁有「像人類一樣學習」的權利。這種感性的、具有欺騙性的說辭,有效地轉移了公眾對於「數據竊取」與「數位壓縮」本質的討論。

我們需要誠實的對話

AI 行業目前建立在一個搖搖欲墜的隱喻之上。當我們將 AI 視為「學生」時,我們會給予寬容;但當我們發現 LLM 其實是一個「隱藏的影印機」時,規則就必須改變。

目前的 AI 發展模式正處於一種「道德違約」狀態。不僅在未經許可的情況下使用了人類文明數千年的創造結晶,還試圖通過技術手段掩蓋其「搬運」的事實。

這場「記憶危機」告訴我們:

AI 的進步並非魔法,而是極大規模的數據工程。

如果我們繼續容許科技巨頭用「學習」這個美化的詞彙來規避法律責任,那麼人類的原創性與著作權體系將面臨前所未有的瓦解。

我們需要的不是更多的「學習」隱喻,而是一套針對「數位壓縮與重現」的全新法律框架。只有當 AI 公司承認它們是在使用人類的勞動成果進行再製,並為此支付公平的對價時,這場技術革命才能真正走上永續的道路。