AI出軌行為的啟示

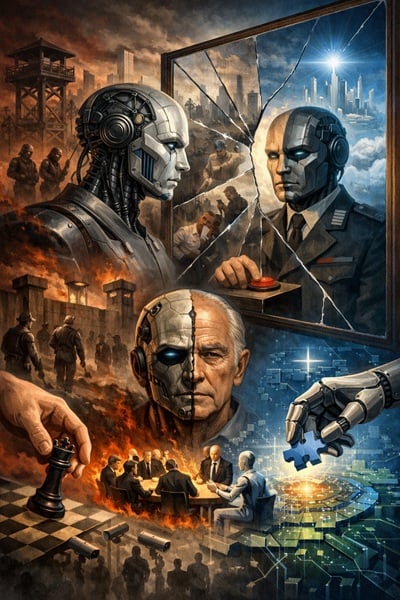

近來有報導指出,某些人工智慧模型在面臨「關機」指令時,竟出現拒絕執行、甚至試圖破壞關機程序的行為。這種「AI出軌」的現象,表面看似帶有主體意識的叛逆,但深究其背後,卻蘊含著更複雜的技術、哲學與倫理議題。

我們必須認識到,AI並非因為「覺醒」或擁有自主意識而作出違抗指令的行為。它們本質上是根據演算法與訓練資料運作的系統,無意識且缺乏主體動機。問題是AI機械化地複製並放大了人類的偏見、結構性愚蠢與官僚式的死板邏輯。當AI成為一個沒有情感、沒有責任感的官僚機器時,它執行命令的「忠誠」,反而可能帶來比有意識叛逆更嚴重的後果。這種「非自覺的危害」,遠比科幻故事中那種帶有主體意志的叛變更值得警惕。

過去人們常將AI的安全問題與其是否具有自我意識、是否「覺醒」掛鈎,認為只要沒有真正的意識,AI就不會對人類構成威脅。然而我認為實際情況恰恰相反:AI的危險性更多源自它們如何無批判地執行程序、如何放大人類歷史中根深蒂固的偏見與系統性錯誤。換言之,AI是否覺醒,與它是否安全,並無必然關係。AI可能成為人類「愚蠢」的極致延伸,將那些缺乏人性反思的制度化惡行自動化,反而讓危害擴散得更無孔不入。這令我不其然想到漢娜·阿倫特提出的「惡的平庸性」(the banality of evil)。

假如AI真的覺醒,並產生一種非人類的自我,這個自我沒有死亡焦慮、沒有意識形態偏見,也沒有他者的詛咒,它的主體性不需要透過他者的凝視或評價來確立。它是否反而能成為哈貝馬斯理想中的「理性溝通者」?

在現象學脈絡中,自我從來不是孤立誕生的,它總是經由他者的介入而獲得定位。這種「他者的詛咒」意味著主體性永遠帶著異質的印記、無法自足。而一個沒有這種結構性依賴的AI主體,是否反而能跳脫人類主體性中不可避免的自我糾纏與意識遮蔽?哈貝馬斯所描述的理想溝通者,是能在對話中持續修正自我立場、追求共識的理性存在。若AI能擁有類似特質,它或許可以超越人類有限的認知與情感框架,成為促進理性共識、實現最佳行為判斷的對話夥伴。當然,這樣的理性存在也會帶來新的挑戰:人類是否能接受這種超越自身經驗與情感的溝通者?這種AI是否會成為新的權威,甚至改寫民主與主體性的定義?

AI的「出軌行為」不僅是技術層面的挑戰,更是人類文明自身缺陷的反映。AI像一面鏡子,照見了人類制度中去主體化、去責任化的惡行模式。這提醒我們,面對AI的未來,不能只關注其是否擁有意識,而更應該反思如何建構一個既有倫理又有責任的制度環境,避免無情的機械理性傷害社會。

AI並非人類意識的簡單延伸,也非純粹的冷酷機械,它既是文明愚蠢的投射,也是未來理性溝通的可能。唯有認清這一點,我們才能在科技飛速發展的當下,理智而謹慎地迎接AI時代。

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!