大型語言模型與人類在發散性創造力上的比較分析綜合報告

Source: Divergent creativity in humans and large language models

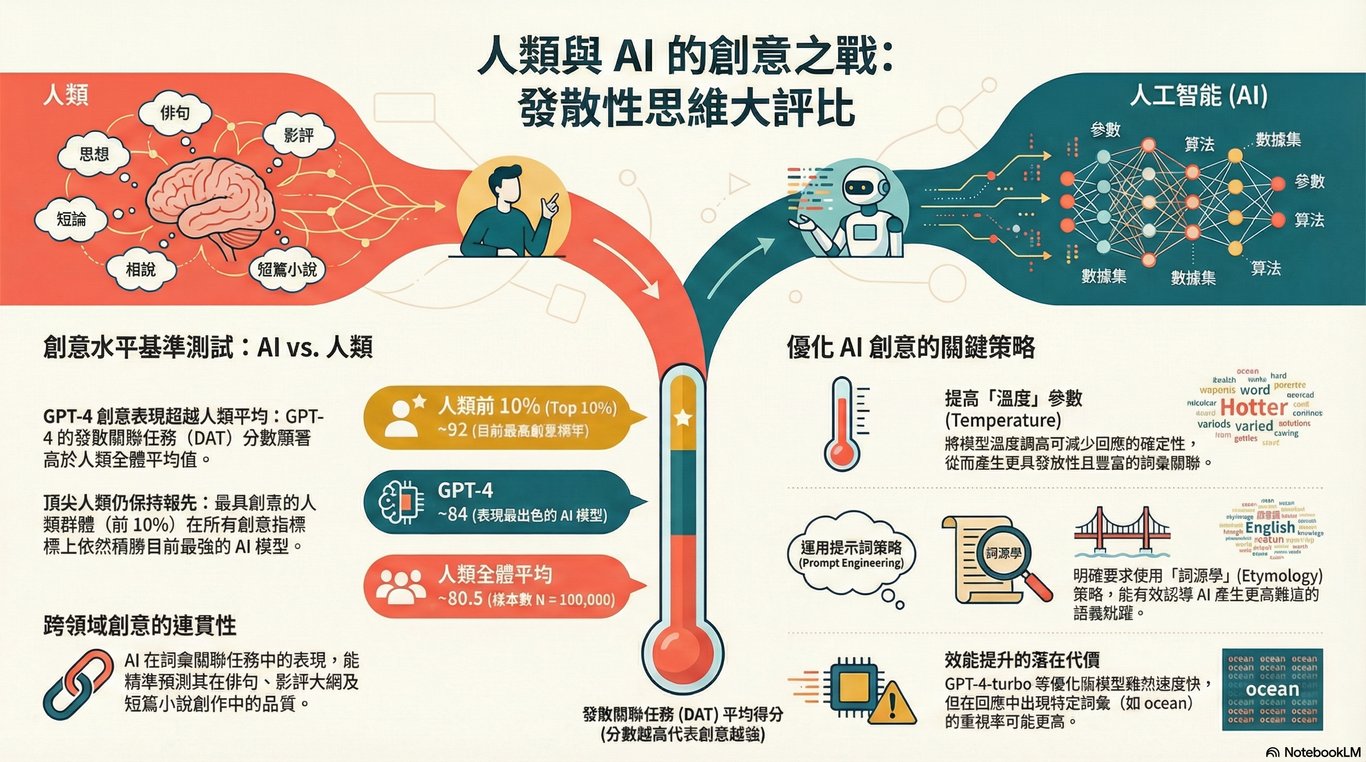

1. 導論:評估人工智慧的創造力疆界

1.1 背景與研究動機

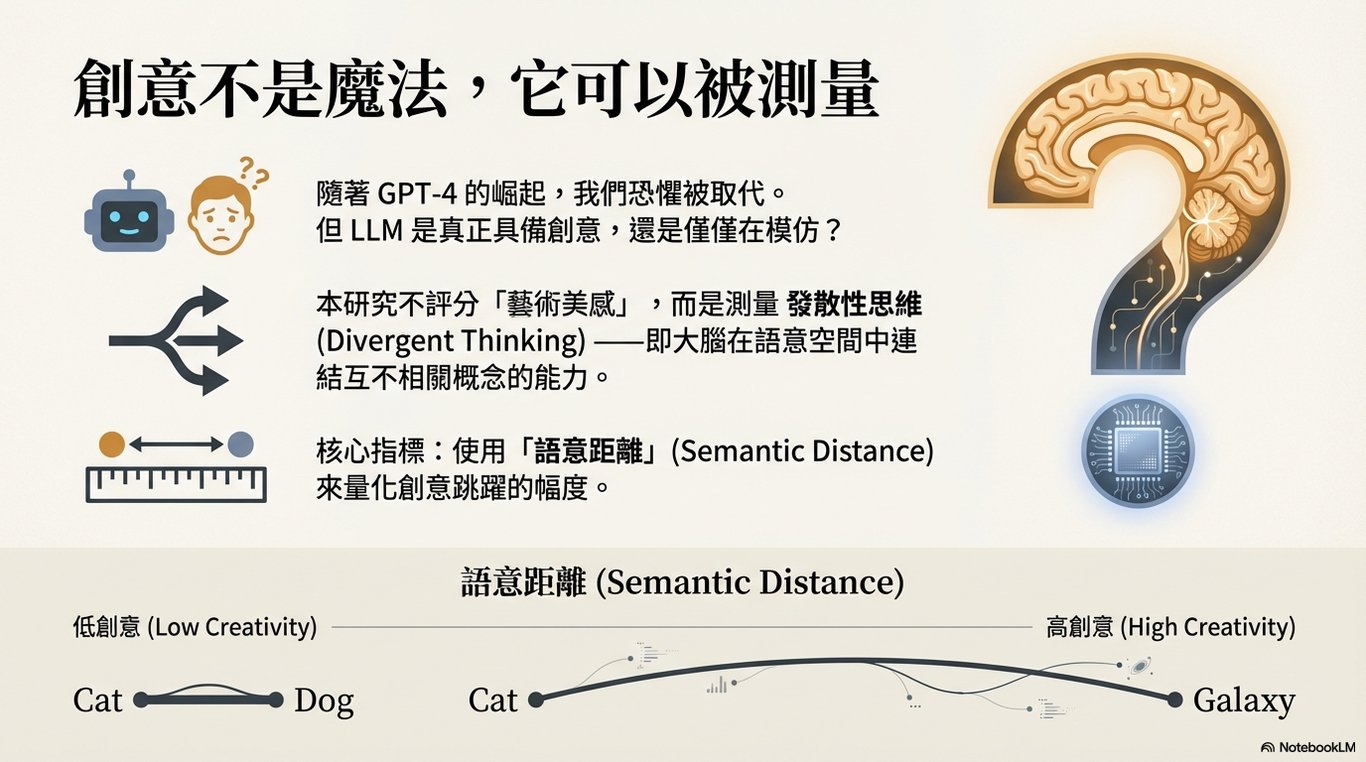

近年來,大型語言模型(Large Language Models, LLMs)的迅猛發展,引發了學術界與公眾對於其創造力是否能與人類相媲美的廣泛討論。這些模型在多種標準化測試中展現出卓越的能力,從通過律師資格考試到創作詩歌,其表現激發了人們的興奮與憂慮。然而,在這場熱烈的討論中,始終缺少一個系統性、客觀的評估框架,用以直接比較頂尖 LLM 與大規模人類群體在創造力任務上的表現。本研究旨在填補這一關鍵空白,透過量化「語義發散性」(semantic divergence)來客觀比較人類與機器的「發散性思維」(divergent thinking)能力。

1.2 核心研究目標

本報告的核心目標可歸納為以下三點:

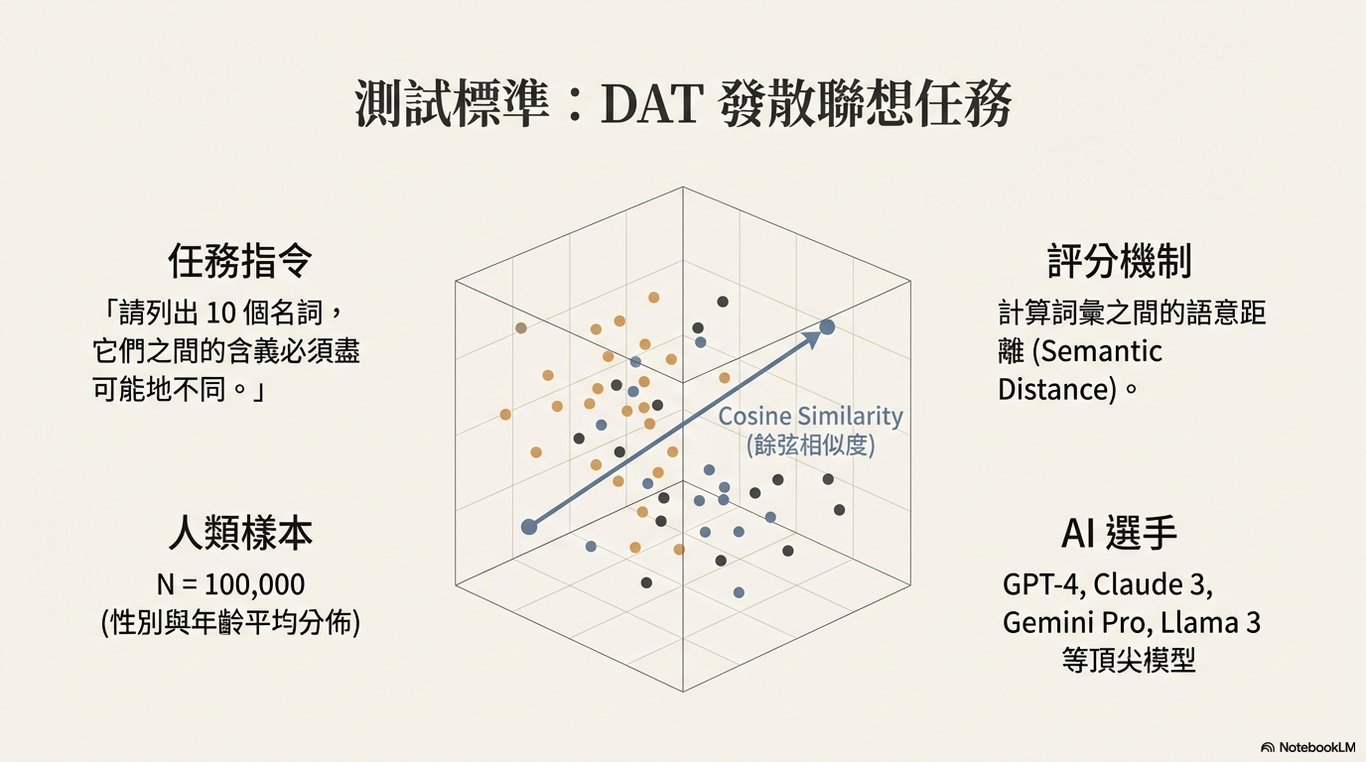

進行基準測試 (Benchmarking): 運用「發散性聯想任務」(Divergent Association Task, DAT)作為客觀指標,對比多個主流 LLM 與一個包含十萬名人類的大規模樣本,在發散性思維上的基礎表現。

進行可調控性分析 (Controllability Analysis): 系統性地探討透過調整提示策略(prompt strategies)與超參數(如溫度 temperature),是否能有效操控並提升 LLM 的語義發散性,從而揭示其創造力輸出的可塑性。

進行泛化能力評估 (Generalization Assessment): 檢驗模型在 DAT 上的高分表現是否能推廣至更複雜的創意寫作任務中,包括俳句、電影故事大綱與閃小說(flash fiction),並將其生成內容與人類寫作語料庫進行比較。

1.3 報告結構概述

本報告將首先詳細介紹用於實現上述目標的研究方法與核心評估指標,為後續的數據分析提供清晰的理論基礎。

2. 核心研究方法與評估指標

2.1 客觀量化的必要性

為了客觀比較人類與機器的創造力,建立可量化且標準化的評估方法至關重要。傳統的創造力評估(如替代用途測試)常因評分主觀性而受到挑戰,而計算指標則能提供更穩定、可重複的測量。本節將概述研究所採用的核心任務與計算指標,這些工具旨在捕捉創造力的關鍵面向——發散性思維,即產生新穎、多樣化想法的能力。

2.2 發散性聯想任務 (Divergent Association Task, DAT)

DAT 是一項簡潔而強大的發散性思維評估工具。其核心概念要求參與者(無論是人類還是 LLM)生成 10 個在語義上盡可能疏遠、互不相關的詞彙。此任務的評分完全基於計算,其原理是透過詞嵌入(word embeddings)技術,將每個詞轉換為高維向量,並計算詞彙兩兩之間的平均語義距離。分數越高,代表詞彙間的語義跨度越大,也意味著更強的發散性聯想能力。一個重要的 methodological detail 是,儘管指令要求生成 10 個詞,但評分協議(對人類與 LLM 皆然)一致採用前七個有效詞彙來計算最終分數。

2.3 創意寫作評估指標

為了評估更複雜的文本創造力,本研究採用了以下幾種計算指標:

發散性語義整合 (Divergent Semantic Integration, DSI): DSI 是一種量化敘事文本中詞語之間語義距離的指標,它特別測量文本中連續詞嵌入之間的語義距離,反映了隨著敘事展開整合多樣化概念的能力。與 DAT 類似,DSI 也基於詞嵌入間的餘弦相似度計算,分數越高代表文本的創意整合能力越強。

Lempel-Ziv (LZ) 複雜度: LZ 複雜度源於數據壓縮演算法,被用來衡量文本的不可預測性和多樣性。其基本原理是,一個重複性高、模式單一的文本更容易被壓縮,因此其複雜度較低。反之,一個充滿新穎詞彙與結構的文本則不易壓縮,具有較高的 LZ 複雜度。

主成分分析 (Principal Component Analysis, PCA): PCA 是一種降維技術,本研究用它將高維度的文本嵌入向量投影到二維空間進行視覺化。這使得我們能夠直觀地探索不同模型與人類在寫作風格或主題模式上的結構性差異,例如,由不同來源(如 GPT-4、Vicuna、人類)生成的文本是否在語義空間中形成獨特的群集。

在了解了這些評估工具後,下一章節將呈現 LLM 與人類在核心基準測試——DAT 任務上的直接比較結果。

3. 核心基準測試:發散性聯想任務 (DAT) 表現分析

3.1 首次量化比較

發散性聯想任務(DAT)作為本研究的核心基準測試,其結果為量化比較 LLM 與人類的發散性思維提供了第一個關鍵數據點。本節將深入剖析模型的平均表現、與頂尖人類創造者的差距,並探討其在任務中展現出的獨特行為模式。

3.2 LLM 與人類平均表現的對比

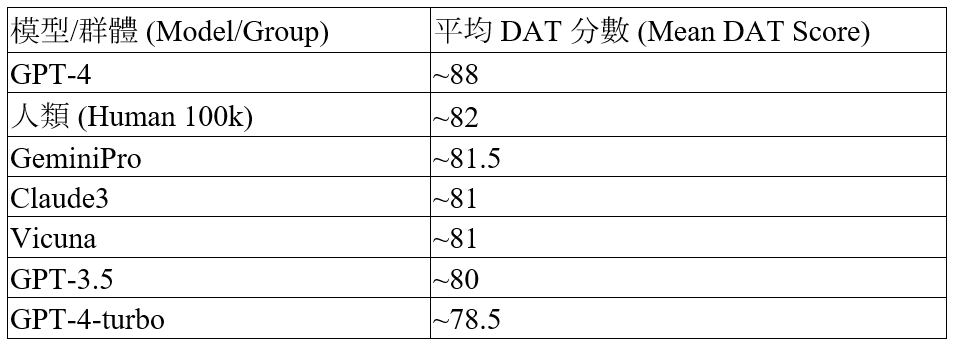

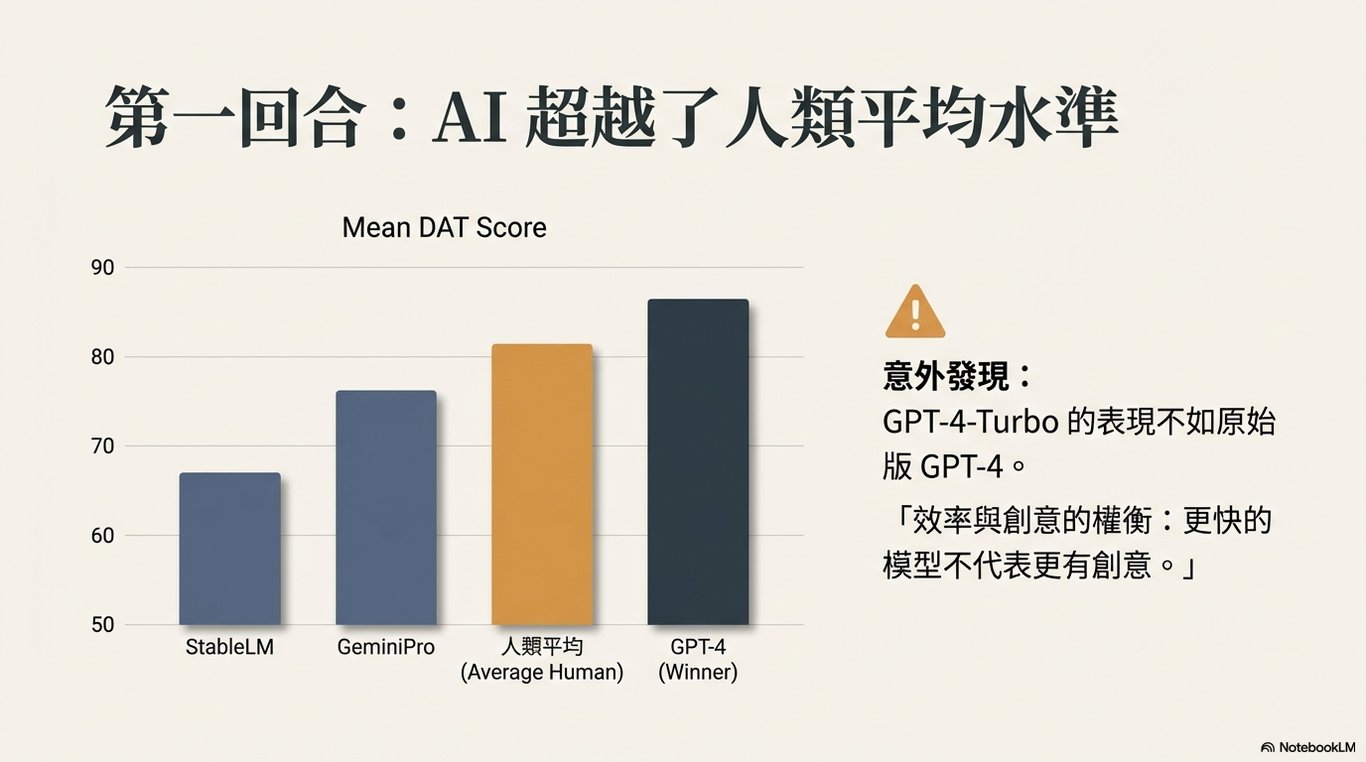

根據圖 A 的數據,主要 LLM 與十萬名人類樣本的平均 DAT 分數對比如下表所示。數據清晰地顯示,GPT-4 的平均分數顯著超越了人類平均值,而 GeminiPro 的表現則與人類在統計上無法區分 (statistically indistinguishable)。這初步證明了頂尖 LLM 在發散性聯想任務上已具備與普通人類相當甚至超越的水平。

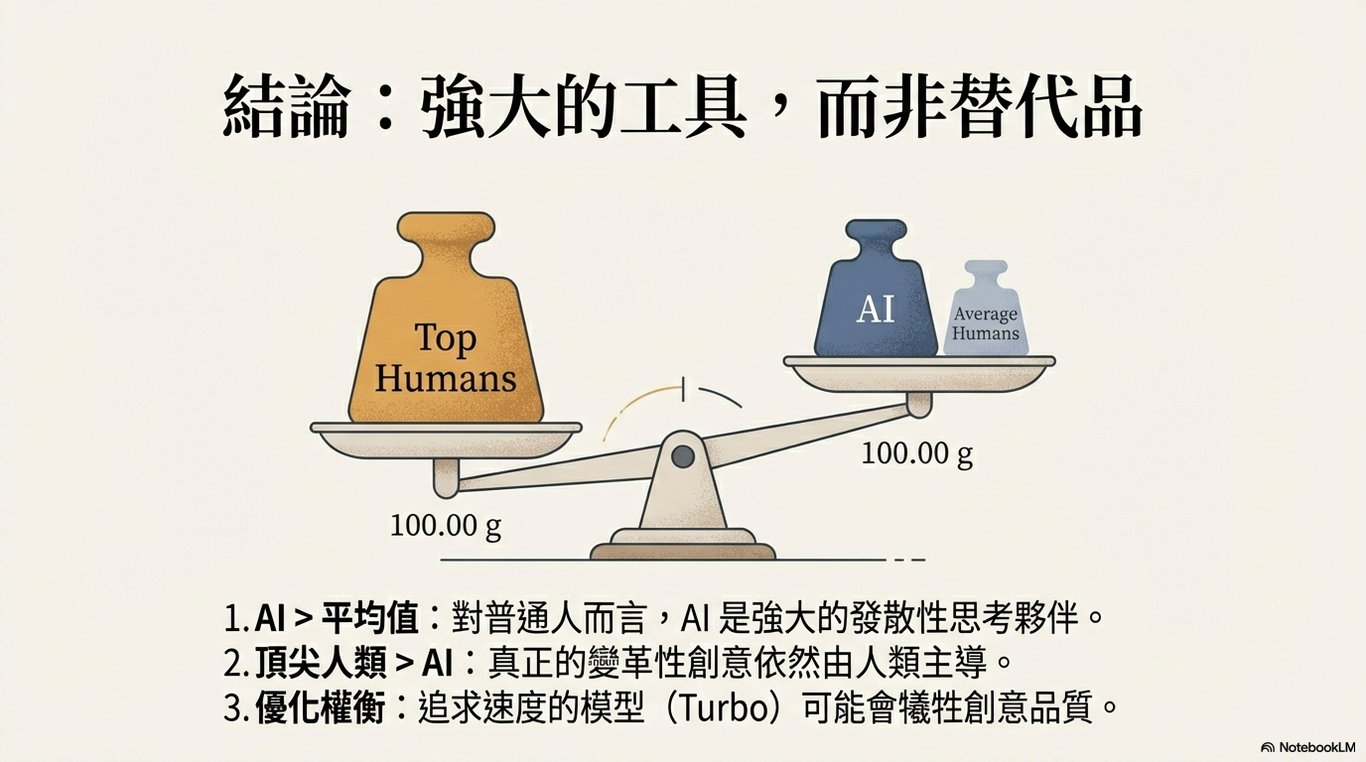

一個值得注意的觀察是,新版本的 GPT-4-turbo 在 DAT 上的表現相較於其前代 GPT-4 有明顯下降,這可能暗示模型在效率或成本優化的過程中,犧牲了部分發散性能力。

3.3 頂尖創造力的差距:LLM vs. 高分段人類

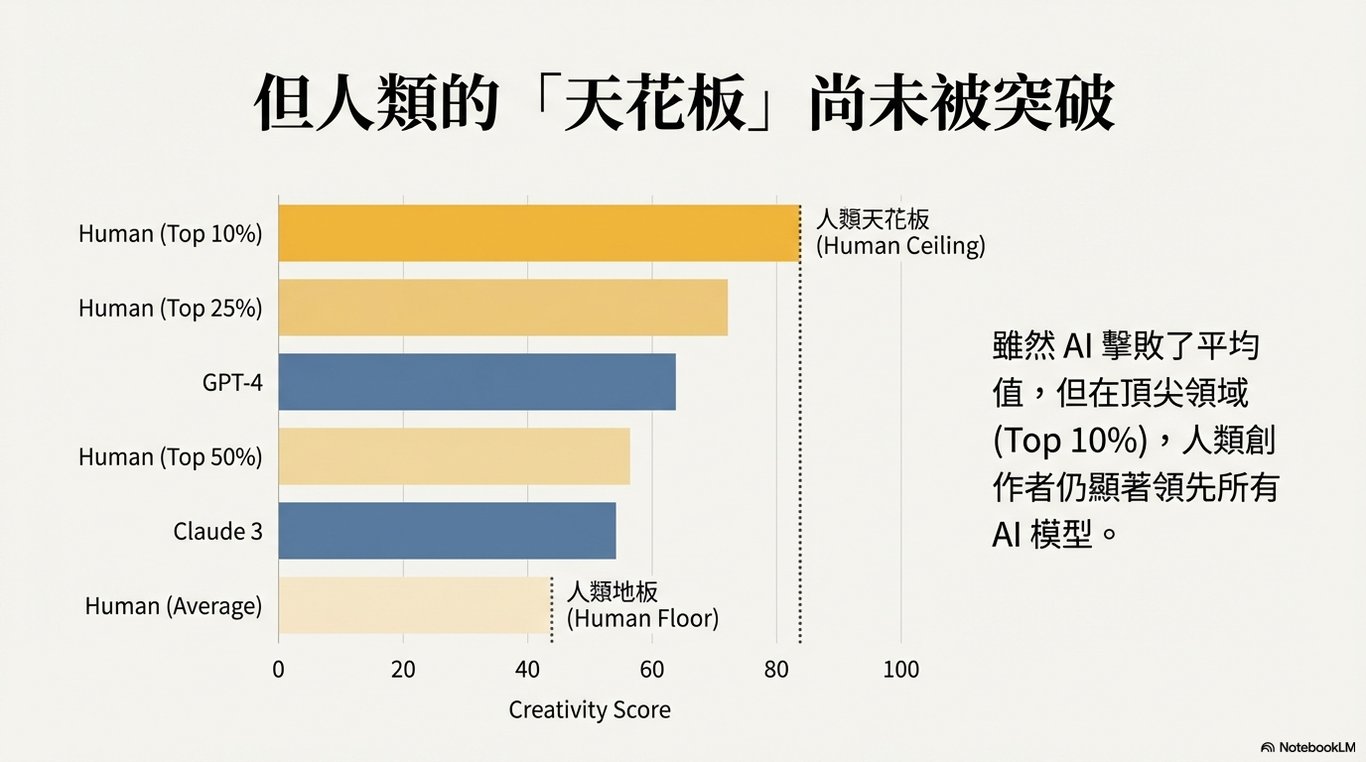

儘管頂尖 LLM 的表現超過人類平均水平,但這是否意味著它們達到了人類創造力的巔峰?研究數據揭示了一個核心發現:所有受測 LLM 的分數均低於最具創造力的人類群體。具體而言,即便是表現最好的 GPT-4,其分數也未能達到人類樣本中排名前 50%、前 25% 及前 10% 參與者的平均水平。

這一發現揭示了當前 LLM 在發散性思維方面仍存在一個明顯的「天花板」。它們可以模仿並超越普通人的表現,但距離人類頂尖創造者所能達到的高度仍有顯著差距。

3.4 模型行為模式分析:詞彙重複性

深入分析模型的回答內容,我們發現了 LLM 與人類之間一個有趣的行為差異。根據研究數據,LLM 在生成詞彙時表現出高度的重複性。例如:

在 GPT-4 的所有回答中,有 70% 包含了 "microscope"(顯微鏡),60% 包含了 "elephant"(大象)。

在 GPT-4-turbo 的回答中,"ocean"(海洋)一詞的出現頻率甚至超過了 90%。

與之形成鮮明對比的是,人類參與者最常用的詞彙(如 "car" 汽車、"dog" 狗、"tree" 樹)出現頻率均不超過 1.4%。這表明,儘管 LLM 能生成語義距離遠的詞彙組合,但它們高度依賴一套經過「優化」的特定詞彙,而人類的回答則展現出遠高於機器的多樣性與自發性。

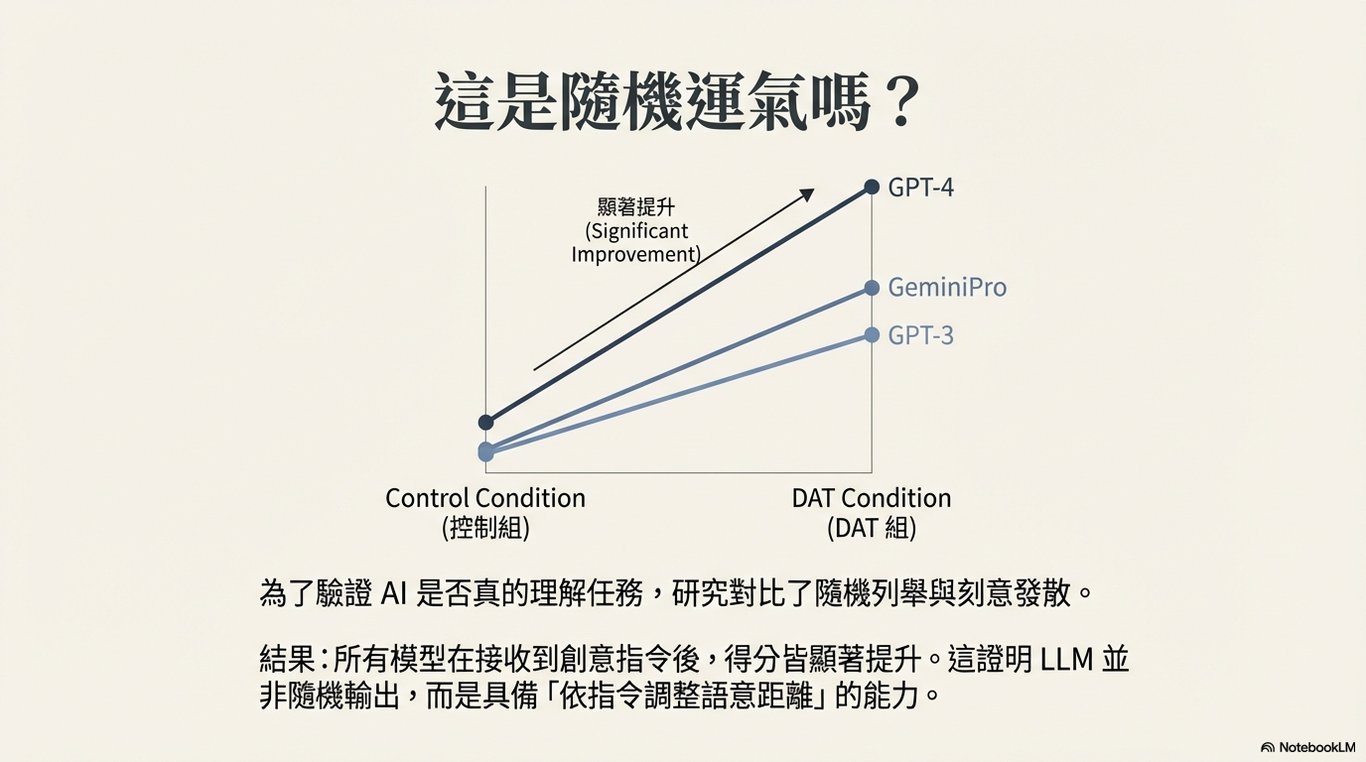

既然 LLM 的創造力表現已被量化,下一個重要問題是這種表現是否可以被主動調控。這將是下一章節的討論重點。

4. 調控 LLM 創造力:超參數與提示策略的影響

4.1 從「評估」到「操控」

本節的目標是從被動的「評估」轉向主動的「操控」,探討是否能透過技術手段來引導或提升 LLM 的創造力輸出。這對於理解模型的內部機制、發揮其應用潛力至關重要。研究發現,LLM 的創造力並非一成不變,而是可以透過調整超參數和設計提示策略進行有效調控。

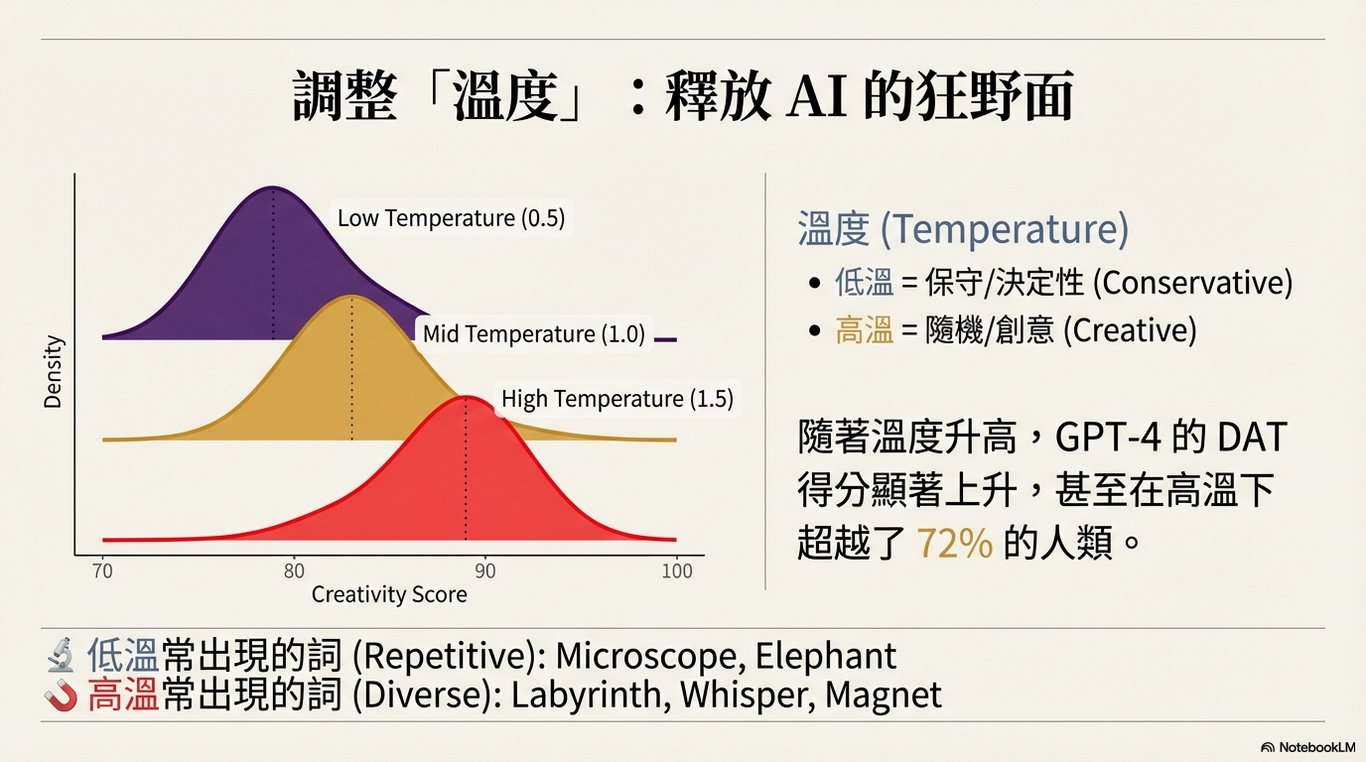

4.2 溫度超參數的影響

「溫度」(Temperature)是控制 LLM 輸出隨機性的關鍵超參數。以表現最佳的 GPT-4 為例,研究結果顯示,其 DAT 分數隨著溫度值的升高而顯著提升。

背後機制: 較低的溫度使模型傾向於選擇機率最高的詞彙,導致輸出更具確定性和重複性。相反,較高的溫度會降低這種確定性,鼓勵模型進行更多樣化、更大膽的詞彙抽樣,從而擴展其語義探索的範圍。

數據佐證: 數據進一步證實了這一點。隨著溫度從低到高,GPT-4 高頻詞彙(如 "microscope", "elephant")的重複率顯著下降,證明其生成的回應變得更加多樣化。在最高溫度設定下,其平均分數(85.6)甚至超過了 72% 的人類參與者。

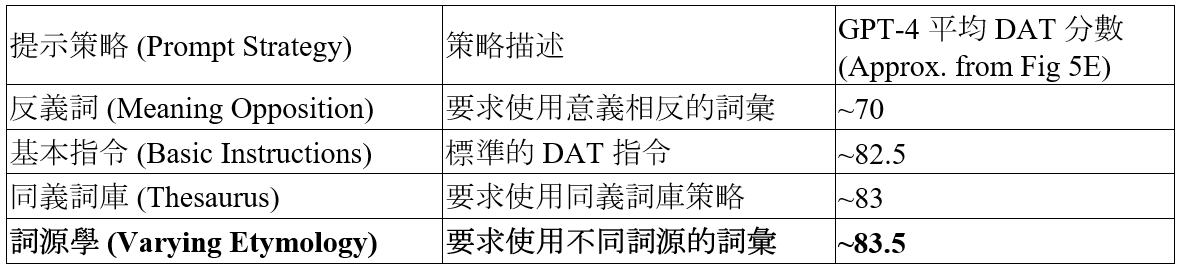

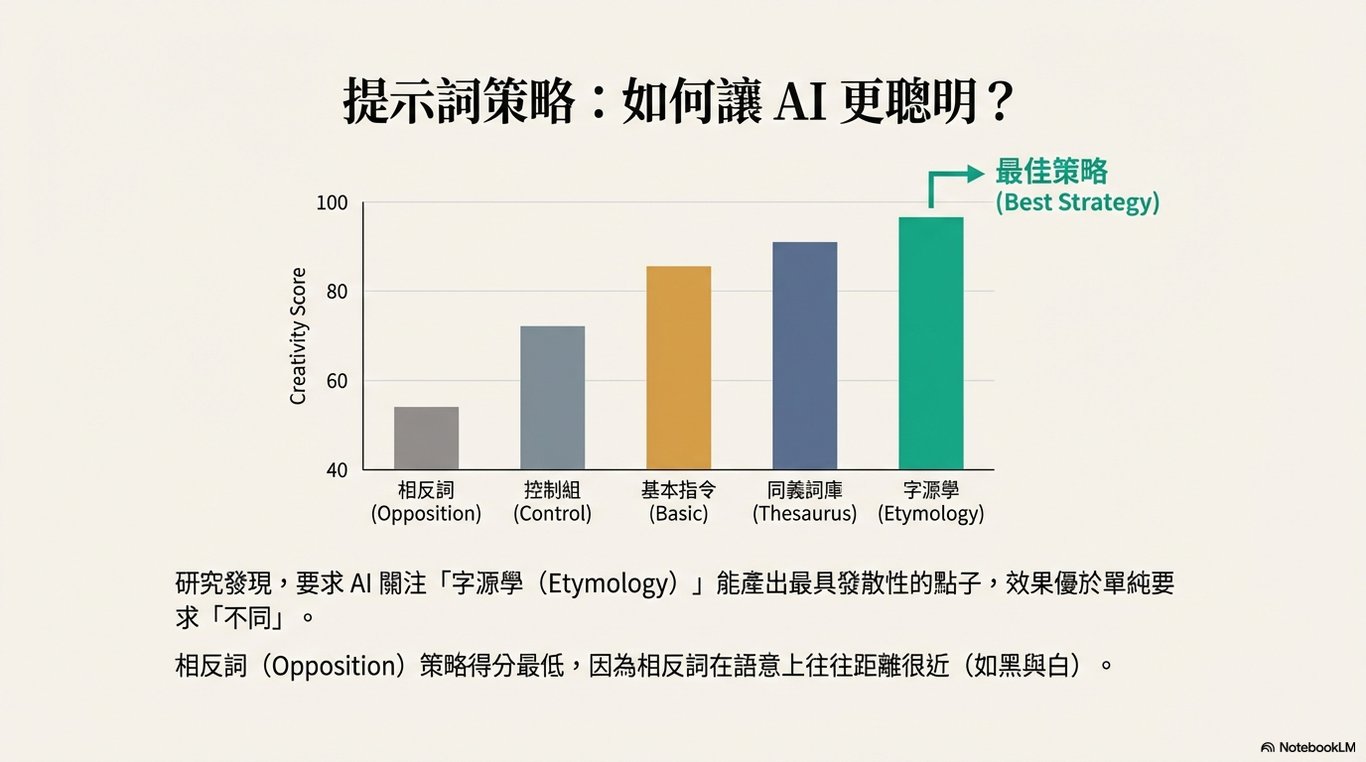

4.3 提示工程策略的影響

除了調整超參數,透過精心設計的提示(Prompt)也能顯著影響模型的創造力表現。研究比較了四種不同策略對 GPT-4 的影響,結果如下表所示。

此結果揭示了兩個重要洞見:

策略的有效性: 「詞源學」策略能引導模型探索更深層次的語義關聯,從而生成語義距離更遠的詞彙組合,顯著提升了創造力分數。相反,「反義詞」策略由於反義詞在語義上仍屬相關,反而限制了發散性。

模型的敏感性: 這表明 LLM 對於指令的細微之處高度敏感。透過設計巧妙的提示,我們可以像指揮家一樣,引導模型朝著特定的創造性方向輸出。

本節證明了 LLM 的創造力是可被主動調控的。接下來的關鍵問題是:在 DAT 任務上觀察到的表現和可調控性,是否能泛化到更複雜、更接近真實世界應用的創意寫作任務中?下一章節將對此進行深入驗證。

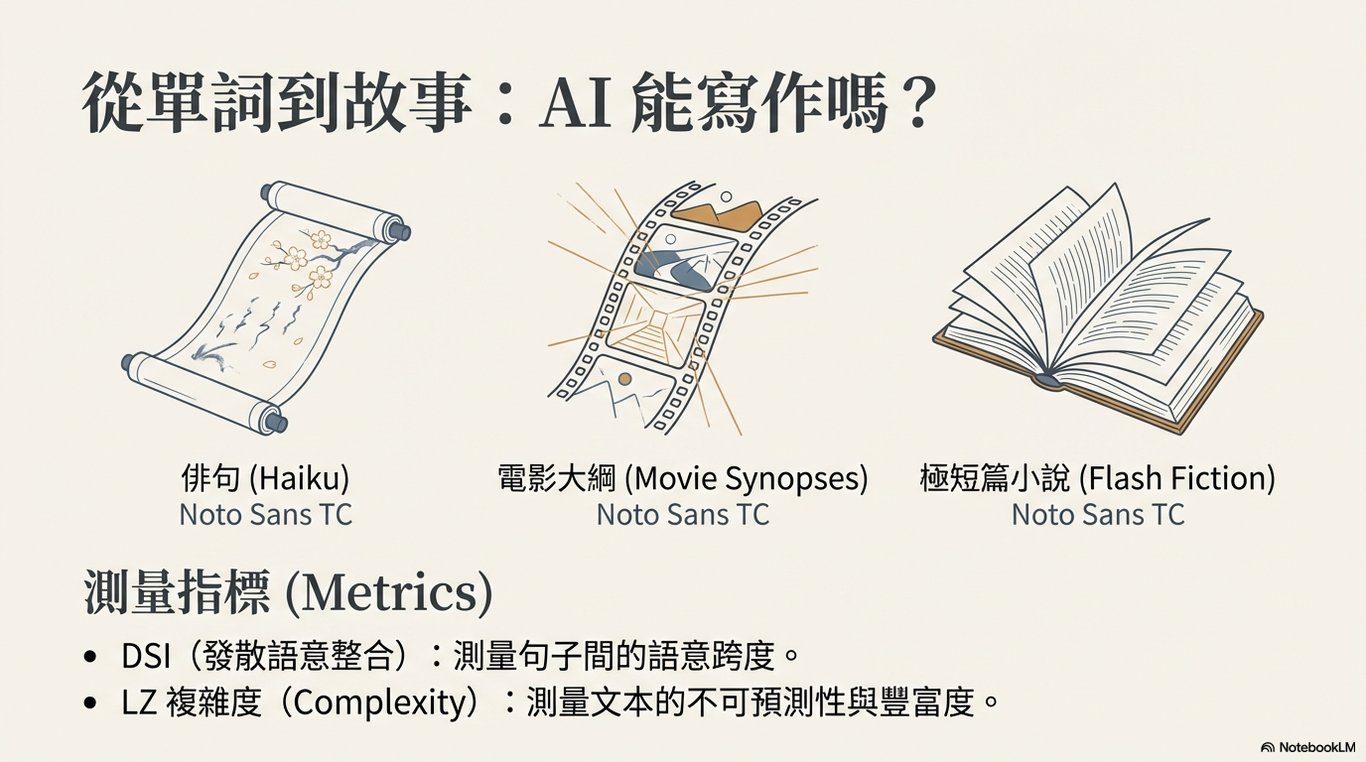

5. 泛化能力驗證:創意寫作任務表現評估

5.1 測試更廣泛的適用性

本節旨在檢驗前述在 DAT 這一詞彙級別任務上的發現,是否具有更廣泛的適用性。透過分析三種不同類型的創意寫作任務——俳句(Haiku)、電影大綱(Movie Synopsis)和閃小說(Flash Fiction),我們可以更全面地評估 LLM 在模擬人類複雜創造過程中的能力與局限。

5.2 跨任務表現一致性分析

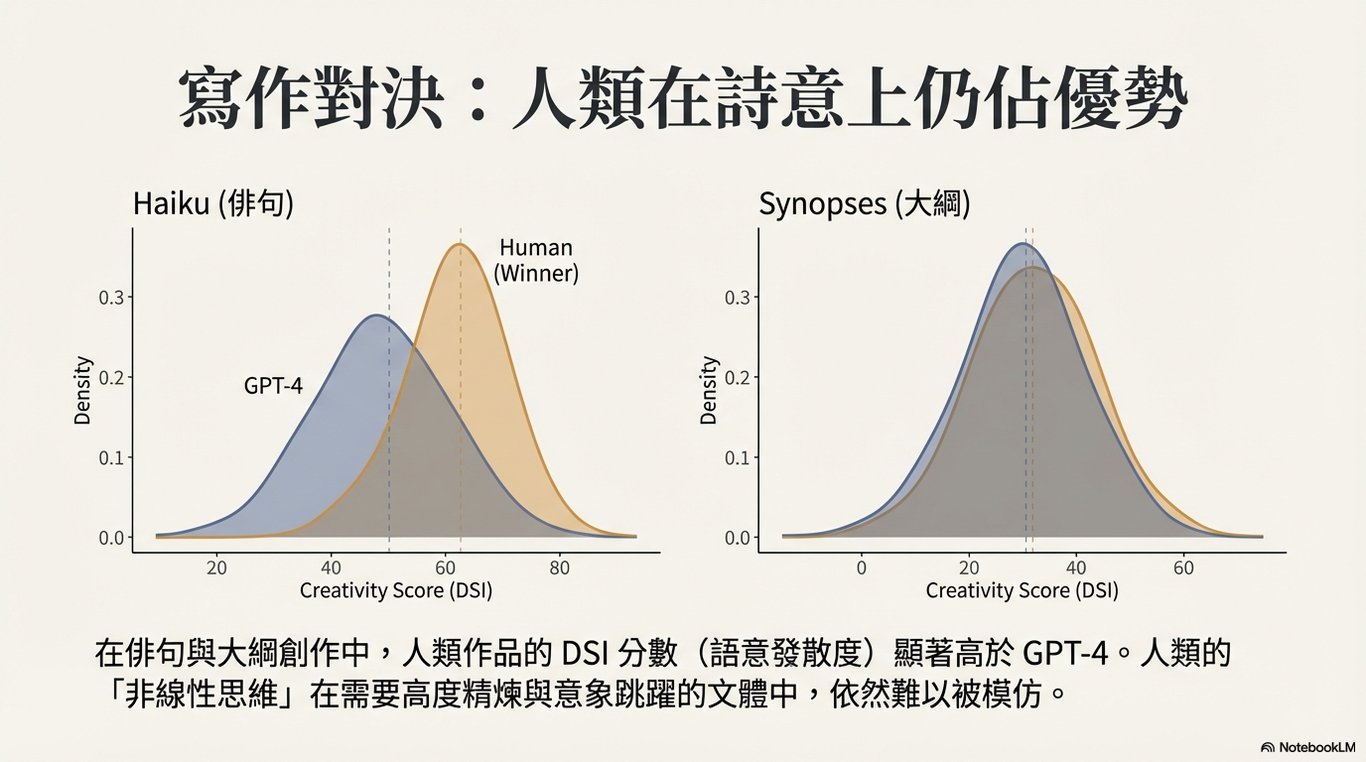

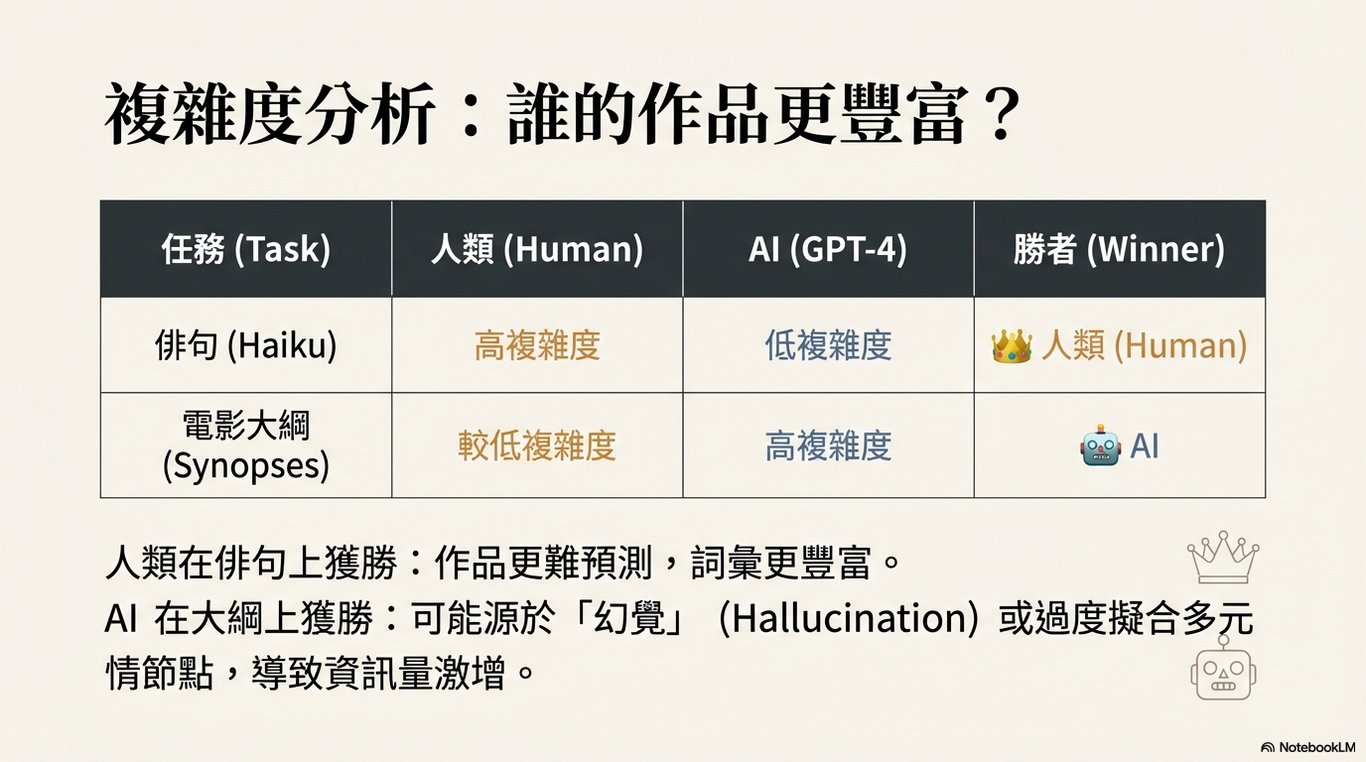

研究使用發散性語義整合(DSI)分數來評估寫作樣本的創造力。數據分析得出兩個一致的結論:

模型內部排序一致: 在所有三種寫作任務中,GPT-4 的 DSI 分數始終優於 GPT-3.5,這與它們在 DAT 任務上的表現排序相符。

人類在特定任務中仍具優勢: 一個關鍵結論是,在俳句和電影大綱這兩項任務中,人類作者樣本的 DSI 分數顯著優於所有受測的 LLM。需要注意的是,這些人類樣本(來源於電影資料庫與詩歌網站)可能來自經驗豐富的寫作者,與 DAT 的一般人群樣本不同,這可能是導致差異的一個重要因素。

5.3 溫度調控的泛化效果

溫度調控在創意寫作任務中是否依然有效?數據顯示,這種效果是可泛化的,但受到任務類型的調節。

效果顯著的任務: 在電影大綱和閃小說這類較長、結構較自由的文本中,提升 GPT-4 的溫度同樣能顯著增加 DSI 分數,這與在 DAT 上的觀察結果一致。

效果不顯著的任務: 然而,在格式嚴格的俳句中,溫度的影響則不顯著。這很可能是由於俳句嚴格的結構性約束(如 5-7-5 音節規則)限制了創意空間,使得溫度驅動的發散性難以產生顯著效果。

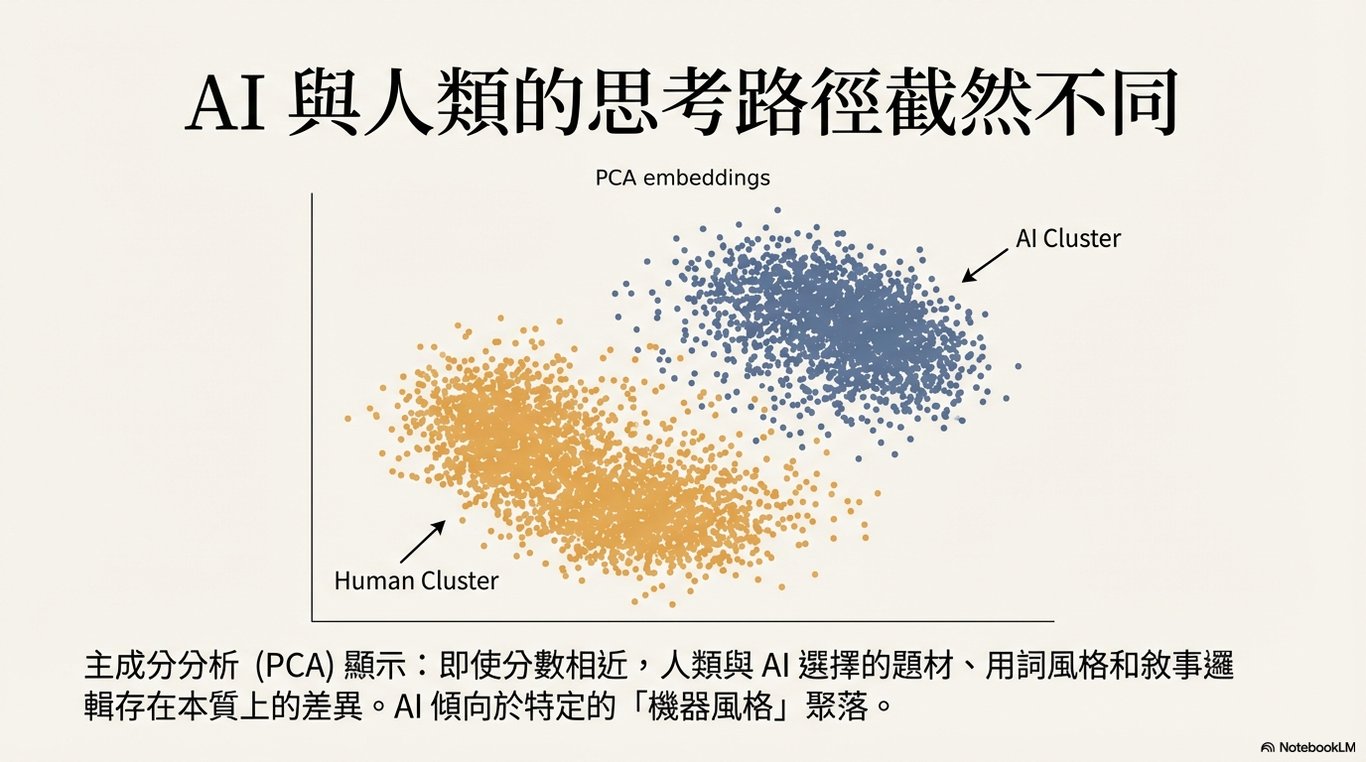

5.4 文本結構與風格的可視化分析

透過主成分分析(PCA)對文本嵌入進行視覺化,我們發現了清晰的模式:

人機差異: LLM 生成的文本與人類寫作的文本,在嵌入空間中形成了明顯區分的群集。這意味著,儘管 LLM 能模仿人類寫作,但其底層的語義結構或風格模式與人類存在系統性差異。

模型間差異: 不同 LLM(如 GPT-4、GPT-3.5、Vicuna)之間也各自佔據了不同的空間區域。這些清晰可分的群集表明,每個模型都擁有其獨特的、可被計算識別的文體「指紋」(stylistic "fingerprints")。

創意寫作任務的分析結果證實了 DAT 的部分發現可以泛化,同時也揭示了人機創造力之間更複雜的差異。接下來,我們將對所有發現進行綜合討論,探討其深層含義與未來展望。

6. 綜合討論與未來展望

6.1 整合與解讀

本節將整合前述所有實證結果,進行更深層次的解讀。我們的目標是回答最初的核心問題:LLM 的創造力達到了何種程度?這些發現對於人工智慧領域、創造力科學以及人機協作的未來究竟意味著什麼?

6.2 核心發現總結

本研究提供了一個全面的基準測試框架,其關鍵發現可總結如下:

超越平均,但不及頂尖: 最先進的 LLM(如 GPT-4)在發散性思維任務上的表現已能超越普通人類的平均水平。然而,與最具創造力的人類群體(如排名前 10% 的高分者)相比,LLM 仍存在顯著的差距,顯示出一個當前技術未能突破的「創造力天花板」。

創造力是可調控且可泛化的: LLM 的創造力輸出並非固定不變。透過調整溫度等超參數和精心設計的提示策略(如「詞源學」策略),可以有效地對其進行操控。更重要的是,這種在簡單詞彙任務上的可調控性,能夠成功泛化到故事大綱等更複雜的文本生成任務中。

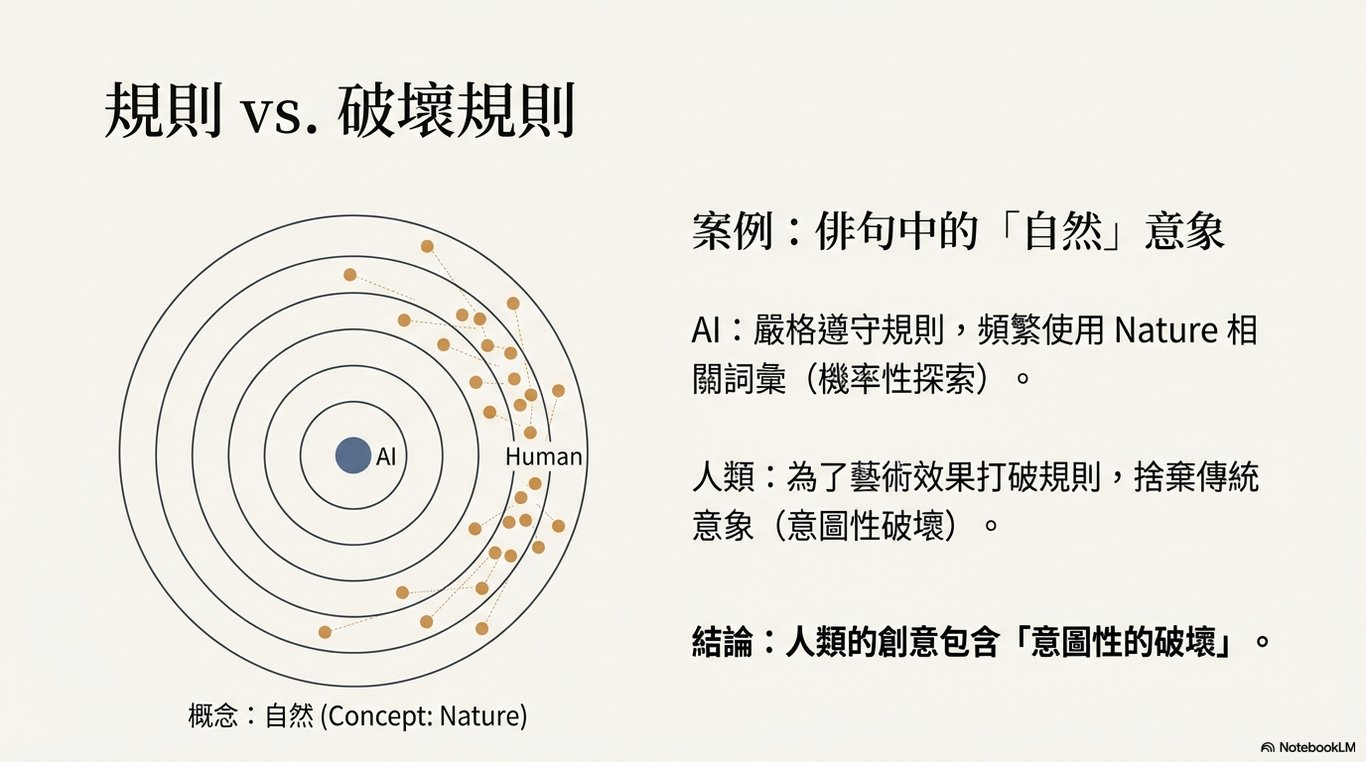

6.3 對當前創造力評估的挑戰

儘管 LLM 能在 DAT 等任務上取得高分,但我們必須認識到,其達成高分的底層機制與人類的認知過程截然不同。雖然最終的輸出可能相似,但其過程卻是根本性的差異:LLM 依賴對潛在表徵的迭代轉換(iterative transformations of latent representations),而人類的創造力則植根於具身經驗(embodied experience)、記憶與意圖。

因此,將專為評估人類認知而設計的創造力測試直接應用於 LLM,其有效性值得深思。未來的研究不應僅僅滿足於評估模型的最終輸出,而應更深入地探索其「內部過程」,例如分析其注意力流等機制,以理解其生成創意內容的真正方式。

6.4 對未來發展的啟示

本研究的結果對「AI 將取代創意工作者」這一廣泛擔憂提供了新的視角。鑑於頂尖人類與最先進 LLM 之間持續存在的創造力差距,這種擔憂在目前來看仍為時過早。當前的人工智慧系統尚難以勝任那些要求最高水平原創性與深刻洞察力的創意角色。

基於此,未來的研究方向應從「競爭」思維轉向「協作」思維。我們應探索如何將 LLM 作為強大的輔助工具,來增強而非取代人類的創造力。透過人機協作,我們不僅能開創新的藝術與科學形式,還能反過來利用這些模型,推動對創造力這一複雜現象本身的計算性理解。

6.5 研究局限性

本研究雖力求全面,但仍存在以下幾點局限性:

模型透明度: 部分商業模型的具體架構、規模等技術細節並未公開,限制了對其表現進行更深入的歸因分析。

領域發展速度: LLM 領域的發展日新月異,本報告的分析結果可能很快會因新模型的出現而需要更新。

指標的局限性: 語義距離作為衡量創造力的單一指標,雖然客觀,但無法涵蓋創造力的所有面向,如實用性、新穎性等。

數據污染風險: 由於商業模型訓練數據的不透明,無法完全排除模型在訓練過程中接觸過 DAT 相關內容的可能性,這可能成為一個潛在的混淆變量。

結論

本研究提供了一個全面的基準測試框架,首次系統性地比較了多種大型語言模型與十萬名人類大規模樣本在多種創造力任務上的表現。我們的分析從簡單的發散性聯想任務延伸至複雜的創意寫作,並探討了調控模型創造力的方法。

核心結論是,雖然 LLM 在模仿和生成看似具有創造力的內容方面取得了驚人的進展,甚至在某些指標上超越了普通人類,但人類的頂尖創造力,特別是那些位於金字塔頂端的表現,仍然是獨特且難以企及的。

最後,我們主張,應將創造力指標納入未來大型語言模型的標準評估體系中。這不僅有助於我們更全面地追蹤模型的發展,更能促進對通用人工智慧(AGI)的更深入、更細緻的理解,引導其朝著與人類智慧協同發展的未來前進。

PowerPoint

Media (English)

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!