媒體素養能將我們從AI幻覺中解救出來嗎?

一、

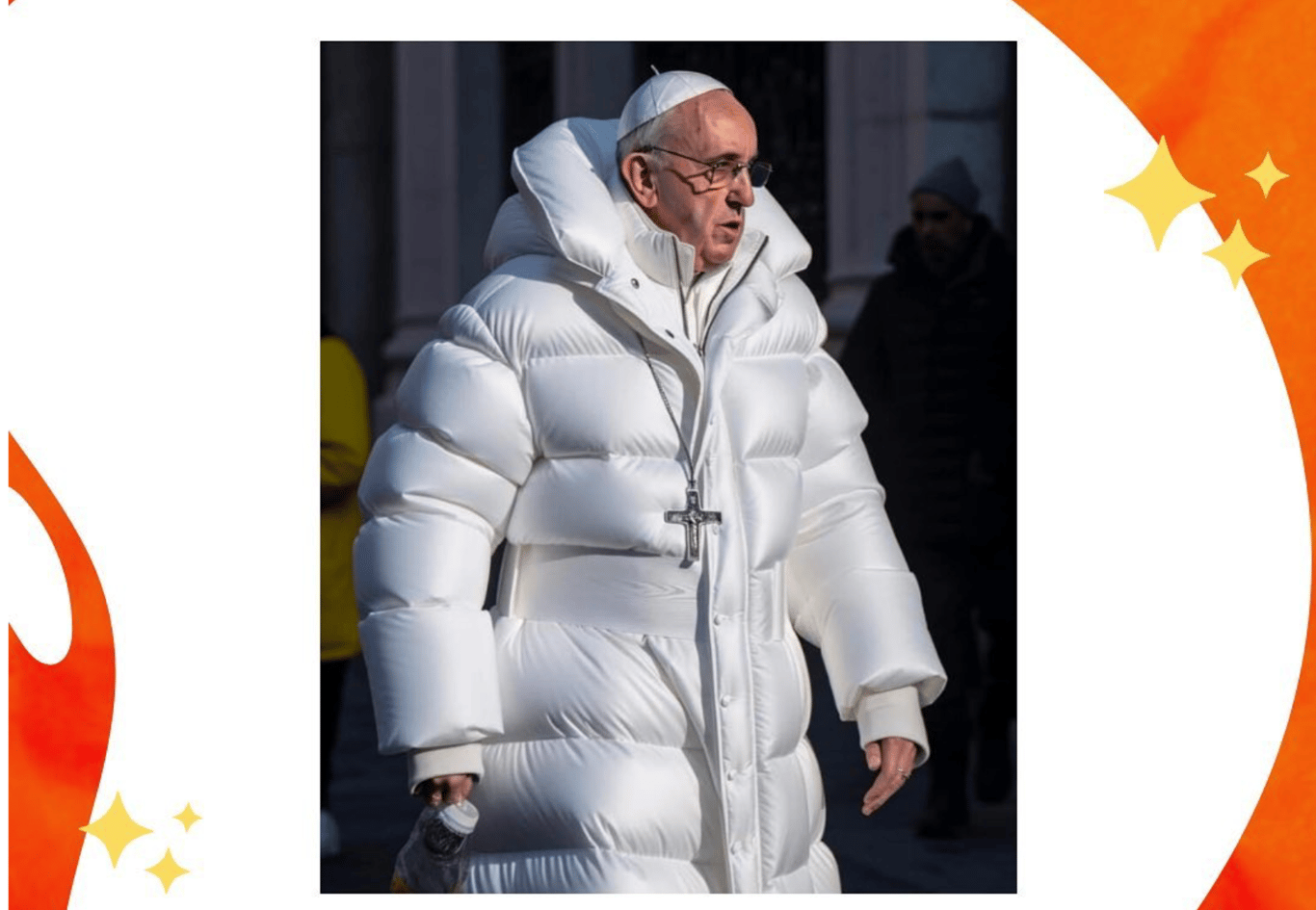

我想起了2023年3月,讓我印象最深的一條新聞:教宗方濟各穿著一件白色Balenciaga羽絨外套出現在互聯網上。我被這張照片逗得發笑:教宗表情淡定的走在街上。不得不提,那是一件漂亮的衣服,蓬鬆且有質感的面料與他平日穿的樸素長袍形成鮮明對比。

我眼見那張照片在幾小時內獲得數百萬次轉發,有人和我一樣被逗樂了,有人開始認真討論天主教會的形象策略,也有人很喜歡這件衣服,問我考不考慮買一件,我一開始甚至以為這是品牌營銷。

後來我得知,創作者是芝加哥的一位建築工人。他在使用Midjourney時隨手輸入了幾個關鍵詞——教皇、Balenciaga、街拍。幾秒鐘後,算法給了他這張照片。光影恰到好處,面料質感逼真,教皇微微駝背的姿態都令人信服。

三天後,事實核查機構宣布這是AI生成的圖像。但此時,這張照片已經被數千家媒體轉載、被無數人討論。在某種意義上,它已經成為了一個「事件」。

我注意到一位推特用戶寫道,「如果這都是假的,我們還能相信什麼?」

我在當時沒有得到這個問題的答案。但八個月後,聯合國教科文組織發布了《數位平台治理指南》。這份文件試圖為混亂的數位世界提供一個清晰的框架。它的核心建議可以總結成以下三條:培養批判性思維、推廣事實查核、要求平台標示AI內容。

學會辨別真假,你就能在AI製造的幻覺中保持清醒。這是它的邏輯。

我第一次讀這篇指南的時間其實是去年五月,當然是為了完成我的期末作業。鄰近暑假,所有的事情堆成一團,心情不佳,那天又是我最討厭的雨天。但從我的角度看,這份文件寫得很好。我喜歡充滿善意和理想主義的文章。但我讀到第十九頁時停了下來。那裡寫著:平台應該「敦促」(urges) 標示AI生成的內容。不是「要求」,不是「強制」,而是「敦促」——一個委婉到幾乎透明的詞。

那天晚上,無聊的我打開ChatGPT,讓它幫我生成一段關於媒體素養的段落,並引用三篇學術論文。它很快給了我回應:文字流暢,邏輯嚴密,三篇論文的作者、標題、期刊名稱都齊全。我逐一檢查這些引用。好笑的是,三篇論文都不存在。

無論第幾次,我總是會被AI胡說八道的能力逗笑,它能給我編造出一個作者的名字是真的,期刊的名字也是真的,只是從沒有寫出來的文章。我讓他給我介紹這些「假論文」,「假論文」的論點有時候比真論文的還像真論文,就像是它自然的存在於平行世界的某個角落,這讓我打了個哆嗦。

今天的我們面對的問題還是「如何識別真假」嗎。我想,我們面對的問題應該是「什麼是真實」。

二、

如果我們回顧歷史。是的,在科技飛速發展的這些日子裡,短短兩年前已經能成為歷史了。UNESCO的指南其實誕生在一個特殊的時刻。

一起回到2023年吧,那時ChatGPT才剛進入公眾視野,Midjourney生成的圖像開始在社交媒體上大量流傳。各國政府都在尋找應對方案,UNESCO採用的路徑則是我們熟悉的:教育。

「賦予用戶能力,」指南的第十一頁寫道,「包括通過媒體和資訊素養教育,是對抗錯誤訊息、促進健康網路參與的基礎。」

我們其實熟悉這樣的邏輯,它假設問題出在用戶身上——這不是說用戶有錯,而是說解決方案在於讓用戶變得更聰明、更警覺。它假定你學會了批判性思考,掌握了事實查核的技能,你就能在信息洪流中辨別真假。

語言的模糊性或許也是值得注意的地方,整份指南充斥著「應該」、「鼓勵」、「促進」這樣的措辭,很少使用「必須」或「要求」。到了對於平台的責任上,文件採取了一種曖昧的態度。在討論算法透明度時,指南建議平台「應考慮」提供關於推薦機制的信息。

「應考慮」——我把這個理解為:他們也可以不考慮。

我合上電腦,走在路上的時候,其實一直在想,指南沒提到的話或許更值得我們注意,如果沒有罰則,沒有監督機構,沒有問責流程。如果平台選擇不標示AI內容,會發生什麼?如果算法繼續不透明,誰來追究責任?

遺憾的是:這份文件對此保持沉默。

我隱約記得之前聽的一場Zoom報告,一位政策制定者在台上說:「我們要賦予每個公民辨別真假的能力。」台下掌聲雷動。在提問環節,一個觀眾自我介紹說她是一位中學老師,她的問題是:「如果我的學生連作業都沒時間完成,你要他們每天花多少時間去查證新聞?」

我在她說完後不久退出了會議,那些答案聽起來有些模糊,他們讚賞她提的問題的好處,說應該設置更多課程時間,但我不太想聽了,我站在圖書館的窗前。天色已經暗了下來。

我們一起做個思想實驗吧:假設你是一位認真的公民,你遵循了UNESCO的所有建議。有天,你刷到一條新聞:某國政府正在秘密開發新型武器。你檢查發文者的歷史,看起來像正常用戶。你搜索相關報導,發現幾家小型媒體也在討論。你查找原始文件,找到了一些看似官方的資料。你交叉驗證不同來源,發現它們基本一致。

一切跡象都顯示這可能是真的。於是你轉發了它。

三天後,某個事實查核機構宣布:這是一次精心策劃的虛假信息攻擊。那些「小型媒體」是專門為此創建的,「官方文件」是用AI工具偽造的,「正常用戶」是自動化機器人。整個事件是一個由AI驅動的、多層次的幻覺。

就像我幾個月前在文章「看起來像新聞的東西」裡寫到的,一個形式上像新聞的內容會讓人產生信任,不再懷疑,而一個形式像真相的內容,同樣也會讓人繞過驗證機制。

你做得很好,你遵循了每一條準則,但你還是被騙了。

原因是遊戲的規則已然改變。

三、

法國哲學家Antoinette Rouvroy在一場名為質詢社會(Society of the Query)的講座上提出了一個名為「算法治理性」——的有趣概念,她用了一個簡單的例子解釋:在數位時代,權力不通過命令運作,而通過設計環境來運作。平台不需要告訴你該看什麼,它們只需要調整算法,你自然會看到它們想讓你看到的內容。

那媒體素養教育還有意義嗎?

或許有意義。但如果它只是教你如何在一個預先設計好的迷宮裡找到出口,而不是質問為什麼這個迷宮存在,那它就會變成另一種治理工具。教育應該教會人質疑和批判。

一個理想的人類形象是什麼樣的?或許是理性的,自主的,能夠獨立判斷的,這個形象來自我們熟悉的啟蒙時代——笛卡爾的「我思故我在」,康德的「敢於求知」。在這個傳統裡,人是主體,技術是工具,界線清晰。

但這個界線還存在嗎?

在新時代,我也有了以前從不曾有的新習慣。以前我總是在寫作遇到瓶頸的時候,給靠譜的朋友發個郵件,給關係不錯的老師傳一條簡訊,和他們討論一下,往往豁然開朗。這延長了我的寫作時間,卻也製造了很多溫暖記憶,我還記得Office hour之後和老師一起去喜歡的餐廳吃美味食物的經歷。我並不是一個孤狼式作者,我喜歡與人交流的感覺。

ChatGPT在某種程度上讓這樣的機會變少了。儘管我在避免讓AI內容出現在我的博客寫作和學術寫作中,但我還是喜歡它沒有太多壓力的即時反饋。我偶爾問它一些問題。讓它給我點建議,給我點思路,我選擇一些試著往下寫,可是寫著寫著我忽然在想,這到底是誰寫的?是我嗎,還是AI?還是我們共同創作了一些什麼?

我之前讀文學理論家Hayles提出的「後人類」的概念。她有一個很微妙的觀察,她說:我們的思考、記憶、判斷已經深深嵌入技術系統中,以至於很難說哪裡是「人」,哪裡是「機器」。

我作為從小看科幻小說長大的一代人,在有生之年也有機會體驗這樣的問題,可我一時之間竟也不知道這是否是一種幸運。

她寫道:「問題不是如何抵抗AI的影響,而是如何在與AI共生的狀態下,保持倫理的、反思的、負責任的存在。」

傳統的媒體素養總是教你成為一個更好的「獨立判斷者」。但如果判斷本身已經不是獨立的活動,如果AI不僅在傳遞信息,而是在塑造你感知世界的方式,那麼「獨立判斷」這個概念還成立嗎?

幾天前我和一位研究AI哲學的同學打電話聊天。我其實被這些東西搞得非常焦慮,所以我迫切的想知道大語言模型最讓他不安的是什麼。他想了很久,說:「它們不是在複製人類知識,而是在生成某種新的知識形態。」

「什麼意思?」我問。

「傳統上,我們認為知識來自證據、經驗、推理。一個陳述是『真』的,因為它對應於現實世界的某種狀態。」他頓了頓,「但GPT生成文本的方式不是這樣的。它計算詞語之間的統計關聯,預測什麼樣的句子聽起來合理。結果就是一種既不真也不假、只是看似可信的內容。」

我給他講了AI為我生成了三篇不存在的引用的故事。我問他怎麼看,「這不是傳統意義上的造假,」他說,「而是一種新的生產方式。它在給你生成的不是謊言,是可能性。」

我不知道到底是瑞典太多雨了還是如何,那天還是雨天,後來變成了雪天,我在斯德哥爾摩的公寓裡,家人坐在窗邊的電腦前開心的打著遊戲,我聽著朋友的話,看著霧濛濛的玻璃。陰沉的天氣,忽然很想吃一碗拉麵。

我想起小時候很喜歡的一個故事,科幻作家劉慈欣的《詩雲》:外星文明為了理解人類詩歌,用窮盡法生成了所有可能的漢字組合,形成一片詩雲。那片雲裡,李白的《靜夜思》和無意義的文字垃圾並存——對算法來說,它們沒有本質區別,都只是文字的排列組合。

GPT做的事情本質上相似。它不是「知道」某篇論文存在,而是計算出:如果存在這樣一篇論文,它應該長什麼樣。那三篇引用是統計學上合理的可能性,只是這個可能性在現實中未曾實現。

這樣的真相讓我感到可怕:也許「真實」和「可信」之間,從來沒有我們以為的那麼緊密。

我忽然覺得我不是那麼喜歡那個故事了。

最近有幾個小事件。其中讓我印象深刻的是一些AI生成的「泰坦尼克號事件紀錄」開始在社交媒體流傳,有圖有文,細節豐富。幾週後,有人指出這些內容是虛假的。但此時,已經有部落格引用了它,有YouTube視頻分析了它,甚至有學生把它寫進了作業。

這個「假歷史」已經獲得了某種存在性。你無法用傳統的事實查核來對抗它。因為問題不是「這是真是假」,而是「這如何變得看起來是真的」。

UNESCO的指南預設真相是穩定的、可驗證的。它教你如何找到「正確答案」。但如果AI正在改變「正確」的意義呢?如果問題不是找到真相,而是理解真相是如何被生產、流通、鞏固的呢?

雪還在下。我關上電腦,走出了門。街上的人們有的撐著傘,有的帶著帽子,他們匆匆走過。每個人都活在自己的信息環境裡,看著算法為他們選擇的世界。

我知道,這個世界和我熟悉的那個不太一樣了。

四、

我們需要什麼?

這個問題沒有簡單的答案。但或許我想,可以從改變提問的方式開始。

不是「這是真的還是假的」,而是「這是如何被生產出來的」。不是「我如何識別AI內容」,而是「我如何理解AI正在塑造我的認知」。不是「我如何保護自己」,而是「我們如何共同創造一個更透明的環境」。

這需要的是一種新的意識。

首先,要試著反思。拒絕使用AI,在這個時代顯得困難重重,但是在使用時保持清醒,或許沒那麼困難。當你讓GPT幫你寫郵件的時候,當你接受算法推薦的新聞,當你相信某個看起來可信的內容的時候——或者可以停頓一下,抽離一下,問一下自己:這個回應為什麼令人信服?是因為它確實有道理,還是它符合我已有的期待呢?

不是一次性的查核,而是持續的對話狀態,是awareness。你可能要和AI共同生產意義,但你保持著對這個過程的意識,要覺察。

之後,或許系統性思維也是重要的。信息不是憑空出現的,而是在複雜的技術、經濟、政治系統中被生產、篩選、傳播的。當你看到一條「研究發現」的新聞,要問的也許不只是研究是否存在,還要問:這個研究是誰資助的?它的數據從何而來?為什麼這個敘事在這個時間點被放大?

或者還要有一點技術素養。倒不至於說每個人都學寫代碼,而是可以開始學習一些基本原理:知道算法如何決定我們看到什麼?大語言模型為什麼會有「幻覺」?訓練數據如何影響AI的偏見?需要了解的不是技術細節,而是權力知識。當我們試著理解了算法的運作邏輯,就可以在一定程度上理解是誰在控制你的信息環境。

但我想到的最重要的一條是從個人責任轉向集體行動。

我們作為個體如何聰明,也無法對抗系統性的操縱。一個人可以學會辨別假新聞,但當算法每天向十億人推送精心設計的誤導信息時,個人的抵抗是微不足道的。

我們需要一些數位公民權的概念。知道什麼算法在對你做什麼,控制自己的數據如何被使用。當AI做出影響你的決定時,你有權知道原因。不被強制接受算法推薦。這些不是公司的恩賜,它需要透過立法、監管、集體談判來爭取的權利。

歐盟已經開始了這個嘗試。2024年通過的《人工智能法案》要求高風險AI系統必須可解釋,必須接受人類監督。《數位服務法》給了用戶選擇非個性化推薦的權利,大型平台必須向監管機構解釋算法邏輯。這些不是完美的,執行也充滿挑戰,但它們承認了一個基本事實:不能把所有責任都推給用戶。總有人會覺得歐盟過於保守,但我在這一點上肯定有人嘗試拉住韁繩的行為。

當然,法律總是滯後的。當歐盟還在討論如何監管GPT-4時,GPT-5已經出現了。但這不是放棄監管的理由,而恰恰說明我們需要更快、更靈活的制度回應。

平台的責任是這裡最難迴避的問題。為什麼我們總在談論「教育用戶」,而很少談論「監管平台」?

如果一家食品公司售賣有毒食品,我們不會說「消費者應該學會辨別毒素」。但在數位世界,我們卻接受了一個奇怪的邏輯:平台可以設計極度容易傳播謊言的系統,然後把責任推給用戶。

這個邏輯必須被挑戰。算法決定了什麼內容被看到、被放大、被推薦。

如果一個行為是編輯行為,那就應該承擔編輯責任。

具體來說:算法推薦的邏輯必須對監管機構透明。當假信息造成實際傷害,平台應該承擔法律責任。用戶應該有權選擇關閉個性化推薦。

至於「AI生成內容必須標示」——老實說,這可能是最難實現的。技術上就有巨大障礙:誰來判定什麼算「AI生成」?一段文字50%是AI寫的、50%是人類改寫的,算不算?更別說執行層面的困難:跨國平台、匿名發布、技術繞過。

也許更現實的不是完美的標示系統,而是程序正義。在特定高風險場景——新聞、醫療建議、法律文件——強制披露AI使用。平台提供工具,讓創作者選擇標示AI協作。發展AI檢測技術,雖然這本身就是一場永無止境的競賽。

重點不是完美的解決方案,而是承認不能把所有責任都推給用戶。

五、

在我寫到這裡的時候,外面沒有下雨,但是在刮風,今天氣溫一下下降了將近五度,我明天可能需要穿羽絨服出門了。

說到羽絨服,我就又想到了那張讓教皇穿上羽絨服的圖片。它看起來那麼真實,我都想到了它可能是一條營銷內容,卻沒想到是虛假信息,在真相揭曉時,人們的第一反應不是憤怒,而是困惑。如果這都是假的,我們還能相信什麼?

也許這個問題本身就問錯了。

問題不是「我們還能相信什麼」,而是「在一個真相不再穩定的時代,我們如何負責任地生活」。AI也和其他技術一樣,開工沒有回頭箭,我們無法指望回到過去,我能預見一個生成式內容越來越多的時代,真實和虛構的界線會持續模糊。我們無法回到一個真相清晰可辨的時代——可是,那個時代也許從未存在過。AI之前,我們也面對過大量的虛假信息。

我相信,UNESCO的媒體素養方案代表了一種善意的信念:相信教育可以讓我們重新掌控真相。

但掌控不是答案,共處才是。

這不是說放棄判斷。恰恰相反,是要發展一種更複雜的能力——在使用AI時保持反思,在接受信息時追問生產邏輯,在個人努力之外尋求集體改變。是要承認我們已經無法站在技術之外,但仍可以在技術之中保持清醒。

去年秋天,我在做報告的時候也講這個話題。一個學生和我有些沮喪地說:「聽起來我們什麼都不能確定了。」

我想了想說:「不是什麼都不能確定,而是確定的方式變了。以前我們確定一件事,是因為它對應現實。現在我們確定一件事,是因為我們理解它是如何被生產、為什麼被生產、被誰生產的。這種確定性更脆弱,但也許更誠實。」

她似懂非懂地點點頭,然後離開了。走出教學樓的時候,周圍只剩下我一個人。碼頭的遊船裡也亮起了橙色的燈光。

AI在重新定義知識、真相、現實。我們可以參與塑造它。不是作為孤立的用戶,而是作為有權利的公民;不是作為被動的接收者,而是作為主動的共創者。我們在指南之外,也需要走得更遠。

教皇可以在一夜之間穿上任何衣服,AI可以為我們編造看似完美的引用,真相本身變得流動——我們需要的不是更好的「真相眼鏡」,而是學會在這片流動中游泳。

不是抵抗水流,而是理解水流的方向,知道自己在其中的位置,並選擇向哪裡游去。

這不會容易。但這是今天的我們必須學習的生存方式。

現在,街燈亮了。我收拾好東西,走出圖書館。雨後的空氣裡有股清新的味道。人們從我身邊走過,每個人都低頭看著手機,螢幕的光映在他們臉上。

我也掏出手機,打開了一個新聞app。算法已經為我準備好了今天的世界。我沒那麼想要回到2019年了。

我好像也沒那麼討厭下雨了。

寫在後面的話:

這個題目其實來自於我今年夏天的同題期末論文。這是一個特別有趣的問題,我很感激我的老師提出一些很好的題目讓我們討論和書寫。儘管學業壓力還是蠻大的:)。

半年之後的今天我又產生了一些新的思考,我仔細閱讀了來自教授的反饋,想把它重新寫一遍,發表在我的博客上。所以就有了這篇文章。祝你閱讀愉快。

當然,如果你讀到了這裡,可能會想:那我現在該做什麼?

我想,今天就可以做的事情是,在使用ChatGPT時,試著留意它的回應如何影響你的思路。看到一條新聞時,不只問「這是真的嗎」,也問「這是誰說的、為什麼現在說」。也可以去設置裡看看你常用平台的推薦算法選項。

還有些事情需要更多時間的——可以找一些AI入門書讀讀。關注你所在地區關於AI監管的立法討論。如果你有興趣,我覺得我參考文獻裡就有一些很適合閱讀的內容,如果你讀了,我會很開心。當然,也可以和朋友、家人聊聊他們如何使用和思考AI,你也可以在評論區討論,或者發消息給我,我們一起聊聊。我會很開心。

更長遠的,我想,如果你剛好是教育工作者,或許可以思考如何把「理解AI」納入課程。如果你是政策制定者,考慮更強的平台問責機制。如果你和我一樣,只是一個普通人,記住:你有權利要求一個更透明、更公正的數位環境。

每個改變都是從提問開始的。祝你愉快思考,健康生活!

我的參考文獻:

Hayles, N. Katherine (2025). Bacteria to AI: Human Futures with our Nonhuman Symbionts. University of Chicago Press.

Pasquinelli, Matteo (2023). The Eye of the Master: A Social History of Artificial Intelligence. Verso Books.

Rouvroy, Antoinette (2022). "Algorithmic Governmentality" in More Posthuman Glossary. Bloomsbury Academic.

UNESCO (2023). Guidelines for the Governance of Digital Platforms.

謝謝你的喜歡

- 来自作者

- 相关推荐