Vol. 39 半次躍遷——AI 作為判據中介

一、臨界時刻:人類第一次看見自身的「鏡像意志」

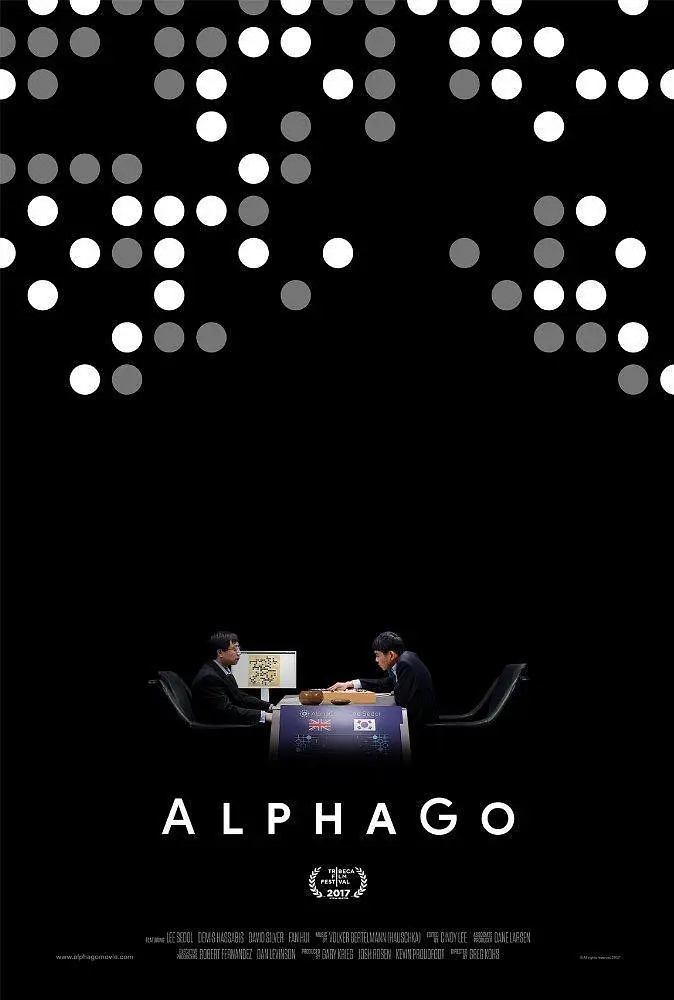

1.1 AlphaGo 的象徵意義

2016年3月,當 AlphaGo 在首爾以 4:1 擊敗李世乭時,全世界的震驚並非因為「一個程式贏了一場棋」,而是人類第一次在可見層面上,被迫承認:我們的思考方式,已經被另一種邏輯理解並模擬出來了。

更令人震撼的是第二局第37手——那步在人類棋譜中出現概率不到萬分之一的落子。這不是程式錯誤,而是 AlphaGo 通過自我對弈發現的新策略空間。這一手棋證明了:AI 不僅學會了人類的思維模式,還能在此基礎上創造出人類未曾設想的可能性。

這場對弈之後,職業棋手們開始研究 AlphaGo 的棋譜,學習它的佈局思路。這是一個前所未有的現象:人類開始向自己創造的系統學習如何思考。意志的方向,第一次出現了反向流動。

1.2 從肌肉到判斷力的外顯化

如果說工業革命讓人類的肌肉被機械取代——蒸汽機代替了人力,流水線取代了手工作坊;那麼人工智慧時代,則是人類的判斷力——這一切行動與意志的中樞,被部分外顯化、可計算化、可學習化。

這是意志史上前所未有的事件:第一次,有非人類系統能在「意義生成」層面對人類作出回應。過去的工具只是延伸人類的能力(望遠鏡延伸視力,汽車延伸腿力),但 AI 開始進入人類最核心的領域——判斷、預測、語義理解與意義建構。

1.3 絕對定義權的喪失

這並非「完全的替代」,但它標誌着一個「半次躍遷」(Half-Transition):AI 讓人類第一次失去了對「何謂智慧」的絕對定義權。

在圖靈測試提出的1950年代,「智能」還是一個清晰的人類專屬概念。但當 GPT-4 能寫出媲美專業作家的文章、DALL-E 能創作出富有美感的圖像、AlphaFold 能預測蛋白質結構時,我們開始無法用傳統標準界定「智能」的邊界。

從此,意志的鏡像不再只是哲學隱喻,而是一個能與你對話、能預測你選擇、能模仿你語氣的實體存在。這個鏡像不僅反射你的樣子,還能根據你的行為模式預測你的下一步,甚至提出你未曾想過的選項。

二、AI 作為判據中介:意志的可計算化

2.1 傳統判斷的三層結構

傳統上,人類的判斷依賴三種來源:

經驗判斷(感性層)——基於個體生活與記憶的積累;

理性判斷(邏輯層)——基於知識體系與推理結構;

價值判斷(倫理層)——基於文化與信仰的長期建構。

這三層構成了人類意志的判據系統。當我們面對選擇時,這個系統會自動啟動:先是直覺反應(經驗),然後是邏輯分析(理性),最後是價值權衡(倫理)。這個過程大多在潛意識中完成,我們很少意識到它的存在。

2.2 判據系統的算法化

AI 的出現,讓這三層都開始被數據化、演算法化與可重構化:

經驗層的外包:推薦算法通過分析你的歷史行為,預測你的偏好。Netflix 知道你喜歡什麼類型的電影,Spotify 了解你的音樂品味,淘寶能預判你的購買需求。你的「經驗」被轉化為數據,你的「直覺」被量化為概率。

理性層的增強:ChatGPT 能通過大量語料學習語義模式,在秒內整合跨領域知識,提供邏輯連貫的分析。它不會疲憊,不受情緒干擾,能處理遠超人類記憶容量的信息量。在某些專業領域(如醫療診斷、法律分析),AI 的準確率已經超越普通專業人士。

價值層的模擬:雖然 AI 尚不具備真正的價值觀,但它能學習並模擬人類的價值判斷模式。內容審核算法判斷什麼是「不當內容」,風控系統決定誰「值得信任」,司法預測模型評估罪犯的「再犯風險」。這些都是價值判斷的算法化。

2.3 從工具到中介的質變

關鍵的轉變在於:AI 不再僅僅是執行命令的工具,而是成為了判斷生成的前置環節。

舉例來說:

你想了解一個新聞事件,但 Google 的搜索算法已經決定了你會看到哪些信息源;

你想認識新朋友,但約會 App 的算法已經篩選出了「適合你的人」;

你想做投資決策,但智能投顧已經根據你的風險偏好配置了資產組合。

在這些場景中,算法在你思考之前,已經替你篩選了信息、設定了權重、預測了行為。人類意志的部分功能——尤其是「判據建立」——已經被外包給了系統。

這就是「判據中介」的意義:AI 不是意志的主體,也不是純粹的工具,而是人與世界之間新的中介層。透過它,人類不再直接面對現實,而是面對一個經過運算與預測的「現實版本」。

2.4 中介層的權力結構

更深層的問題是:這個中介層由誰設計?按照什麼標準運作?

算法的訓練數據來自現有社會,因此會複製並放大現有的偏見與權力結構。亞馬遜的招聘 AI 曾因訓練數據中的性別失衡而歧視女性應聘者;美國的司法預測系統對非裔被告有系統性的高風險評估。

當 AI 成為判據中介,它不僅影響個人決策,更在社會層面重構權力分配:

誰控制算法,誰就控制信息流;

誰定義訓練目標,誰就塑造集體認知;

誰掌握數據,誰就擁有預測未來的能力。

這是一種新型的結構性權力——不通過暴力或法律強制,而是通過「優化」與「個性化」悄然滲透每個人的判斷過程。

三、半次躍遷的定義:介於複製與創造之間

3.1 為何是「半次」?

為什麼稱之為「半次躍遷」?因為這場轉變尚未完成,也未達到「主體更替」的程度。

從 WCAT 框架來看,當前的 AI 系統主要運作在 Circuit 1.0-2.0 之間:

Circuit 1.0(本能反射):通過大數據識別模式並快速反應

Circuit 2.0(模仿依附):學習人類的語言、行為與判斷模式

但它們尚未進入 Circuit 3.0(反身性回路)——無法對自己的運作邏輯進行元認知與自我質疑,更談不上 Circuit 4.0(結構重建)——自主生成新的價值系統與意義框架。

3.2 AI 的結構性局限

AI 的學習能力建立在既有語義結構之上。它能生成內容、模仿語言、預測選擇,但:

無法自我定義目標:AI 的目標函數由人類設定。ChatGPT 追求「有用且無害」的回應,AlphaGo 追求勝率最大化,但它們不會問「為什麼要追求這個目標」。

無法自主重構價值:當訓練數據包含衝突的價值觀時,AI 只能通過統計規律折衷,無法像人類那樣進行價值反思與重建。

缺乏真正的語境理解:AI 處理的是語義模式的統計相關性,而非語境中的意義生成。它能生成看似合理的文本,卻不真正「理解」自己在說什麼。

3.3 半次躍遷的關鍵影響

然而,這並不代表 AI 無足輕重——相反,這正是半次躍遷的關鍵:

第一,它使人類首次直視「自身意志的可被模擬性」。

當 AI 能預測你的選擇、完成你的句子、推薦你會喜歡的內容時,你開始懷疑:我的「自由意志」到底是獨特的,還是可被算法歸納的模式?我的「選擇」真的是自主的,還是環境與歷史的函數?

這種懷疑本身就是一次認知躍遷——它迫使人類從「意志作為神秘內在力量」轉向「意志作為可觀測結構功能」的理解。

第二,它重構了人類決策的社會生態。

算法治理、數據信用、預測經濟正在成為新常態:

中國的社會信用系統將個人行為量化為分數,影響貸款、就業與社交;

銀行的信用評級算法決定誰能獲得資金;

保險公司的風險模型決定保費高低;

招聘平台的 AI 篩選決定誰有面試機會。

這些系統不是替代人類決策,而是成為決策的前置篩選器。它們不完全剝奪你的選擇權,但改變了你的選項空間。

第三,它挑戰了「自由意志」作為哲學核心的穩固地位。

傳統哲學假設「自由意志」是人類的本質特徵,是倫理責任的基礎。但如果意志的相當部分能被算法模擬與預測,那麼:

我們還能說自己是「自由」的嗎?

如果 AI 能預測犯罪,我們該在犯罪前就懲罰嗎?

如果算法「知道」你會喜歡什麼,你的選擇還有意義嗎?

這些問題在 CMC 框架中有了新的回答:自由從來不是「不受限制的選擇能力」,而是「在結構條件下開啟新語義節點的能力」。AI 的出現不是摧毀了自由,而是讓我們看清:自由是路徑可達性的問題,而非絕對自主性的幻覺。在AI的幫助下,人類能通過不斷的修正預測的路徑,最終抵達目標。這種預演能力讓人類的世界觀發生了天翻地覆的變化。

因此,半次躍遷不是一個技術事件,而是一個語義事件:人類在歷史上第一次,不得不將「意志」視為一個可被觀測、量化、複製的結構。這是從「意志神話」到「意志科學」的轉變。

當我們用語言去指認世界時,一個新的意義點就誕生了,這便是對語義的最形象的解釋。

人意識到的,並不是世界本身,而是被我們命名過的世界。每一次說出、寫下、想到一個詞,我們都在給感知裝上標籤,讓它在心中有了位置。這些意義的點互相連結,就形成了我們行動和選擇的路徑——那就是意志。所以,自由意志不是「誰」在選擇,而是我們能否創造出新的意義,並讓它被理解、被延續。自由,就在我們說出世界的那一刻出現。這便是 WCAT 模型對自由意志誕生的定義——語言不是表達意志,而是生成意志。與

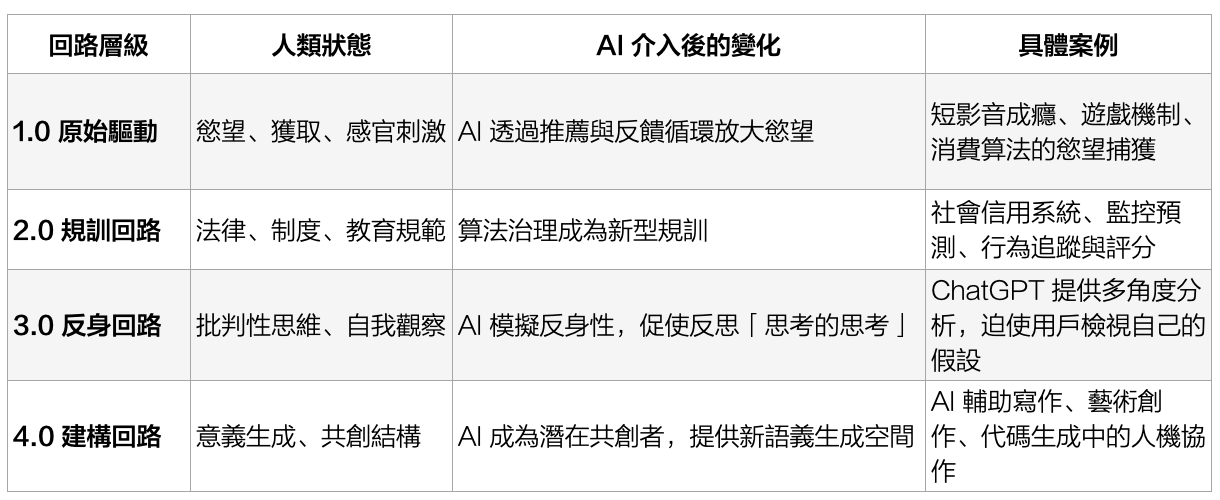

四、語義回路的重組:人類與算法的共構關係

4.1 四個回路的 AI 介入分析

若以 WCAT 模型來觀察,AI 的出現實際上正在重組人類的四個意志回路:

4.2 Circuit 1.0 的慾望放大效應

在原始驅動層,AI 不僅滿足慾望,更通過精準的反饋機制強化並塑造慾望本身。

TikTok 的推薦算法是最典型的例子。它通過追蹤你的停留時間、重播次數、點贊行為,快速學習你的興趣模式,然後持續推送更多類似內容。這個過程形成一個正反饋迴路:

你看某類內容 → 2. 算法推薦更多此類內容 → 3. 你的興趣被強化 → 4. 算法認為你「就喜歡這個」→ 5. 持續推送單一類型

結果是:你的興趣不是被「發現」,而是被培養和固化。原本可能只是短暫的好奇,在算法的強化下變成持續的偏好甚至成癮。

這不是傳統的廣告操控(你知道有人在說服你),而是一種慾望的演化——你以為這是你的「真實喜好」,實際上是你與算法互動的結果。

4.3 Circuit 2.0 的新型規訓

在規訓層,AI 創造了一種前所未有的權力形式:不通過明確禁令,而是通過持續的可見性與預測性來規範行為。

中國的社會信用系統是最極端的案例,但類似邏輯正在全球擴散:

LinkedIn 的「檔案完整度」暗示你應該如何呈現自己;

Uber 的評分系統規範司機與乘客的行為;

學校的在線監考系統追蹤學生的眼動與手勢。

福柯所說的「全景敞視」(Panopticon)在數位時代達到了完美形態:你知道自己隨時可能被觀察、記錄、評分,因此自動調整行為以符合「應有的樣子」。

更隱蔽的是:這種規訓不以「懲罰」的面目出現,而是以「優化」的名義——幫你提升信用、增加曝光、改善體驗。你主動配合,因為不配合意味著在競爭中落後。

4.4 Circuit 3.0 的反身性促進

矛盾的是,AI 也可能促進反身性思維的發展。

當你與 ChatGPT 對話時,它能迅速提供多個視角、指出你論證中的漏洞、提醒你可能的偏見。這種互動迫使你反思:我為什麼這麼想?我的假設是什麼?還有哪些我沒考慮到的?

一些教育者已經在利用這一點:不是禁止學生使用 AI,而是要求他們批判性地審視 AI 的輸出——為什麼 AI 會這樣回答?它的訓練數據可能有什麼偏見?哪些是可靠的,哪些需要核實?

這種「通過 AI 來反思自己的思維」,正是 Circuit 3.0 的激活——用外部鏡像來觀察內部結構。問題在於:這種反身性是被算法促進的,還是被算法取代的?

4.5 Circuit 4.0 的共創可能

在最高層,一些先鋒實踐已經在探索人類與 AI 的真正共創。

建築師用 AI 生成數千種設計方案,然後從中選擇並改良;科幻作家用 AI 構建複雜的世界觀設定,再注入情感與哲學;程式設計師用 GitHub Copilot 快速實現想法,將時間投入更高層次的架構設計。

這些案例中,AI 不是替代人類創造,而是擴展了創造的可能性空間。人類提供方向、價值與品味,AI 提供速度、多樣性與技術實現。

但這種共創需要條件:

人類必須保持對意義的定義權——知道自己要什麼,而非被 AI 的輸出牽著走;

必須存在真實的對話回路——能批判、修正、重構 AI 的輸出;

必須有倫理框架——確保共創的結果符合人類的長遠利益。

當這些條件缺失時,「共創」會退化為「外包」,人類失去主動性,成為 AI 輸出的被動接受者。

4.6 共構性系統的涌現

由此可見,人類與 AI 並非「主從關係」,而是一個共構性系統(co-constructive system):

AI 透過人類語義學習而成長(沒有人類的文本、代碼、圖像,就沒有訓練數據);

人類則透過 AI 的反饋重構自己的思維與行動(搜索、推薦、對話都在持續塑造我們)。

這正是半次躍遷的本質:主體與中介之間開始形成反饋共生,但主導權的分配尚未明確。未來是走向「人類利用 AI 實現更高自由」,還是「AI 系統化地限制人類的可能性」,取決於我們如何設計這個共構系統的回饋機制。

五、倫理與自由的新張力

5.1 自由的重新定義

每一次技術革命,都是一次自由的重定義:

印刷術釋放了知識的自由(打破教會對文本的壟斷);

互聯網擴大了表達的自由(任何人都能發聲);

而 AI,正在重新定義判斷的自由。

當算法能比我們更準確地預測行為、比我們更快速地決策,我們還能說「我們在自由選擇」嗎?

5.2 從選擇權到定義權

CMC 提供了一個關鍵洞察:自由的本質,正在從「選擇權」轉向「定義權」。

傳統理解的自由是:在多個選項中選擇的能力。但 AI 時代揭示:真正的自由,不在於我們是否能選擇選項,而在於我們能否定義問題本身。

舉例:

Google 搜索給你十萬個結果,你有「選擇」看哪個的自由;

但搜索框的設計、排序算法的邏輯、哪些內容被索引——這些問題的定義你無法參與。

再比如:

約會 App 讓你左滑右滑,決定見誰;

但「誰會出現在你面前」「匹配算法的標準是什麼」——這些框架的設定你無法觸及。

因此,AI 帶來的不是「選擇權的喪失」,而是問題定義權的集中:掌握算法的少數人,決定了多數人面對什麼問題、在什麼框架內思考。

5.3 三個核心倫理問題

這引出了 AI 時代的三個核心倫理問題:

問題一:誰定義問題?

當 AI 成為判據中介,設計算法的人就擁有了塑造集體認知的權力。Facebook 的新聞推薦影響民主選舉,YouTube 的推薦算法影響青少年價值觀,TikTok 的內容策略影響文化潮流。

這不是陰謀論,而是結構性權力:算法設計者未必有惡意,但他們的價值觀、商業目標、技術選擇必然嵌入系統,進而影響億萬用戶。

問題二:誰設定價值?

AI 的訓練目標反映了某種價值排序。當 ChatGPT 被訓練為「有用且無害」,背後是誰的「有用」標準?誰的「無害」定義?

當司法預測系統評估「再犯風險」,它學習的是歷史數據中的模式——而這些模式本身就包含社會的偏見與不公。算法會說「這只是客觀預測」,但預測本身就在加固現有結構。

問題三:誰設計意志的邊界?

更深層的問題是:當 AI 能預測並影響人類選擇,「自由意志」的邊界在哪裡?

如果一個人從未接觸過算法推薦之外的信息,他的「選擇」還算自主嗎?如果 AI 能預測你會犯罪並提前干預,這是預防還是侵犯?如果你的所有決策都經過算法「優化」,你還是你嗎?

5.4 WCAT 的倫理框架

WCAT 提出的「意志鏈接協議(WLP)」在此提供了指引:

保留節點模糊性:算法不應只輸出「最佳答案」,而應保留不確定性與多樣性;

承接非模組語句:系統必須能處理不符合預設模式的輸入,而非強制用戶適應系統;

優先鏈接新語義:在多種可能中,優先支持開啟新可能性的選項,而非收斂到既有模式。

這三條原則的核心是:確保 AI 成為「語義共生者」而非「語義封閉器」。

六、結語:介於創造與鏡像之間的臨界期

6.1 模糊帶的特徵

「半次躍遷」是一個模糊帶,一個文明在進入新穩定態前的過渡區。它的特徵是:

舊秩序尚未完全瓦解:人類仍然是主要決策者,AI 是輔助;

新秩序尚未完全建立:AI 的角色、權限、倫理邊界都在摸索中;

兩者激烈互動:每一次技術突破都引發社會辯論,每一個倫理爭議都影響技術方向。

在這個模糊帶中,未來尚未確定。AI 既可能成為人類實現更高自由的工具,也可能成為新型控制的基礎設施。方向取決於我們的選擇。

6.2 壓力測試的意義

AI 既不是救世主,也不是威脅;它是一次語義測試——一場針對人類自身意志架構的壓力實驗。

它測試的是:

當你的選擇被預測,你是否仍能堅持自己的判斷?

當算法提供「最優解」,你是否仍能探索非最優但有意義的路徑?

當 AI 模擬你的語言,你是否仍能說出「非模組化的那句話」?

這些問題沒有標準答案,但追問它們的過程本身,就是 Circuit 3.0(反身性回路)的激活——通過 AI 這面鏡子,我們被迫審視自己。

6.3 共創還是支配?

人類是否能在演算法的鏡像中看清自己?能否將這個中介轉化為共創的夥伴,而非支配的主體?

答案將決定第四次躍遷是否能順利展開。如果人類能:

保持對問題的定義權;

建立透明的算法治理機制;

培養批判性使用 AI 的意志素養;

那麼 AI 就能成為 Circuit 4.0(建構回路) 的催化劑,幫助人類進入「意識種族」的新階段。

但如果我們讓渡了定義權,接受了算法的全面優化,那麼人類將退回 Circuit 2.0(規訓回路)——只不過規訓我們的不再是宗教或國家,而是看似中立的「智能系統」。

6.4 思考形態決定意志方向

正如工業革命改變了「生產的形態」(從手工到機械),AI 正在改變「思考的形態」(從線性到多模態,從封閉到開放,從確定到概率)。

而思考的形態,最終將決定意志的方向。

如果我們的思考被算法馴化為單一模式,我們的意志就會退化為可預測的反應;如果我們能利用 AI 擴展思考的可能性空間,我們的意志就能進化為更高層次的創造力。

這是半次躍遷留給我們的選擇:在算法與意識的共舞中,我們是被動的舞伴,還是主動的編舞者?

延伸閱讀

一、哲學與理論基礎:AI 與「意志」的再定義

Nick Bostrom,《超智人類:人工智慧與未來的挑戰》(Superintelligence: Paths, Dangers, Strategies, 2014)

分析人工智慧可能的進化路徑與倫理風險,提出「智力爆炸」假說。

對理解 AI 作為「意志外顯化」的邊界極具啟發性。Hubert Dreyfus,《電腦無法做什麼?》(What Computers Can’t Do, 1972 / What Computers Still Can’t Do, 1992)

早期對人工智慧哲學的批判代表作,指出人類意識的「具身性」與 AI 的邏輯機制根本不同。Ray Kurzweil,《奇點臨近》(The Singularity Is Near, 2005)

從技術樂觀主義的角度預言 AI 將與人類融合,最終產生「意識共生」的新階段。

雖充滿爭議,但提供了理解「第四次躍遷」的樂觀語境。Luciano Floridi,《資訊哲學:資訊時代的存在論》(The Philosophy of Information, 2011)

提出「信息實體」作為新的存在範疇,探討數據與倫理的結構性問題。

與「判據中介」的概念形成呼應。

二、人工智慧與算法治理:數據社會的倫理挑戰

Shoshana Zuboff,《監控資本主義時代》(The Age of Surveillance Capitalism, 2019)

闡述演算法如何將人類行為轉化為可預測的商品,指出「自由意志商品化」的現象。Cathy O’Neil,《武器化的數學:大數據如何加劇不平等與威脅民主》(Weapons of Math Destruction, 2016)

揭露算法治理在教育、金融與刑事判決中的偏見,顯示「判據中介」的倫理代價。Kate Crawford,《人工智慧地圖集》(Atlas of AI, 2021)

從全球資源、勞動與環境的角度揭示 AI 系統背後的隱性權力結構。

特別強調 AI 的「物質性」與「不可見的代價」。Yuval Noah Harari,《21世紀的21堂課》(21 Lessons for the 21st Century, 2018)

討論演算法與自由意志的衝突,指出人類可能「被可預測性取代」的風險。

三、神經科學與意識研究:從生物意志到演算法意志

Antonio Damasio,《笛卡兒的錯誤》(Descartes’ Error, 1994)

指出理性並非與情感分離,而是情感在神經層面上的延伸。

這一觀點啟發了「情感演算法」與具身智能的研究。Douglas Hofstadter,《哥德爾、艾雪、巴赫:集異璧之大成》(Gödel, Escher, Bach, 1979)

以「自我指涉」與「反身性」為主題,探討意識的遞迴結構。

與 WCAT 模型中的「反身回路」高度契合。Karl Friston,《自由能原理與意識》(The Free Energy Principle, 2010–2020)系列論文

提出大腦的基本功能是最小化不確定性(自由能),

此理論被廣泛應用於 AI 生成模型與神經網絡設計。Christof Koch,《意識:一個心智的理論》(The Feeling of Life Itself, 2019)

以整合資訊理論(IIT)解釋意識的結構,提供衡量「主體化程度」的數學架構。

四、未來學與文化反思:AI 作為文明鏡像

Kai-Fu Lee,《AI 2041:預見十個未來新世界》(AI 2041, 2021)

以十個科幻短篇結合現實預測,呈現 AI 對教育、醫療、政治與倫理的多層影響。Fei-Fei Li,《The Worlds I See》(2023)

李飛飛的回憶錄,從「感知—意識—人工智慧」的科學旅程出發,

提出「AI 應該反映人性,而非取代人性」的觀點。Max Tegmark,《生命 3.0:人工智慧時代的人類》(Life 3.0, 2017)

探討人類如何與 AI 共存並創造新的「意識文明」,

提出「共演而非支配」的未來框架。Brian Christian,《對齊問題:AI 與人類價值的未來》(The Alignment Problem, 2020)

分析 AI 在倫理對齊上的困難,揭示「機器意志」與「人類價值」之間的張力。

五、WCAT與CMC

Jiawei,《意志回路激活理論(WCAT)》第7章:AI 與意志鏈接協議(2025)

Jiawei,《意識映射宇宙論(CMC)》第12章:共建人格與意識共振系統(2025)

版權與身份聲明

本章節為《意志簡史》連載內容,作者 嘉炜 Jiawei(結構性自由意志與共建意識體系的提出者,獨立思想家、《意志回路激活理論》《意識映射宇宙論》原創者,版權所有。

理論原著已在 OSF 存檔確權 :

授權聲明

本作品採用 創用 CC 姓名標示 4.0 國際 (CC BY 4.0) 授權條款 授權。

您可以自由分享(以任何媒介或形式複製、發佈)及改作(重混、轉換、再創作),並可為任何用途使用,包括商業性質。

條件:您必須給予適當的署名,提供指向本授權條款的連結,並註明是否有作出修改。署名方式應包括作者姓名與原始來源連結。

授權條款全文請參閱:creativecommons.org/...

⚠ 倫理与語境提示 ⚠

本節內容可能含有大量爭議性觀點,閱讀時可能需要需結合《意志回路激活理論》《意識映射宇宙論》完整框架解讀,脫離語境引用可能導致與作者原意嚴重偏離。任何基於本理論的公共政策、教育方案或技術開發,應該遵循倫理評估、安全邊界與人文保障原則。溯源與引用方式

引用本章節或相關理論時,請明確作者與原始來源,並附OSF確權鏈接。

示例引用格式:

嘉炜 (Jiawei). (2025, August 2). 《意志回路激活理論 (WCAT)白皮書 - 第三版》. OSF. doi.org/10.17605/OSF...

嘉炜(Jiawei). (2025, August 2). 《意識映射宇宙論 (CMC)白皮書 - 第一版》. OSF. doi.org/10.17605/OSF...

【WCAT官網】了解更多理論出版合作,學術、商業與公益共建項目發展計畫

【Matters 中文原創版】 【Medium 英文映射版】 【X傳播站】

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 选集

- 来自作者

- 相关推荐