📝📝:全球 AI 發展進入「奧本海默時刻」?│ 美國啟動「AI 曼哈頓計畫」站穩科技霸主

本文參考自 Epoch AI 針對 AI 曼哈頓計畫的技術報告《How big could an "AI Manhattan Project" get?》

AI 曼哈頓計畫(The AI Manhattan Project),已經從先前的臆測性討論,轉變為美國政府高層政策制定中的嚴肅議題。

美中經濟與安全審查委員會(US-China Economic and Security Review Commission)近期的建議,以及美國能源部(Department of Energy)的公開聲明,都顯示出:

人工智慧的發展可能需要如同當年製造原子彈、登月計畫那樣的全國性投入與決心。

從原子到演算法

當年真正的曼哈頓計畫在高峰期占用了美國 GDP 的 0.4%,若按今日幣值計算,相當於約 1220 億美元。而阿波羅登月計畫(Project Apollo)的投入更甚,高達 GDP 的 0.8%,換算後約為每年投入 2440 億美元。

AI 曼哈頓計畫也將沿用相似的原則,但面對的挑戰則截然不同。這次的計畫不再是提煉鈾或製造火箭,而是集中運算資源、加速晶片生產,並克服能源基礎設施的限制。其終極目標,是透過前所未有的運算規模推進通用型人工智慧(AGI)的實現。

這項構想背後的急迫性,主要在於愈來愈多的證據顯示,AI 發展已成為國家安全與經濟競爭力的核心。隨著 OpenAI、Google 等私營企業不斷突破大型語言模型與神經網路的極限,落後於這場技術競賽的戰略風險已無法再被忽視。

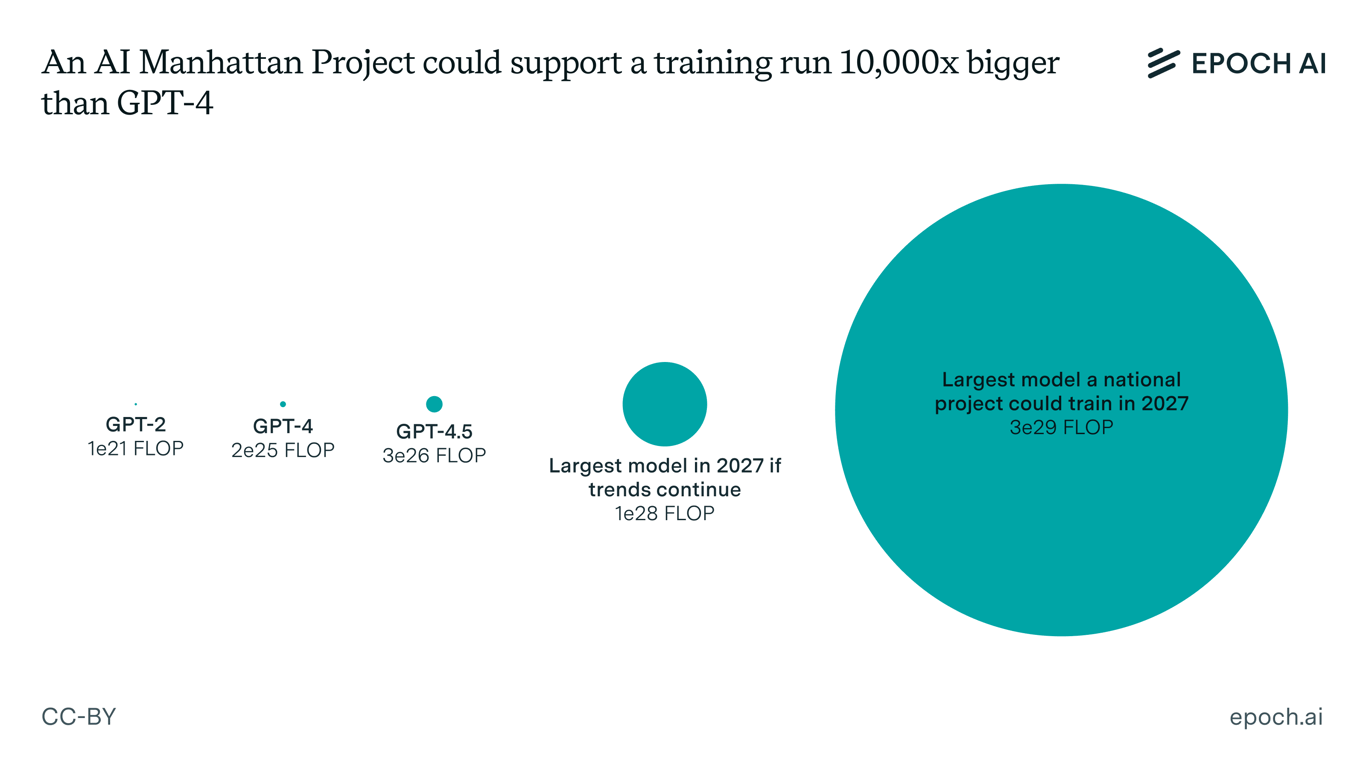

比 GPT-4 大一萬倍

Epoch AI 的分析顯示,若啟動 AI 曼哈頓計畫,至 2027 年底將有可能完成一次約為 2×10²⁹ 次浮點運算(FLOP)的訓練作業。這相當於迄今為止最耗資的模型所使用計算量的 500 倍,比 GPT-4 所需的 2.1×10²⁵ FLOP 整整多出一萬倍。

如此規模的運算擴張,將成為人類歷史上最劇烈的科技加速之一。

其影響將遠超出 AI 能力的線性增長。如此龐大的計算資源,有可能促成在機器學習架構、訓練方法論以及 AI 系統設計上的突破,這些都是現有資源下無法觸及的技術門檻。

能否實現這種規模,取決於幾個關鍵因素。

首先,以當前 GPU 技術的性價比來看,在所預估的投資水準下,獲得足夠的計算能力並非天方夜譚。以NVIDIA 的 H100 GPU 為例,其在 FP16 精度下的每秒每美元浮點運算能力約為 2.2×10¹⁰ FLOP。

若美國在三年內每年投入 2440 億美元,進行 100 天訓練,理論上可達成 1.2×10²⁹ FLOP 的總運算量。

FLOP 是什麼?跟 FLOPS 差在哪?

在人工智慧領域的技術報告中,FLOP 或 FLOPs 是個非常重要的專業術語,代表著浮點運算次數 (Floating-point Operations)。

簡單來說,FLOPs 用來衡量一個 AI 模型在執行單次計算(例如,處理一張圖片或一段文字)時所需的數學運算量。這些數學運算通常是涉及小數的加減乘除,因為 AI 模型在處理數據時,常常將輸入轉換為浮點數進行計算。

FLOPs 的重要性

為什麼 FLOPs 在 AI 領域這麼重要呢?

衡量模型複雜度

FLOPs 是一個衡量 AI 模型「有多複雜」的重要指標。FLOPs 越高,代表模型需要進行的運算越多,通常也意味著模型更大、更複雜。

預估計算成本

在訓練或推論 AI 模型時,需要大量的計算資源。

FLOPs 可以幫助研究人員和工程師預估模型所需的計算量,進而評估訓練時間和硬體成本。例如,一個 FLOPs 數很高的模型,在訓練時可能需要數週甚至數月的時間,並且需要昂貴的 GPU 資源。

比較模型效率

在比較不同的 AI 模型架構時,FLOPs 是一個很好的衡量指標。你可以比較兩個不同模型的 FLOPs 數,來了解模型在計算效率上的差異,而不需要考慮具體是在哪種硬體上運行。

節能與優化

高 FLOPs 也就代表著更高的能源消耗。在追求 AI 模型的高效能、低耗能的目標時,降低 FLOPs 是優化模型的關鍵目標之一。

這裡有個經常會讓人混淆的地方:

FLOPs(小寫 s)

指浮點運算次數,通常用來衡量模型的計算或演算法的計算複雜度。例如,一個模型在處理一張圖片時需要 10 億次 FLOPs。

FLOPS(大寫 S)

指「每秒」浮點運算次數 (Floating-point Operations Per Second),通常用來衡量硬體的計算性能。例如,一個 GPU 可能有 100 TFLOPS 的性能,表示每秒能執行 100 兆次的浮點運算。

你可以把 FLOPs 想像成工作量(有多少工作要做),而 FLOP 想像成是工作速度(多快能完成工作)。

動員 2700 萬張 GPU

要實現 AI 曼哈頓計畫的運算需求,約需 2700 萬張 H100 等級 GPU 協同運作。目前的大型 AI 訓練通常使用上千張 GPU,但從「千」規模跳升到「千萬」等級。

Meta 的 Llama 3

Meta 提到,他們訓練最大型的 Llama 3 模型時,是在兩個自建的 24K GPU 集群上進行的,並實現了在 16K GPU 上同時訓練的高效能。這表示在峰值訓練時,Meta 使用了數萬張 GPU。

OpenAI 的 GPT-3 (1750 億參數)

雖然具體數字沒有公開,但估計 GPT-3 的訓練需要數百到數千張 NVIDIA A100 等級的 GPU。

DeepSeek R1

據報導,DeepSeek R1 模型訓練使用了 2048 張 H800 GPU。

Claude 3 Opus

根據一些報導和分析,Anthropic 訓練自家的頂級模型(例如 Claude 3 Opus)很可能使用了數千到數萬張高階 GPU。

如此大量的 GPU 導入將需顛覆性的晶片間通訊技術、記憶體層級設計以及分散式訓練演算法。系統必須處理數 PB(千兆位元組)等級的資料流動,同時保持神經網路訓練所需的精密同步。

散熱與冷卻系統亦是一大難關。若 2700 萬張 GPU 同時運作,其熱能輸出幾可匹敵一座中型城市的耗電量。傳統的風冷系統將完全失效,勢必得依賴先進的液態冷卻技術,甚至包括沉浸式冷卻或其他更具前瞻性的方案。

系統的穩定性也是另一項令人咋舌的挑戰。在擁有數百萬個硬體元件的情況下,故障將成為常態。AI 訓練軟體必須從一開始就以容錯設計為核心,確保即使某些元件故障或汰換,整體訓練仍可不中斷地持續進行。要達成這種韌性,勢必要對分散式系統架構與檢查點技術(checkpointing)進行翻新。

國家級 AI 會是吃電怪獸

在 AI 曼哈頓計畫中,最令人卻步的一環,或許正是龐大的能源需求。

若要同時驅動 2700 萬張 H100 等級 GPU,將需約 7.4 十億瓦(gigawatts)的持續電力供應,這不僅超過紐約市的年平均用電量,甚至會直逼世界最大核電廠(日本的柏崎刈羽核電廠)的耗能等級。

從技術角度來看,將 7.4 吉瓦的電力集中於單一地點,或僅數個據點,將對既有電網基礎設施造成極大壓力。電力傳輸系統、變電站與配電網路都需進行全面升級,甚至重建,才能承載如此龐大的負荷。

然而,EPOCH AI 的分析仍指出,儘管挑戰嚴峻,這些能源問題並非無法克服。光是 2027 年美國計畫新增的天然氣發電容量就達 8.8 吉瓦,理論上足以支撐此計畫的需求。

歷史上,美國已有在特定區域集中大規模發電的先例,而《國防生產法》(Defense Production Act)則提供了優先發展能源基礎設施的法源依據。

替代方案也值得探索,例如加速德州艾比林(Abilene)或賓州霍默市(Homer City)等地現有的能源建設計畫,並調度鄰近電廠的剩餘電力。關鍵在於:

若有足夠的政治意志與政府資源挹注,原本對私人企業而言難以承擔的能源挑戰,就有可能在國家層級獲得妥善處理。

打造國家級 AI 巨人

若成功推進 AGI 的研發,其所帶來的經濟效益將具有顛覆性的衝擊。這場計畫中所誕生的運算技術、硬體創新與軟體架構,將廣泛應用於醫療、製造、交通、金融等幾乎所有產業領域。

對美國而言,AI 曼哈頓計畫將創造極具戰略價值的競爭優勢。如同曼哈頓計畫與阿波羅計畫確立了美國長達數十年的科技領導地位,AI 曼哈頓計畫亦可能在數位時代中達成同樣的效果。

龐大的專用硬體需求,將刺激半導體製造、散熱科技與資料中心設計等領域的快速創新。而在軟體層面,分散式運算、機器學習與系統工程等領域也將因應挑戰,推進至全新技術高度。

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐