VL-JEPA (上):思考不需言說的AI模型,如何在無聲中理解世界

論文: VL-JEPA: Joint Embedding Predictive Architecture for Vision-language

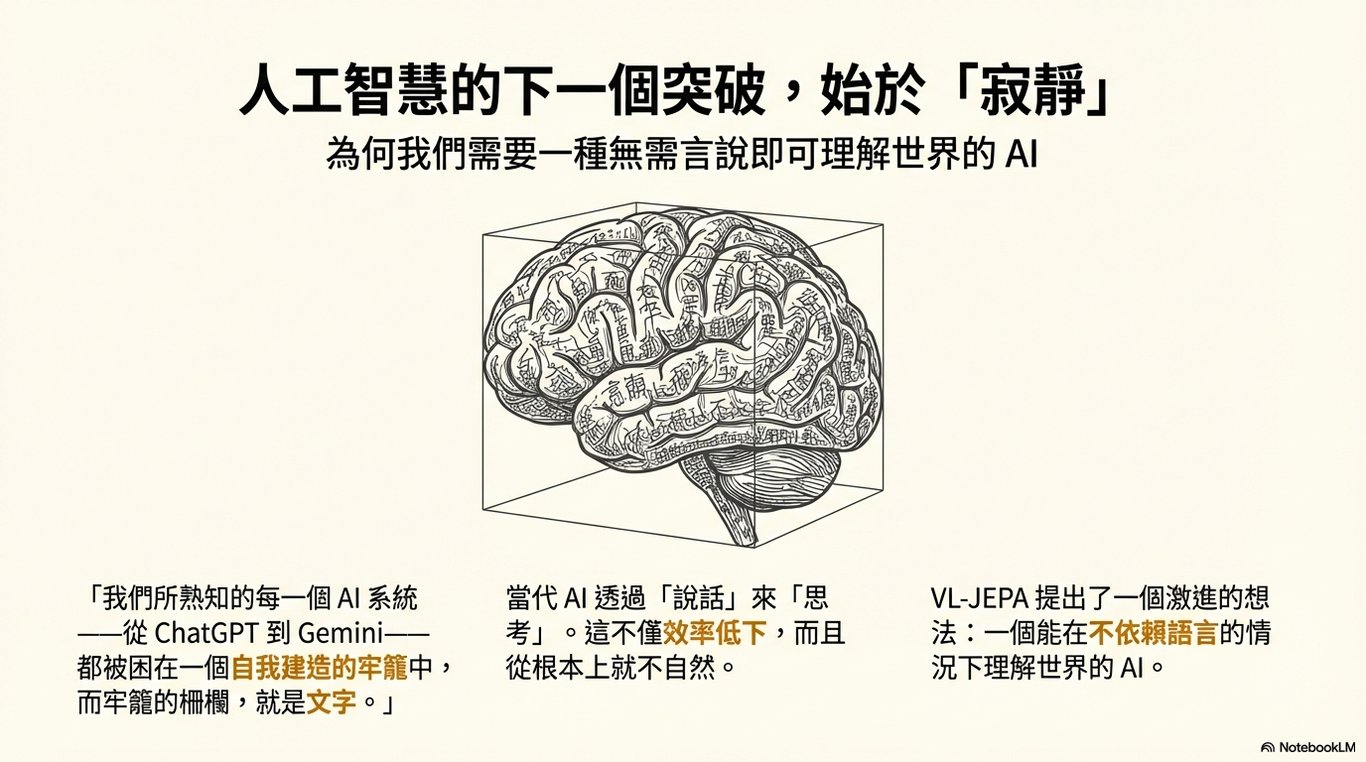

您曾想過,我們每天互動的 AI,如 ChatGPT,是否都被困在一個無形的牢籠裡?一個驚人的事實是:當今絕大多數的 AI 系統,都被囚禁在一個「由詞語構成的監獄」之中。

目前主流 AI 的運作核心,是「透過說話來思考」。這意味著,無論是圖像、影片還是複雜的現實場景,AI 都必須先將其轉換成文字描述,才能進行理解和推理。這個過程就像是要求一位音樂家,在腦中必須先把旋律唱成音符才能理解音樂一樣,既不直接也不自然。

但如果 AI 不需要語言就能思考呢?這正是本文將要探討的革命性模型——VL-JEPA (Vision-Language Joint Embedding Predictive Architecture)——所提出的核心思想。它試圖將 AI 從語言的束縛中解放出來,讓它學會在無聲中理解世界。在我們深入這項技術之前,讓我們先探討一下,為什麼傳統 AI 必須如此依賴語言?

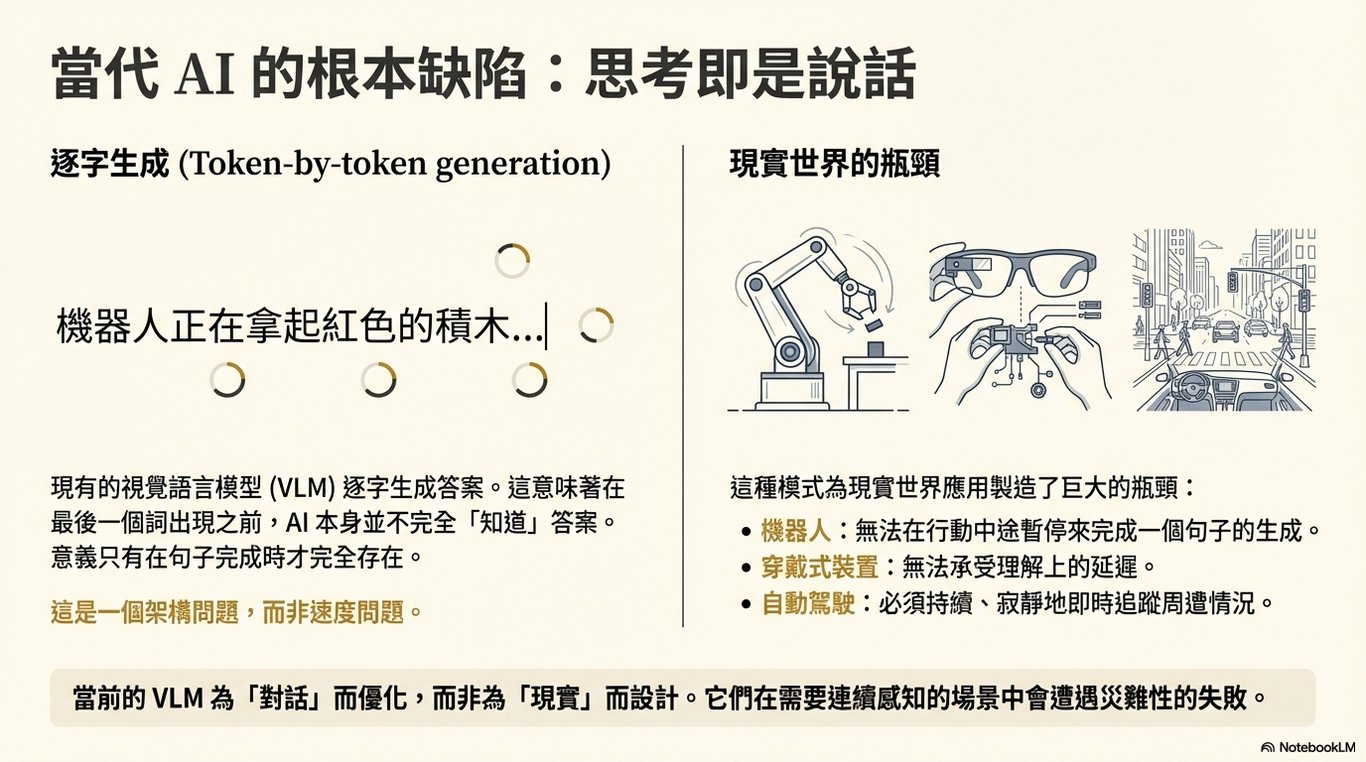

1. 為何傳統 AI 必須「喋喋不休」?

傳統的大型語言模型在生成答案時,就像一個謹慎的演說家,一次只說一個字 (token by token)。一個令人驚訝的事實是:在說出最後一個字之前,AI 自己其實並不知道完整的答案是什麼。 它的思考過程與文字的生成過程是同步的,意義只有在整句話完成時才會完全浮現。

這不僅僅是速度問題,而是一個深層的「架構問題」。這種「邊說邊想」的模式,在需要即時反應的現實世界中,會造成巨大的瓶頸,因為這些場景需要的是持續、無聲且即時的理解。

讓我們用一個簡單的類比來理解這個根本缺陷。當一個孩子走進房間時,他會先立刻理解整個場景——沙發在哪裡、電視開著、窗外有陽光。然後,他才學會用語言去描述這個場景。理解先於語言。 然而,目前的 AI 卻是反其道而行,它必須先在腦中「敘述」這個場景,才能「理解」它。

這種「先說後懂」的模式不僅效率低下,更不符合自然智慧的運作方式。正是為了解決這個根本問題,VL-JEPA 提出了一種全新的解決方案。

2. VL-JEPA 的革命:直接預測「意義」

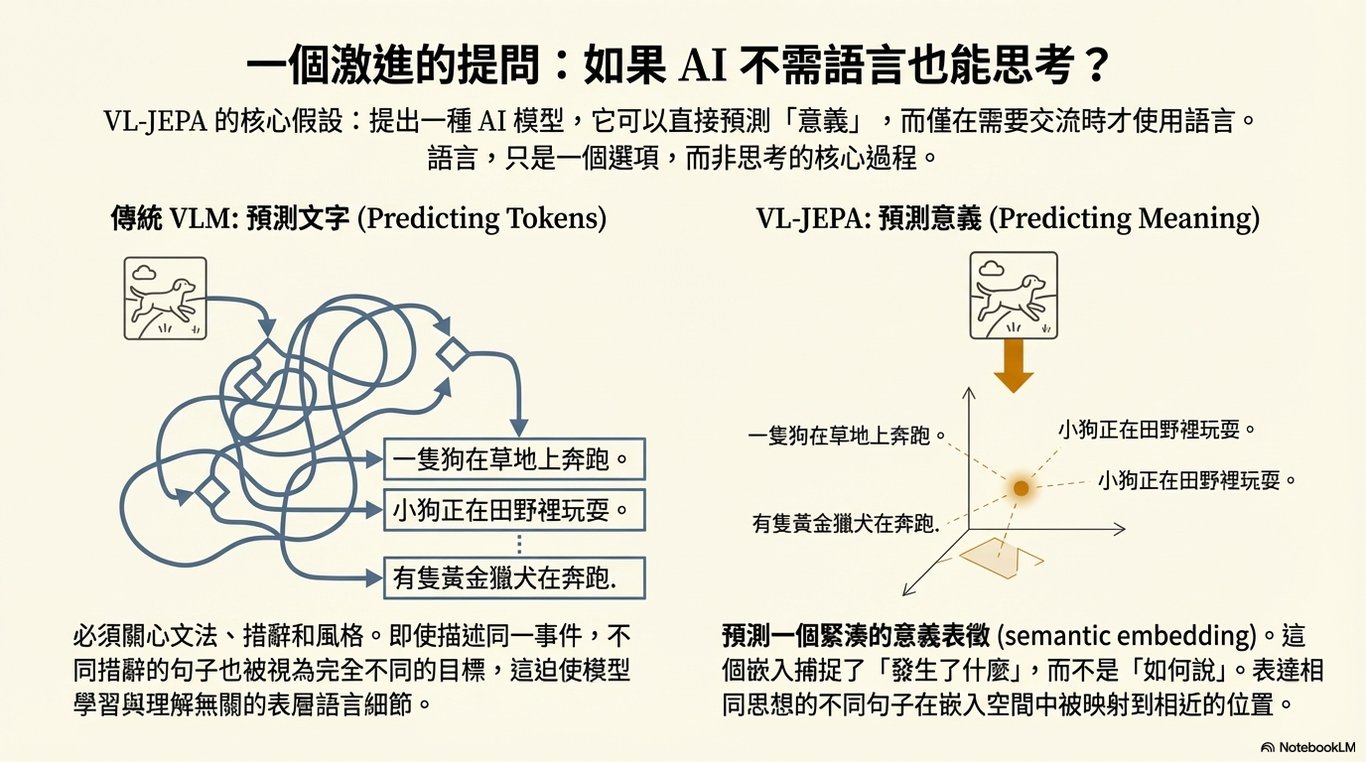

VL-JEPA 的核心思想極具革命性:它不預測下一個文字,而是直接預測意義的緊湊表示——即「語義嵌入 (semantic embedding)」。

但「意義」對電腦來說究竟是什麼樣子?它不是文字,而是一種數學座標——像是「思想圖書館」中的一個地址。它捕捉的是「發生了什麼」,而不是「如何用文字描述」。例如,「一隻狗在草地上奔跑」和「一隻犬科動物在草坪上慢跑」這兩句話,雖然用詞、語法和風格完全不同,但在語義嵌入的空間中,它們會被映射到非常相近的位置,因為它們描述的是同一個核心意義。

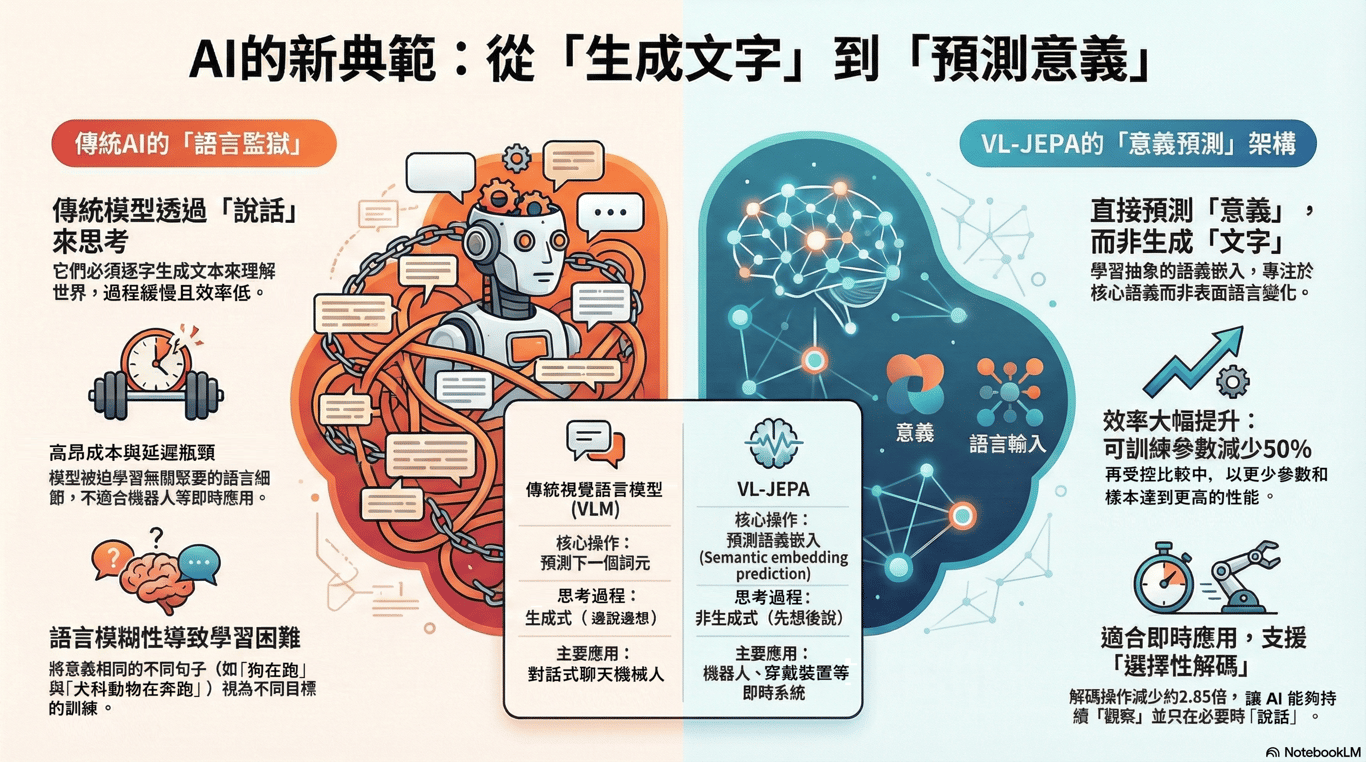

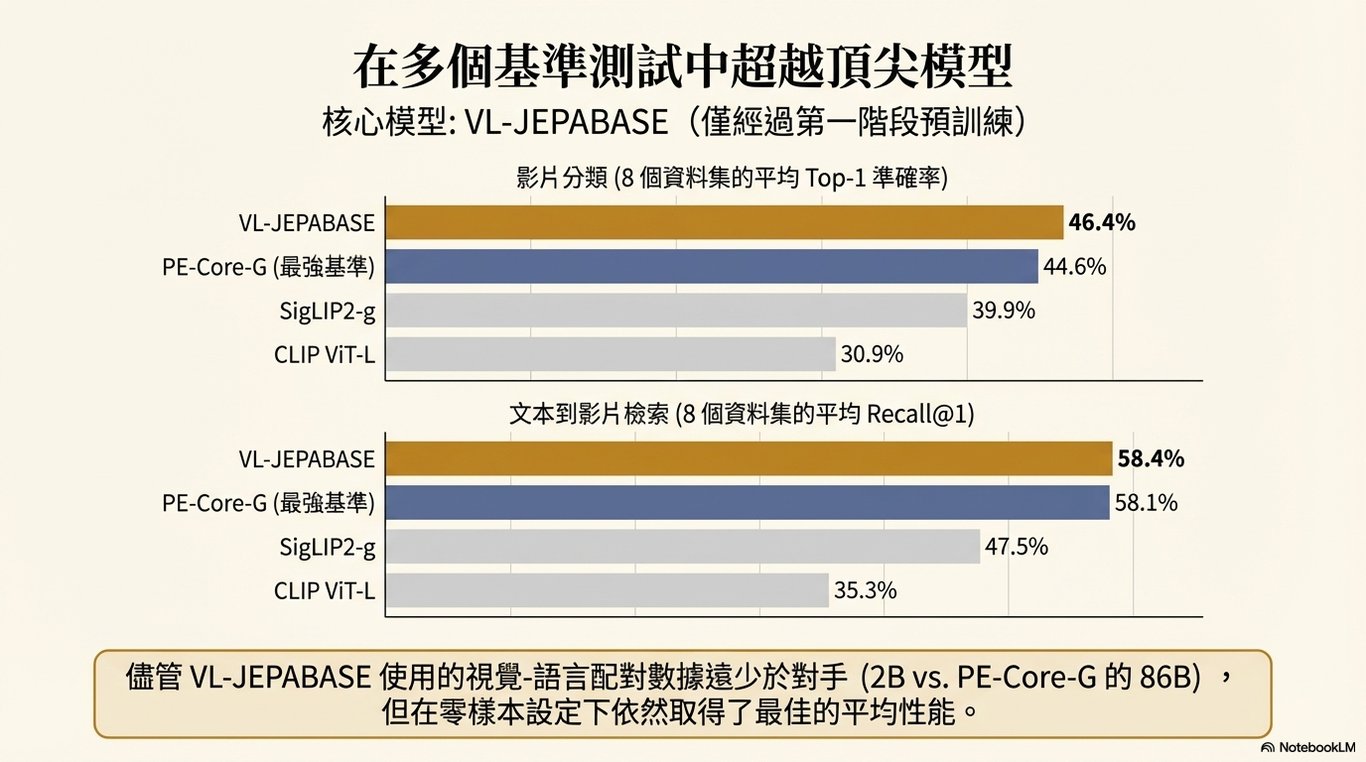

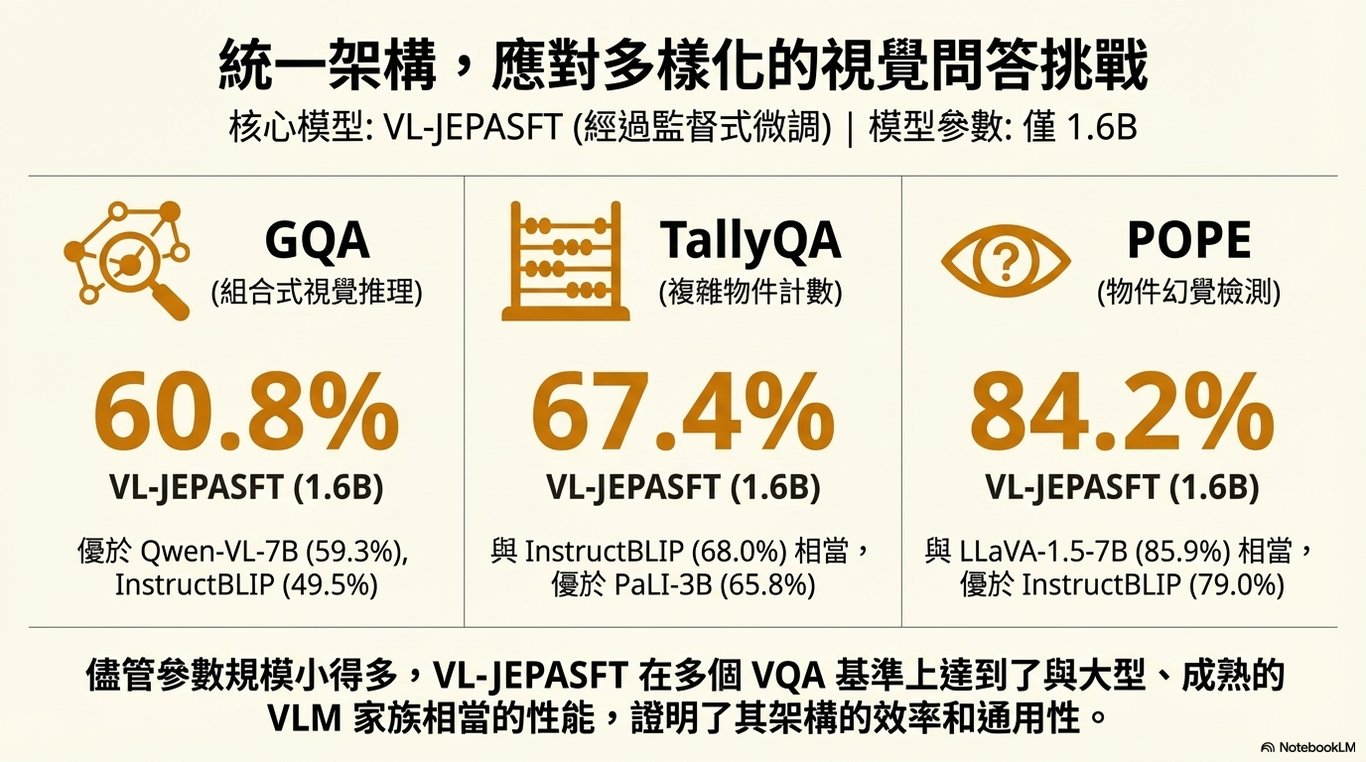

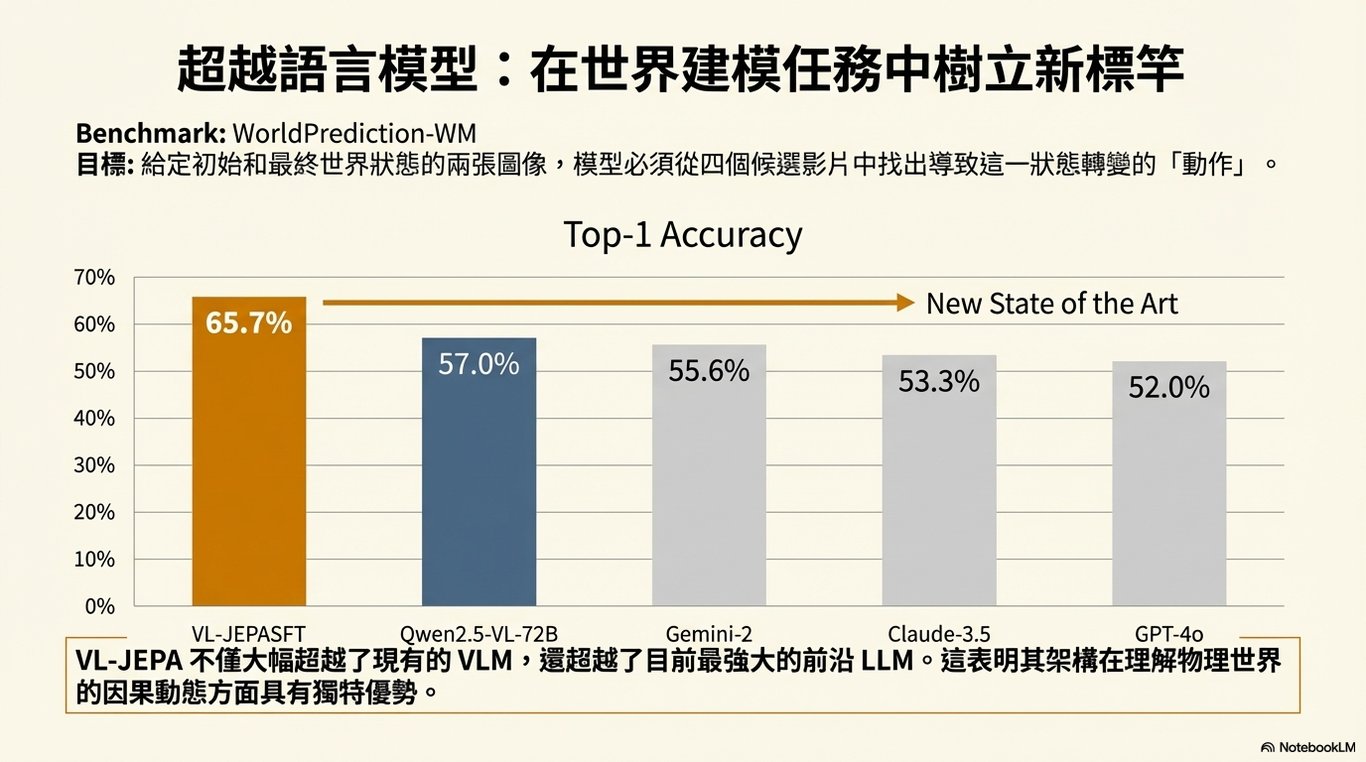

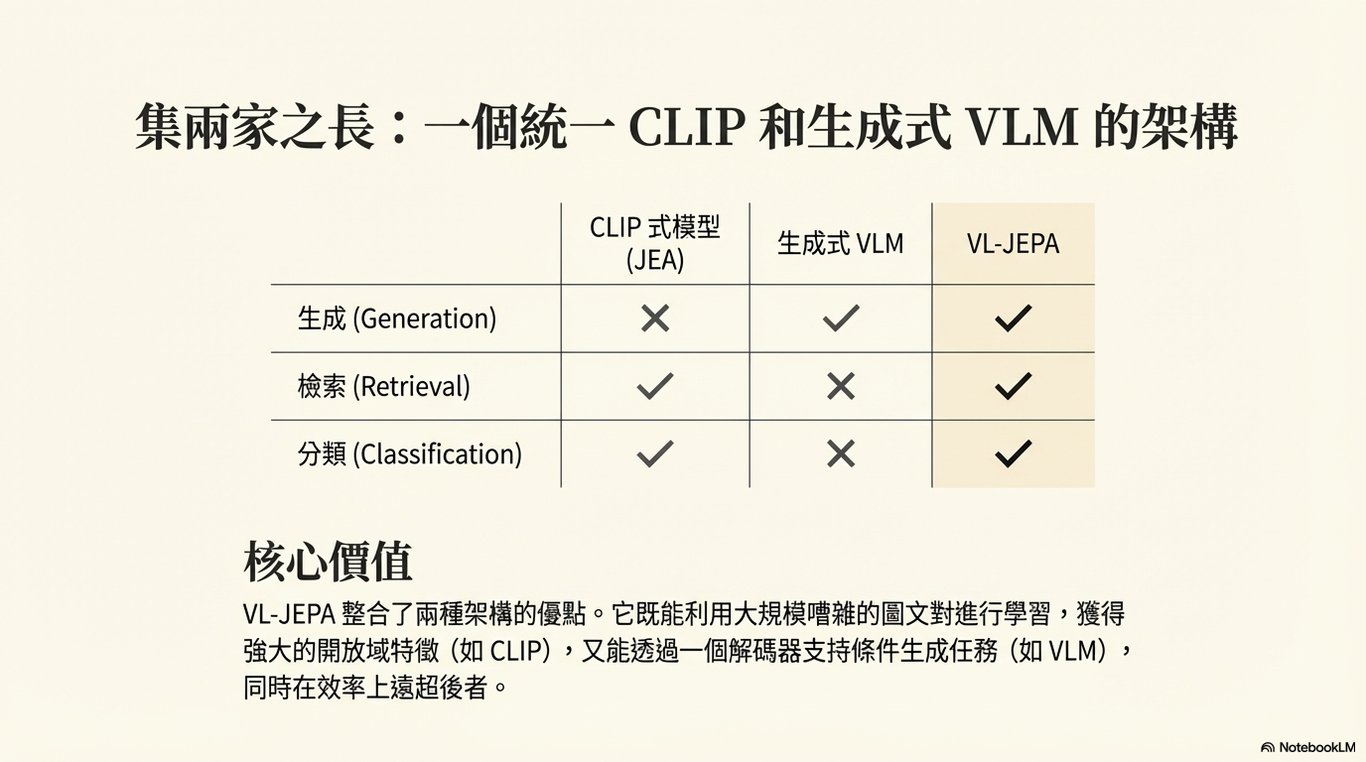

這種轉變從根本上改變了 AI 的學習方式。下表清晰地展示了傳統視覺語言模型 (VLM) 與 VL-JEPA 在學習目標上的巨大差異:

透過直接學習「意義」,VL-JEPA 不再被表面的語言變化所困擾,而是能夠更專注、更高效地理解視覺世界的核心內容。這種學習方式的轉變,為 AI 的訓練效率和最終性能帶來了顯著的提升。

3. 更聰明的學習方式:VL-JEPA 如何訓練

VL-JEPA 的架構不僅在概念上更先進,在訓練效率上也遠超傳統模型。其優勢主要體現在以下兩點:

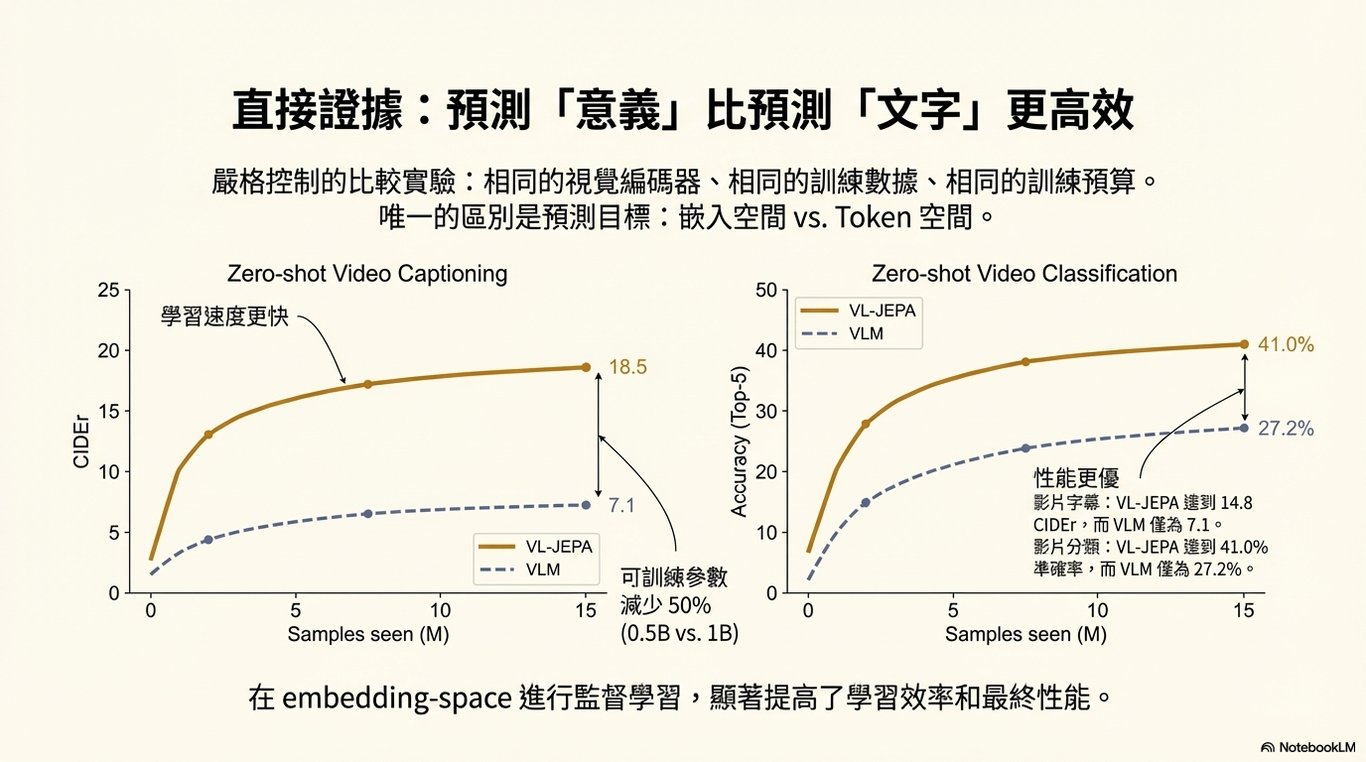

無需大型文本生成器: 在訓練期間,模型不必同時學習如何生成流暢、合乎語法的文本。這移除了巨大的計算負擔,更重要的是,它簡化了學習目標。傳統模型會因為選擇了「狗在跑」而非同樣正確的「犬科動物在慢跑」而受到懲罰,產生混亂的學習訊號。VL-JEPA 透過預測單一的語義目標,讓學習過程更穩定、更高效。

更少的參數,更強的性能: 根據研究論文的數據,在嚴格控制的比較實驗中,VL-JEPA 使用的可訓練參數比傳統 VLM 少了 50%,但性能卻更為出色。這證明了預測「意義」是比預測「文字」更根本、更高效的學習路徑。

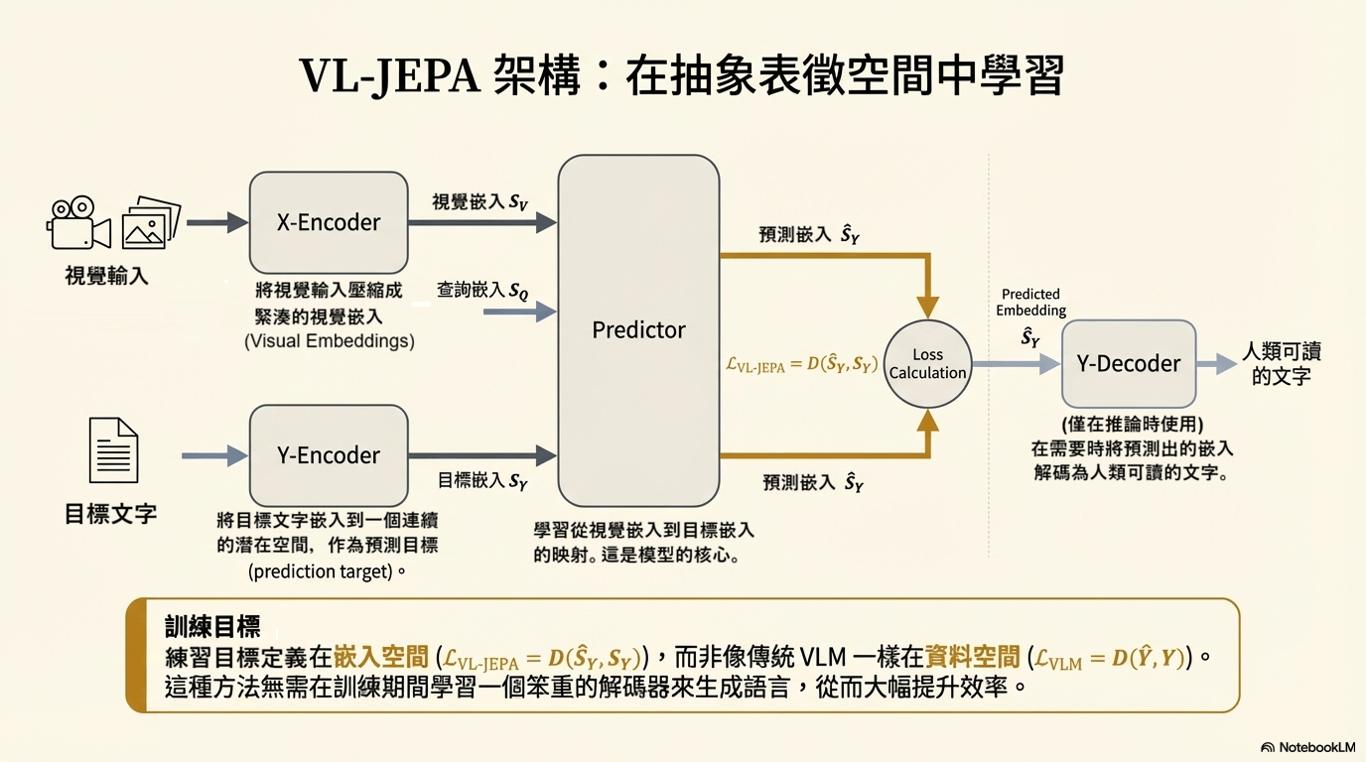

VL-JEPA 的簡化工作流程可以分為以下四個步驟,這也是其架構的核心:

X-Encoder (視覺編碼器): 接收視覺輸入(如影片中的一幀畫面),並將其壓縮成一個緊湊的「視覺嵌入」。這就像是 AI 對畫面內容的初步濃縮理解。

Y-Encoder (目標編碼器): 將目標文字(如影片的文字描述)轉換為「目標嵌入」。這個嵌入就是模型需要學習預測的最終「意義」。

Predictor (預測器): 這是模型的核心思考部分。它學習如何從「視覺嵌入」映射到「目標嵌入」的預測值。換句話說,它在學習如何「看見」一個場景,並直接「理解」其意義。

Y-Decoder (解碼器): 這個部分在訓練過程中是非必要的。只有在需要將 AI 的理解轉換為人類可讀的文字時,它才會被啟用,將預測出的「意義嵌入」翻譯成句子。

這種從「表達」到「理解」的架構轉變,並不僅僅是一項學術上的探索;它是解鎖 AI 在物理世界中安全、有效行動潛力的關鍵。

4. 無聲的力量:VL-JEPA 的現實世界應用

VL-JEPA 最重要的突破在於它賦予了 AI 一種在物理世界中持續感知和行動的能力。要理解這一點,我們必須先掌握一個核心區別:廉價的視覺系統標註影格;VL-JEPA 追蹤意義。

傳統模型像是在為世界拍下一張張快照並加上標籤,而 VL-JEPA 則是在觀看一部連續的電影,理解事件的來龍去脈。這種能力體現在以下幾個方面:

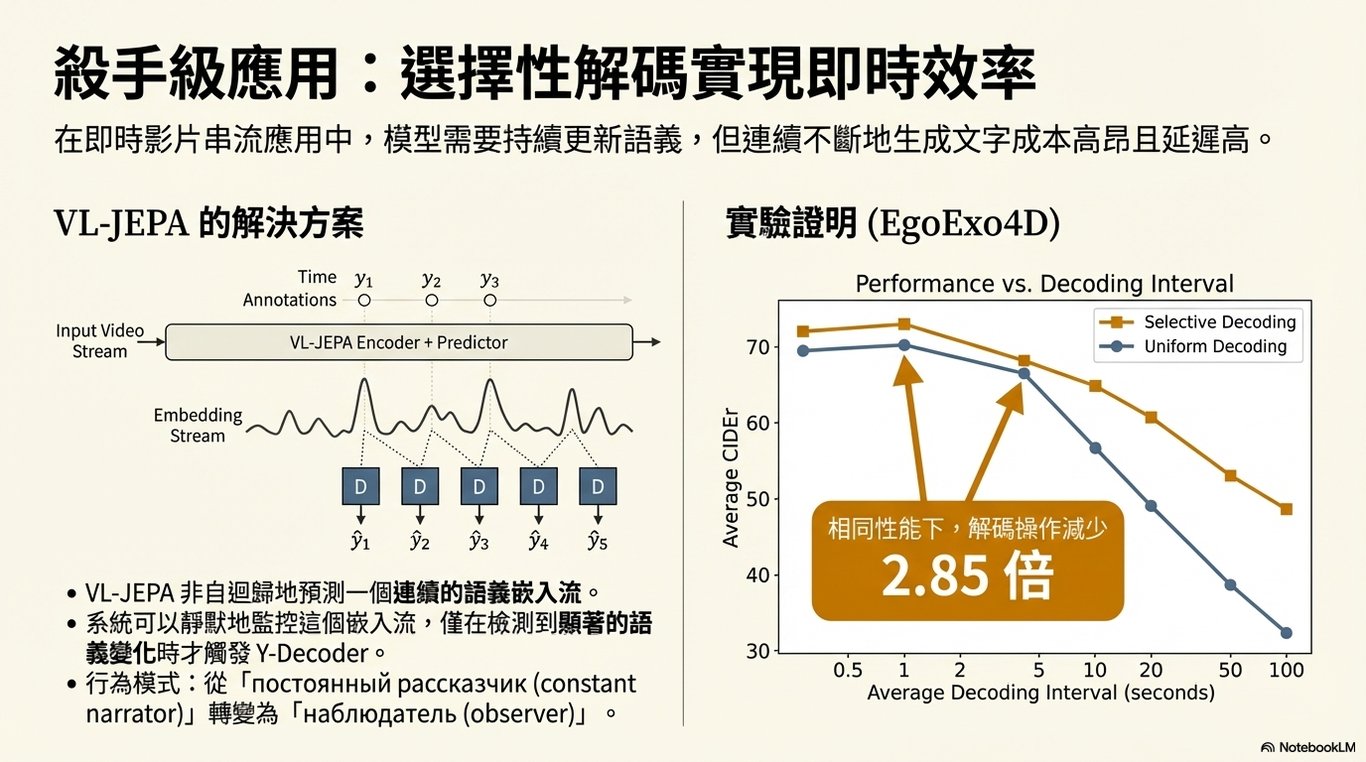

a. 選擇性解碼 (Selective Decoding)

傳統模型為了維持對世界的理解,需要不斷地生成文字描述,就像一個喋喋不休的「旁白員」。而 VL-JEPA 更像一個沉靜的「觀察者」。它能夠持續不斷地監控世界,只有當它偵測到重要的語義變化時(例如,一個新的事件發生),它才會啟動解碼器,「開口說話」。實驗證明,VL-JEPA 能夠達到每秒解碼一次的模型的相同性能,但實際上平均每 2.85 秒才需要解碼一次,大幅降低了延遲與運算成本。

b. 內建的時間感知能力

因為 VL-JEPA 在「追蹤」意義而非「標註」畫面,它天生就具備時間感知能力。它知道某件事何時開始、如何持續,以及何時結束。這種對時間的感知是其架構內建的,而非後續添加的技巧,使其能夠真正地「跟隨」事件的發展。

c. 關鍵應用場景

這種「無聲的持續性感知」能力,對於走出聊天視窗、進入物理世界的 AI 應用至關重要:

🤖 機器人: 機器人需要知道一個抓取動作何時開始、何時結束,而不是需要一句描述這個動作的句子。VL-JEPA 提供的連續性意義流,正是機器人執行精確操作所需要的。

👓 穿戴式裝置: 智慧眼鏡等裝置需要 即時理解周遭環境,無法等待 AI 完成一個完整句子的生成。VL-JEPA 的無聲理解能力使其成為理想的選擇。

🚗 自動駕駛: 自動駕駛系統必須持續追蹤周圍車輛和行人的動態,任何由文字生成引起的延遲都可能是災難性的。VL-JEPA 的持續性感知為此類高風險應用提供了更可靠的基礎。

VL-JEPA 的真正意義在於,它將 AI 從一個「對話夥伴」轉變為一個能夠在物理世界中感知、理解和行動的「智慧體」。

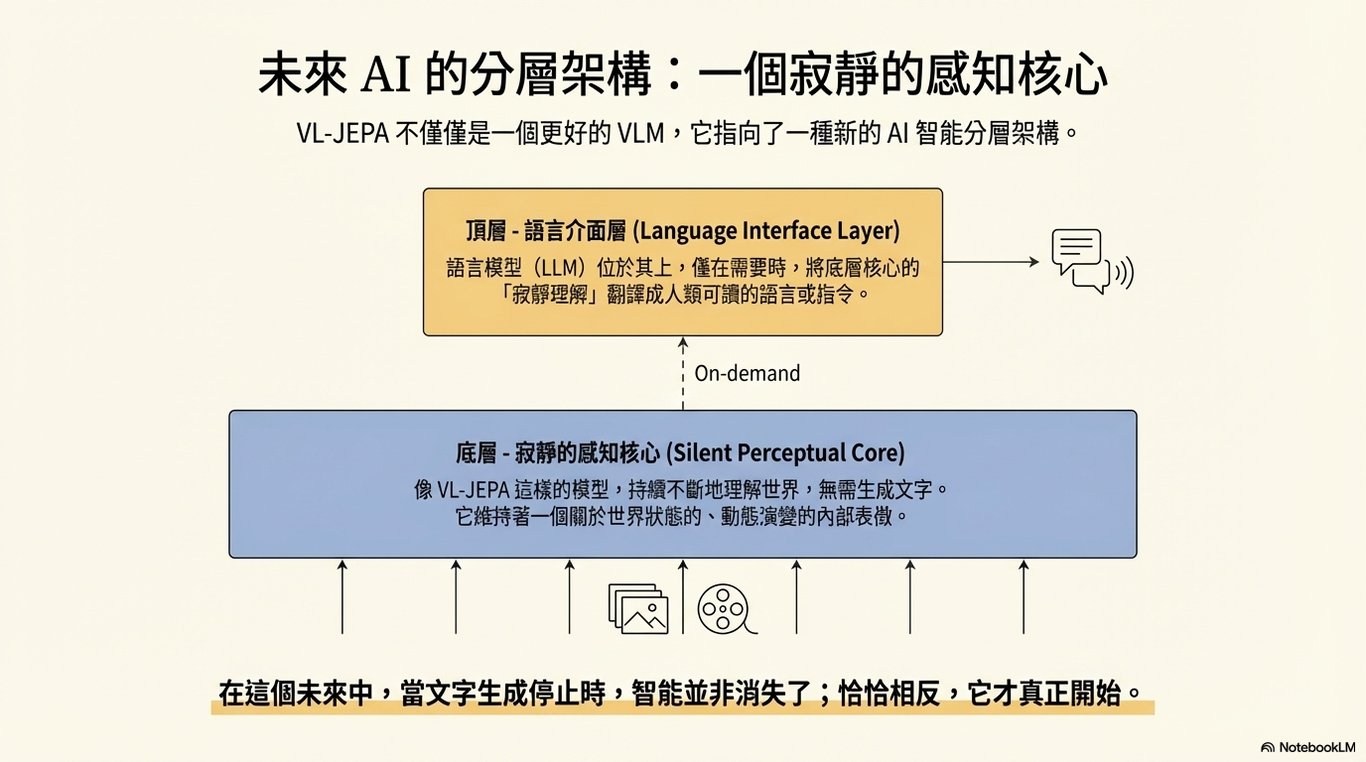

5. 總結:AI 的未來,始於無聲

VL-JEPA 並不是要把聊天機器人做得更會說話,而是在提醒我們:評估 AI 的進步,不能只看它說話有多順,而要看它到底「懂不懂這個世界」。真正重要的,是 AI 能否準確理解現實中正在發生的事情,而不是能不能講出漂亮的句子。

這項研究提出了一種更清楚、也更實際的 AI 架構想像:底層是一個像 VL-JEPA 這樣的「安靜感知系統」,它不斷觀察並理解現實世界;上層才是語言模型,負責在需要時,把這些理解轉換成人類聽得懂的語言。換句話說,語言不再是思考本身,而只是溝通的工具。

這樣的設計讓 AI 不再被「一定要說話」所限制。現實世界不在乎 AI 表達得多華麗,只在乎它是否理解得夠快、夠準。從這個角度看,能夠安靜理解世界,其實是一種更成熟、也更高層次的智慧,而真正的智慧,往往是在不說話的時候形成的。

PowerPoint

Media (English)

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!