📝📝:當前 AI 泡沫是 2008 金融危機四倍|相比 90 年代網路泡沫,更是達 17 倍

本文參考自研究機構 MacroStrategy Partnership 的研究報告《The AI bubble is 17 times the size of the dot-com frenzy - and four times the subprime bubble, analyst says》

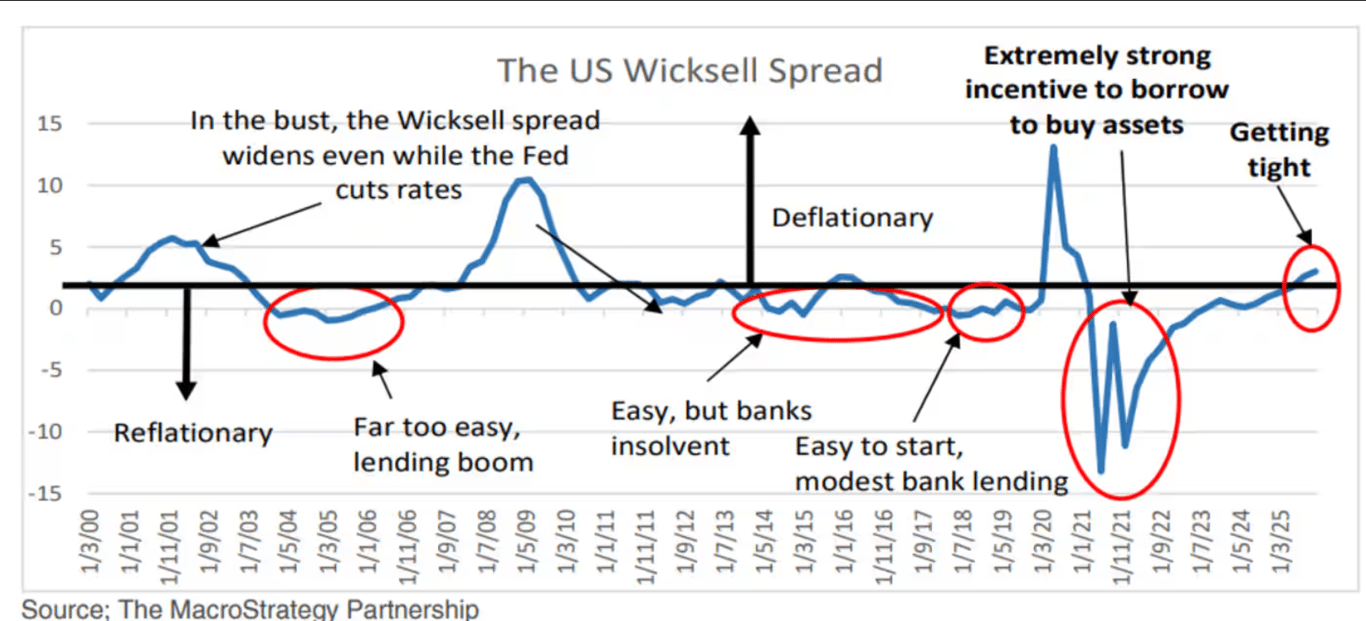

根據獨立研究機構 MacroStrategy Partnership 的分析(該機構為全球 220 家機構投資者提供顧問服務),當前的 AI 泡沫導致的資本錯配規模,比臭名昭著的網際網路泡沫高出 17 倍,甚至是 2008 年次貸危機的 4 倍。

這並非悲觀主義者的誇張說法,而是根據可追溯至 19 世紀的經濟理論所作出的量化分析,再結合當前人工智慧在技術與商業層面的明確侷限所得到的結論。

資本錯置的經濟理論

MacroStrategy Partnership 的分析師借鑑了瑞典經濟學家 Knut Wicksell 的理論。他的核心洞見在於:

當企業借貸成本大約高於名目 GDP 成長率兩個百分點時,資本才能得到有效配置。

這種平衡能自然抑制投機行為,當借貸成本與經濟產出相匹配時,只有真正具生產力的投資才值得融資。

但在過去十多年裡,這個自然機制被破壞了。美國聯準會的量化寬鬆政策將公司債利差壓低到不自然的水準,使資本成本遠低於經濟基本面所能支持的水準。分析師將這一現象稱為「威克塞爾赤字」(Wicksellian deficit) :

利率應該反映的經濟生產力與實際利率之間的缺口

MacroStrategy Partnership 由前瑞銀商品策略團隊的 Julien Garran 領導,對多種資產類別進行了 AI 生產力缺口的量化分析。

資本錯配不僅出現在 AI 領域,還包括住宅與商用地產、NFT、以及創投領域。以 GDP 比例衡量,這些由低利率催生的錯配資本,遠超過過去任何一場投機狂潮。

直到最近,威克塞爾關係才重新回到正軌;也就是說,十多年來首次,企業借貸成本再次高於名目 GDP 約兩個百分點。利率的正常化揭示了那些只在「免費資金」時代才合理存在的投資,而 AI 基礎建設正是最典型的例子。

運算能力不再保證效率

除了宏觀經濟框架外,該研究還指出了人工智慧技術本身的根本限制,動搖了整個大型語言模型的投資邏輯。

目前這些 AI 系統已經達到所謂的「擴展極限」(scaling limits) 意即,投入更多算力與資料已難以帶來相應的效能提升。

OpenAI 的 ChatGPT 系列正好體現了這一挑戰。

ChatGPT-3 的開發與訓練成本約為 5,000 萬美元;

ChatGPT-4 需投入十倍資金,達 5 億美元;

ChatGPT-5 的成本高達 50 億美元(相較第一代增加百倍),卻延後發布,且實際表現並未顯著超越前一代。

每一代模型都需要指數級的資源投入,但換來的性能提升有限。

這種「成本指數上升、效益對數增長」的曲線,對任何商業模式而言都難以為繼。Garran 認為科技巨頭已經踢到鐵板,他指出,人類語言的統計複雜性可能比研究者想像得更複雜,單純依靠增加訓練數據與參數規模,已無法持續改善模型表現。

當競爭者能輕易追上甚至超越你的模型時,技術護城河(protective moat)就不復存在,價格優勢自然瓦解。

AI 採用率開始下降

研究引用一家軟體公司的實驗,測量使用 AI 工具的任務完成率,結果僅介於 1.5% 到 34%。更糟的是,即使達到較高完成率,表現也缺乏穩定性與可重現性。

這種不一致性對商業應用而言是致命的。企業需要穩定可預測的工具,而一個星期二能完成 34% 任務、星期三卻降到 8% 的系統,根本無法成為生產流程的基礎。這種波動性本身就是一種風險,迫使人類介入監督,抵消了原本的效率提升。

根據 Apollo 經濟學家 Torsten Slok 以美國商務部資料為基礎的研究,大型企業的 AI 採用率實際上已開始下降。大型企業原本最具備資金、技術與應用場景,理應成為 AI 普及的主力。如果連這些機構都在退縮,意味著技術帶來的效益不足以支撐其成本。

甚至,當你要求 AI 影像生成器產出「五子棋的黑子在獲勝前的所有可能棋譜」,系統幾乎完全失敗。

這並非小問題,而是 AI 模型缺乏對空間關係、遊戲規則與邏輯序列的真正理解。這些系統只是依據資料模式進行比對與插值,無法在新情境中進行真正的「推理」。

沒有清晰的獲利途徑

即便 AI 系統能如宣稱般運作,至些工具依舊面臨嚴峻的商業化挑戰,形成所謂的「商業化陷阱」。

應用同質化

AI 生成的遊戲、娛樂內容或一般性創作工具,皆在競爭激烈的市場中運作,消費者期望免費或低價使用。當人類創作的替代品存在,或 AI 作品本身被商品化,使用者就沒有理由支付高價。

內容價值稀釋

許多 AI 應用僅是重組公開資料,如作業輔助、摘要生成或資訊查詢。雖具實用性,但難以產生足以支撐龐大基礎設施成本的經濟價值。使用者受益,但企業無法從中提取收益。

版權風險

當 AI 生成的文字、圖像、音樂或程式碼可能含有受版權保護的訓練素材,其法律風險與授權成本往往超出潛在收益。訓練資料讓系統更強大,同時也讓輸出結果在法律上變得難以商業化。

廣告模式難以奏效

傳統網路服務依賴用戶停留與互動來產生廣告效益,而 AI 工具的互動模式恰恰相反:使用者只想快速得到答案,然後就立即離開,無法創造可嵌入廣告的場景。

更嚴重的是,重度使用者帶來負單位經濟效益。那些最依賴 AI 工具的用戶,往往訂閱低價月費方案,但他們的查詢頻率與運算資源消耗卻極高,使服務商在每一次互動中都虧損。這顛倒了傳統軟體業的邏輯,反而讓最活躍的客戶反而成為最昂貴的負擔。

沒有定價權

傳統科技企業通常依賴網絡效應、專有資料或技術壁壘來維持競爭優勢,這些構成所謂的「護城河」,讓成功企業即使在競爭者出現後仍能維持高利潤。

然而,大型語言模型領域幾乎不存在這樣的保護機制。一旦某家公司展示出新功能,競爭對手很快就能複製。研究成果通常會公開,架構創新也會被迅速解析,訓練方法可被反向工程。像 Meta 等公司甚至將強大的模型開源,讓高階 AI 能力成為公共資源。

這種商品化在定價權出現前就已侵蝕了利潤空間。當客戶能從多家供應商獲得相似結果,價格就成為唯一區別,而在 AI 成本結構本就極薄甚至虧損的情況下,價格戰只會加速全行業虧損。

此外,先行者優勢迅速消失。企業投入數十億開發尖端模型後,其技術領先期往往僅以「月」計,而非「年」。當他們尚未收回開發成本、客戶基礎尚未穩固時,競爭者已用更低成本複製出同等水準的模型,因為他們避免了承擔前期昂貴的試錯成本。

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐